Технологические гиганты при помощи денег инвестиционных фондов

контролируют всё большую часть новых разработчиков и продуктов,

перекрывая тем самым путь для новых программ и новых технологий в

строительной отрасли.

Сегодняшние лидеры САПР-индустрии: Autodesk, Hexagon,

Nemetschek, Bentley, Trimble - хорошо готовятся к будущим угрозам:

стандартной тактикой больших корпораций стал агрессивный захват

новых рынков и поглощение возможных конкурентов на ранних стадиях

развития.

В результате вся САПР-индустрия стала похожа на олигополию, в

которой доминирует группа из нескольких компаний. И их положение на

вершине становится всё более непоколебимым.

Содержание:

-

BlackRock - хозяин всех

технологий

-

Олигополия на рынке

САПР

-

Autodesk идёт по стопам

Oracle

-

Почему программы не

развиваются

-

Борьба корпораций с open

source

-

Autodesk и формат данных

IFC

-

Проблема Autodesk -

организация открытых стандартов - ODA

-

В

заключение

Олигополия в САПР

В этой статье мы рассмотрим:

-

кто сегодня руководит развитием новых технологий в

строительстве

-

как происходит синхронизация политики между САПР-вендорами

-

почему компании не развивают программы, написанные в 90-е

-

как большие корпорации контролируют open source

разработчиков

-

почему IFC и Dynamo - это непрозрачный open source

-

как благодаря Autodesk появился альянс ODA

-

как велась борьба за формат DWG между ODA и Autodesk

-

как сегодня развивается борьба за открытость форматов RVT и

RFA

-

как BlackRock и Vangaurd создали плановую экономику на мировом

уровне

BlackRock - хозяин всех технологий

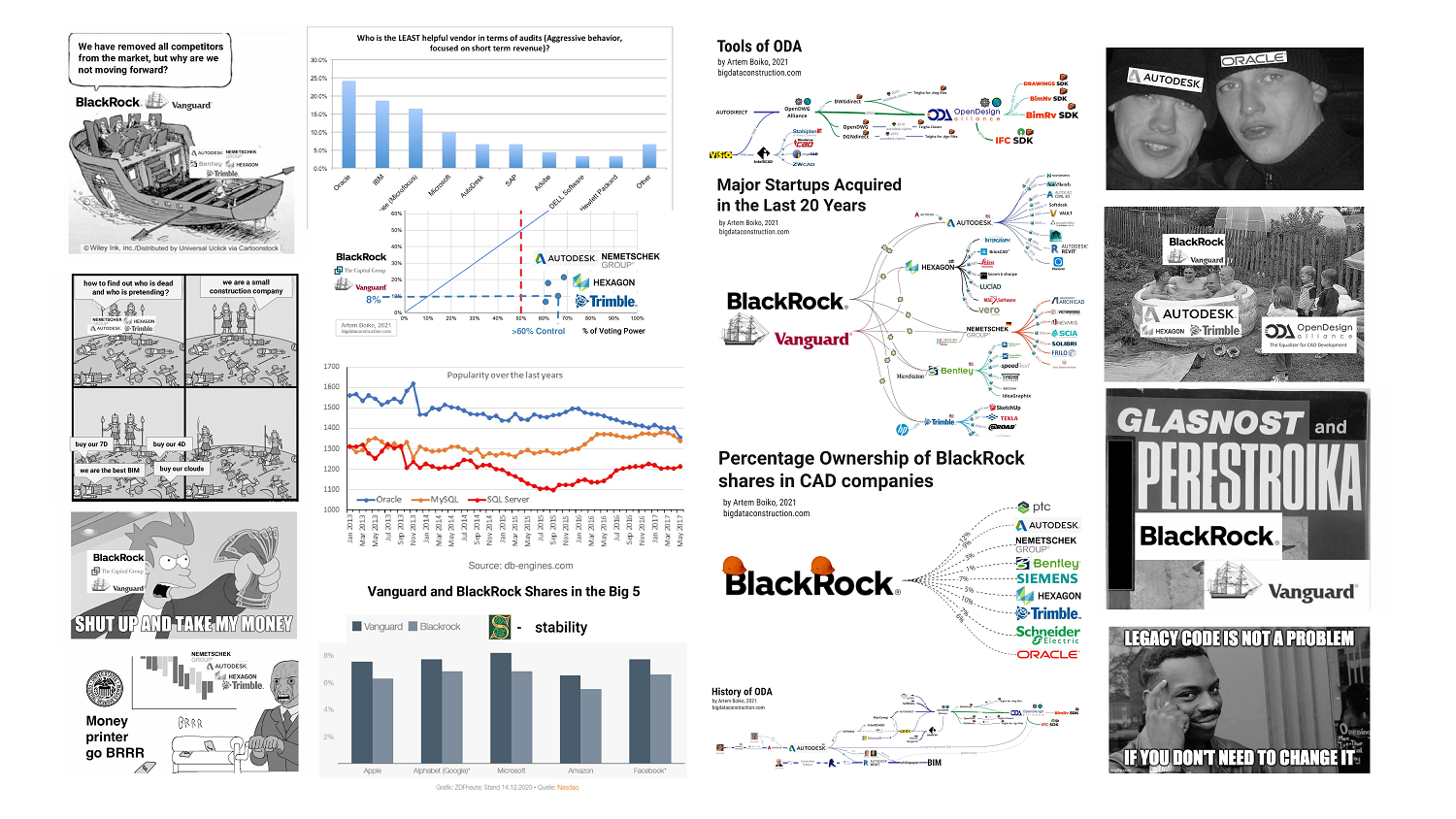

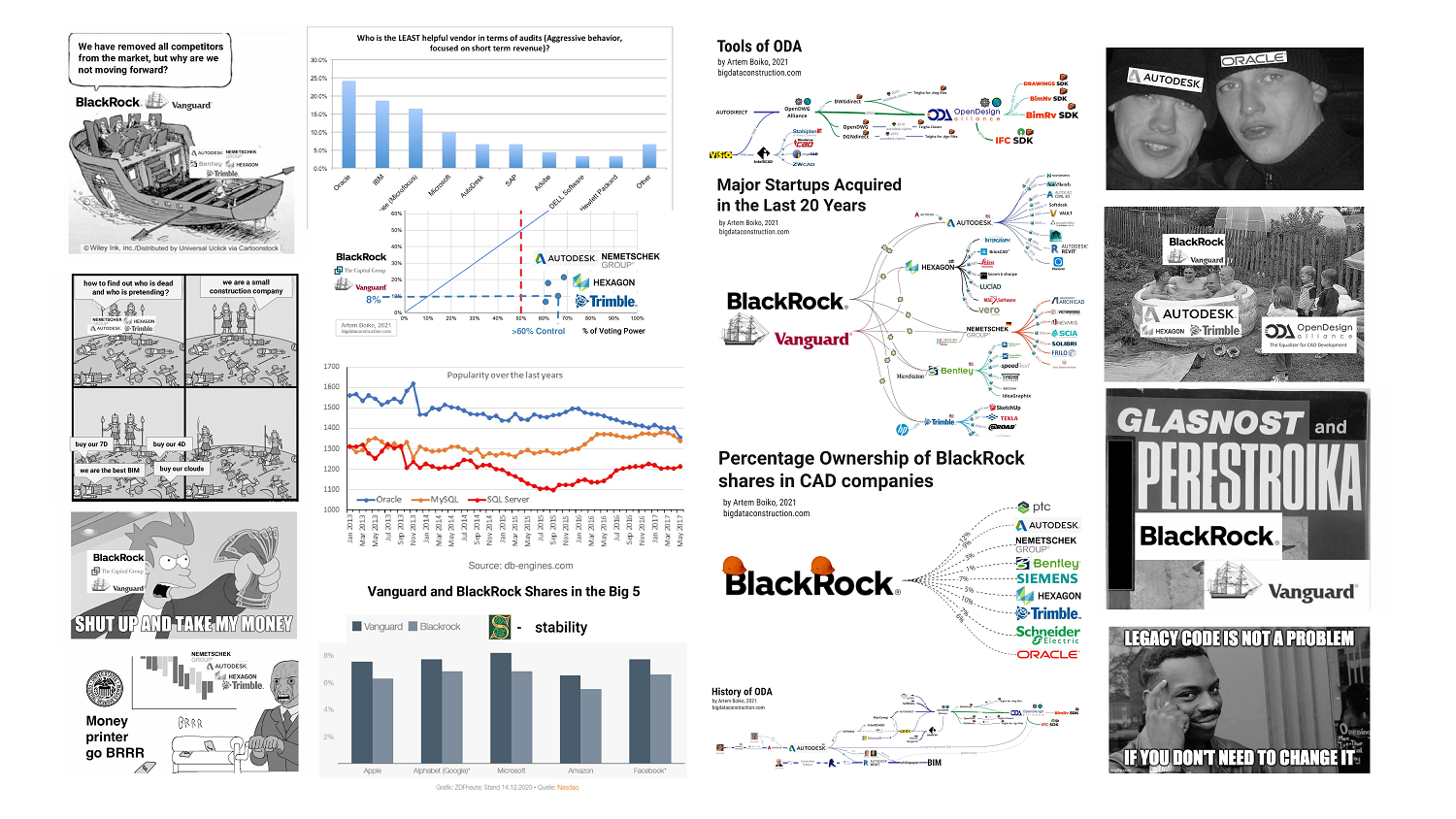

Основа олигополистической структуры в строительном

проектировании - это большая пятёрка САПР-вендоров: Autodesk,

Hexagon, Trimble, Bentley, Nemetschek.

Эти компании выходили с середины 90-х на IPO (initial public

offering), распродав большую часть своих

акций среди крупнейших инвестиционных фондов Соединённых

Штатов и распределив тем самым ответственность за будущее компаний

среди держателей акций.

Данные о держателях долей в уставном

капитале (только материнские компании, за исключением владения

фондами небольших дочерних компаний)

Главными бенефициарами (и держателями акций) от выхода

САПР-компаний на биржу стали три американских инвестиционных фонда:

The Capital Group, Vanguard и BlackRock, которые на протяжении

последних 30 лет скупали акции технологических компаний напрямую

или через свои банковские филиалы.

Акционеры крупнейших CAD-компаний

Мало кто слышал о BlackRock, но эта фирма является крупнейшей

инвестиционной компанией, под управлением которой находятся активы

стоимостью в $8,7 трлн в 2021 году (в

2015 году - $4,6 трлн). На 2021 год BlackRock, штаб-квартира

которой расположена на Манхэттене, имеет отделения в 100 странах, и

она тесно связана с крупнейшими финансовыми регуляторами, такими

как министерство финансов США, Федеральная резервная система (ФРС)

США и Европейский центральный банк (ЕЦБ).

Как только какой-либо крупный экономический субъект попадает в

поле зрения таких фондов, как Vanguard и BlackRock, они предлагают

ему возможности выгодных инвестиций. Пользуясь своей надёжной

репутацией, связями и огромными средствами, Vanguard и BlackRock

скупают активы субъекта и начинают заниматься его управлением.

Например, только в Германии в 2014 году BlackRock

принадлежало 4% акций BMW, 5,2% акций Adidas,7% акций Siemens, 6%

акций Daimler. В целом BlackRock является акционером (почти всегда

самым крупным) всех предприятий, входящих в индекс DAX (важнейший

фондовый индекс Германии).Гигантская платформа Aladdin, созданная

BlackRock для управления активами, ежесекундно отслеживает

стоимость акций, облигаций и других активов, находящихся под

управлением компании, а также рассчитывает, как влияют на их

котировки различные события, такие как рост цен на нефть или

алюминий.

BlackRock является мажоритарным акционером почти во всех

технологических компаниях мира. Какое отношение к строительству и

проектированию имеют инвестиционные корпорации BlackRock и Vanguard

(Vanguard/Windsor)?

BlackRock и Vanguard принадлежат почти все САПР-компании и

технологии в мире строительного проектирования и BIM решений.

Доля владения акциями BlackRock и

Vanguard в компаниях САПР

На графике владения акциями заметно, что особым смыслом здесь

обладает цифры - 7-10%. До таких цифр инвестфонды доводят долю

владения любой компанией, чего хватает, чтобы полностью

контролировать целые корпорации.

На следующем графике видно похожее распределение владения

акциями крупнейших компаний мира - Big 5.

Доля владения акциями BlackRock и

Vanguard в компаниях Big 5

Из-за того, что 70% акций компании после выхода на биржу

распределены между тысячами инвесторов, контрольный пакет

составляет всего 720% акций, что даёт держателю небольшого пакета

полномочия по принятию всех решений в компании.

Степень контроля (X - сила голоса) в

компании в зависимости от вечеличины пакета акций (Y - процент

капитала)

Таким образом, если у вас есть 7-20% акций нескольких основных

компаний-монополистов, то вы почти полностью влияете на развитие

всей отрасли.

При таком многократном перекрестном владении и при наличии долей

практически во всех крупных корпорациях - как этим инвестиционным

фондам удаётся следить за темой BIM или, например, развитием AR в

строительстве, да и вообще за всеми технологиями мира

одновременно?

Олигополия на рынке САПР

Олигополия в первую очередь означает скоординированность и

взаимосвязь в действиях на рынке, что осуществляется Vanguard и

BlackRock через глав компаний, утверждаемых на собрании

акционеров.

Доля доли BlackRock в компаниях САПР

С выходом на биржу большие САПР-компании фактически убили

конкуренцию на рынке САПР тем, что основные стратегические решения

теперь принимаются не агрессивными руководителями компаний, которые

борются за выживание и место на рынке, а пролоббированным советом

директоров, который контролируется извне финансовыми специалистами,

интересующимися отраслью строительства только как цифрой в годовом

отчёте Annual Revenue.

Политолог Jan Fichtner из Амстердамского университета, исследуя этих основных

финансовых игроков, утверждает: Влияние в основном

осуществляется через фоновые дискуссии. Вы ведете себя на поводу у

BlackRock и Vanguard, потому что знаете, что однажды вам может

понадобиться их благосклонность. Для руководства компаний и

корпораций рационально действовать в интересах основных

держателей акций.

"Там, где есть договор, есть перочинный нож."

Шарль-Морис де Талейран-Перигор

Все, кто работает в развитии технологий строительной отрасли,

постепенно попадают в жернова этой плановой экономики, созданной

акулами капитализма при поддержке богатых династий запада,

пенсионных фондов и печатного станка ФРС.

BlackRock управляет активами

централизованно и строго следит за соблюдением всех

формальных предписаний. Но сверх этого BlackRock и Vanguard

практически ничего не делают. А

между тем для функционирования рыночной экономики чрезвычайно

важно, чтобы акционеры постоянно держали руку на пульсе событий в

своих предприятиях и критически оценивали политику менеджмента.

В итоге сегодня все мировые САПР (и вообще все технологические)

компании принадлежат инвестиционным фондам, которые на бумаге

занимаются управлением стратегией компании, а де-факто - только

соблюдением формальных предписаний для отчётов, которые позже

попадают в красивый PDF документ для ежегодного собрания совета

директоров.

"Плановая экономика в масштабах сколько-нибудь крупной

промышленной системы требует значительной централизации, а

следовательно, и бюрократического аппарата, способного управлять

этой централизованной машиной. Если планирование сверху не будет

сочетаться с активным участием снизу, если поток общественной жизни

не будет постоянно восходить снизу вверх, плановая экономика

приведет к новой форме манипулирования народом."

Бегство от свободы, Эрих Фромм

Как сегодня Trimble будет соперничать с Autodesk или Hexagon на

одном рынке, если CEO этих компаний отчитываются ежеквартально

перед одними и теми же инвестиционными фондами с WallStreet,

которые, в свою очередь, не заинтересованы в резких изменениях на

тех рынках, от которых зависят их годовые отчёты и, как следствие,

их личные бонусы.

Нет здоровой конкуренции - не будет и новых технологий. Отчасти

поэтому все крупные корпорации в мире строительного проектирования

фактически не имели отношения к разработке новых продуктов в

последние 20 лет.

Если ещё десять лет назад такие крупные компании, как Autodesk,

Nemetschek, Trimble имели репутацию уже не новаторов, а скорее

имитаторов, когда было достаточно просто скопировать новый

популярный продукт и выпустить свой клон, то сегодня необходимость

в клонировании продуктов отпала. Сегодня стартапы и целые компании

скупаются за любые

деньги, которые предоставляют своим подопечным BlackRock и

Vanguard.

Чтобы не конкурировать друг с другом на одном рынке, каждая

компания из big5 САПР выбирает для себя отдельные технологические

ниши и скупает постепенно программы и любые технологии в этом

направлении.

Основные стартапы, приобретенные за последние 20 лет

Для примера John Walker (будущий CEO Autodesk) предлагал

Mike Riddle купить Autocad в 1982 году всего за $15 тыс.

(изначально за $8 тыс.), но Mike настоял на условиях продажи

Autocad за 1$ и 10% c продаж

продукта. В 2020 году Revit стал самым продаваемым

продуктом Автодеск, который она купила в 2002 году за 133 млн

долларов. А уже в 2018 году Autodesk заплатил за Plangrid

(стартап-приложение для планшета) почти миллиард долларов

($875 млн),

где одним членом из совета директоров, за несколько лет до покупки,

стала бывшая CEO Autodesk - Carol Ann Bartz.

Таким образом, на данный момент весь мир проектирования и вообще

все технологии мира разделились на тех, кто принадлежит Blackrock и

Vanguard, и тех, кого эти фонды через свои САПР-филиалы ещё купить

не успели. Ни одна организация с высокими денежными показателями не

имеет возможности избежать встречи с такими финансовыми гигантами,

в какой бы стране она ни находилась.

Сегодня уже невозможно построить новый Autodesk или Trimble в

нашем мире, где с такими ресурсами, которыми располагают сегодня

инвестфонды, можно купить целые страны, не говоря уже о талантливых

командах разработчиков.

Мы убрали с рынка всех конкурентов, но

почему мы не движемся вперед?

!Нельзя ни в коем случае демонизировать структуры, которые

были построены BlackRock и Vanguard: любая организация и скорее

всего каждый человек на земле, имея такие бесплатные ресурсы и

доступ к печатному станку, воспользовались бы этим и поступили бы

на месте Blackrock точно так же, скупая всё на своём пути.

В противовес монополиям, только мир open source решений мог бы

сегодня составить конкуренцию таким олигопольным конгломератам.

Посмотрим дальше на то, как большие корпорации пытаются

контролировать open source движение.

Для чего мировым вендорам САПР нужны тысячи специалистов по

базам данных, oб open source решениях, а также о решениях, над

которыми работают основные вендоры САПР, поговорим в седьмой

части.

Чтобы к седьмой части немного лучше понимать нового игрока на

рынке САПР - Oracle, базы данных и open source, а также из-за

схожести поведения двух компаний - сравним историю Oracle с

историей развития Autodesk и посмотрим на то, как эти две

корпорации боролись с open source движениями на своём рынке.

Autodesk идёт по стопам Oracle

История Autodesk, одного из лидеров САПР-мира, начинает всё

больше походить на историю такого лидера своего времени, как

Oracle. Так же, как Autodesk с Autocad была последние 30 лет

мировым лидером 2D-проектирования, Oracle, в это же время, была

мировым лидером баз данных - DBMS систем (database management

system).

Прибыль Oracle от бизнеса, построенного на хранении данных,

примерно в 10 раз больше, чем продажи лидеров САПР-отрасли: годовой

оборот Oracle сегодня - $20 mlrd., а у Autodesk - всего $1,7 mlrd..

Как и во всех технологических компаниях мира, ведущими акционерами

Oracle (как и Autodesk, Trimble, Apple, Microsoft и почти всех

компаний на земле) являются две крупнейшие в мире инвестиционные

компании - Vanguard и BlackRock.

Во многих статьях говорится, что Oracle была основана в конце

1970-х и что Oracle продает линейку программных продуктов, которые

помогают крупным и средним компаниям управлять своей деятельностью.

Но везде каким-то образом игнорируется тот факт, что Oracle всегда

была значительным игроком в индустрии национальной безопасности. И

что его основатель не заработал бы свои миллиарды, если бы не

помогал создавать инструменты

современной государственной и мировой слежки.

Как многие основные компании, выросшие после холодной войны,

обязаны своим развитием федеральным и оборонным контрактам, так и

Oracle на самом деле берет свое название от кодового названия проекта ЦРУ

1977 года. И именно ЦРУ было первым заказчиком

Oracle.

C середины 2000-х Oracle начинает активно интересоваться

строительной отраслью. Примечательно, что Oracle стал

стратегическим партнёром buildingSMART в 2019

году, за один год до того, как главный САПР-производитель

Autodesk

присоединился к buildingSMART в 2020 году.У Oracle

есть все шансы, чтобы стать лидером BIM-технологий. Об

этом и почему BIM - это базы данных, поговорим подробнее в седьмой

части.

В какой-то момент большие технологические компании выросли в

большие структуры, которые, как и все крупные и сложные структуры,

однажды перестали активно заниматься разработкой новых

технологий.

Как в открытых письмах лучших архитекторов мира, адресованных

Autodesk, (подробнее об этом в Часть 4: Борьба CAD и BIM. Монополии и

лоббисты в строительной отрасли), так и в подкасте с Еленой

Слеповой - мы все отмечаем, что Autodesk почти не развивает

основной продукт Revit, а занимается только дизайном и

украшательством интерфейса, попутно покупая новые стартапы

(Navisworks, Assemble, Vault, Civil 3D) и технологии.

Открытое письмо архитектурных бюро мира

Autodesk о том что продукт Revit не развивается

Раздражение проектировщиков продуктами Autodesk растёт от версии

к версии, но большие корпорации: Autodesk, Nemetschek и другие

крупные покупатели стартапов - не могут привнести в код купленных

программ значительных изменений.

Почему программы не развиваются

Любой большой

программный продукт, разрабатываемый больше пяти лет,

напоминает длинный "спагетти-код". При этом только несколько

главных разработчиков в компании знают, как работает (максимум) 70%

кода в такой программе, как Oracle Database, Autocad, Revit или

Archicad.Новые инструменты от Autodesk, Nemetschek или Oracle

сегодня являются лишь попыткой скрыть накопленные проблемы от

разработчиков, потому что справиться с ними стало невозможно.

Затухание активного роста в техническом плане начинается с ухода

разработчиков на более высокие должности или, что происходит чаще,

с Exit основных разработчиков, которые забирают деньги (после

продажи стартапа или выхода компании на IPO) и сами становятся

венчурными инвесторами.

После Exit главных разработчиков большое количество костылей, из

которых состоят эти программы, в последующих проектах создают

трудно выявляемые баги, которые заваливают всю дальнейшую

разработку продукта. Такой продукт, или, точнее, код, из которого

он состоит, обозначают как legacy code.

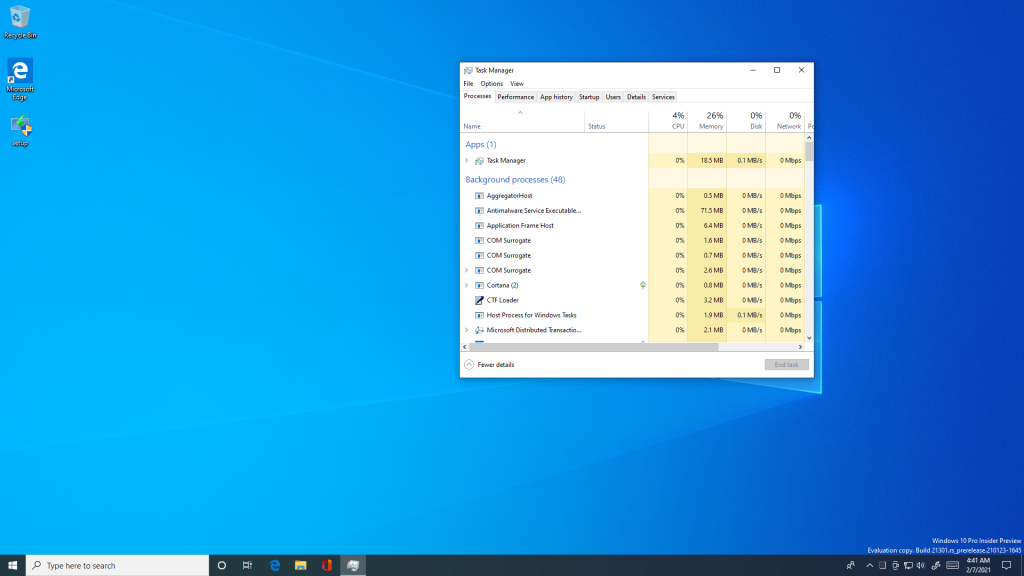

Legacy code (от Legacy (англ.) наследство) устойчивое

выражение, обозначающее старый код без каких-либо пояснений;

главным его признаком является отсутствие возможности в нём

разобраться.

Legacy code не проблема - если тебе не

нужно поменять его

На примере Oracle можно представить, в чём же состоит сложность

Legacy кода и почему программы из 90-х почти не

развиваются в последнее время.

Объем кодовой базы Oracle Database в период разработки версии

12.2 в 2017 году составлял 25

миллионов строк на языке C и стоит вам изменить лишь одну

из этих строк, как ломаются тысячи написанных ранее тестов. За

прошедшие годы над кодом Oracle Database успело потрудиться

несколько поколений программистов, которых регулярно преследуют

жесткие дедлайны, благодаря чему код превратился в настоящий

кошмар.

Интерфейс - Геометрическое ядро. Мы не

знаем как это работает, но если удалить это приложение рухнет

Сегодня код любой программы из 90-х состоит из сложных кусков

кода, отвечающих за логику, управление памятью, переключение

контекстов и многое другое; они связаны друг с другом при помощи

тысяч различных костылей. В итоге, у разработчика может уйти день

или два только на то, чтобы

разобраться, чем же в действительности занимается та или иная

строка кода.

Возникает вопрос: каким же образом при всем этом Oracle Database

(или Revit, Archicad) до сих пор удается держаться на ногах? Секрет

в миллионах тестов. Их полное выполнение может занимать от 20 до 30

часов (при этом выполняются они распределенно на тестовом кластере

из 100-200 серверов), поэтому сегодня процесс исправления одного

единственного бага в Oracle Database занимает от нескольких недель до

нескольких месяцев.

Подобным образом, любой закрытый продукт, который разрабатывался

больше 5 лет - автоматически становится кодом спагетти, который к

своей следующей версии сможет передвигаться только на костылях.

Autodesk разрабатывает Revit проще: разработчики просто не

занимаются темой производительности, а от версии к версии создают

только такие инструменты, которые работают поверх основного

функционала.

Так как основной код был написан в конце 90-х, в Revit

используется (исключая визуализацию) только одно ядро процессора,

что сдерживает производительность проектирования. Например, у

программы Revit уже нет возможности работать в многопоточном

режиме, используя все ядра в hardware. И даже если у вас через 10

лет будет тысяча ядер в процессоре - прироста производительности в

программе Revit вы не получите.

Геометрическое ядро

Благодаря постоянной текучке кадров в дополнение к проблеме

закрытой разработки кода, вокруг нас полно старых Legacy

продуктов, которые написаны ужасно плохо, но при этом невероятно

сложно и дорого поддерживаются сегодня на плаву. Причём переписать

их уже никогда не получится, потому что они взаимодействуют с таким

же ужасным кодом у пользователей продукта, и поэтому необходимо

соблюдать совместимость с багами и не документированными

особенностями. По этой причине многие продукты стали заложниками

обратной совместимости. В том числе Windows, Microsoft Office и

основные программы на рынке САПР.

У таких программ, как Revit, ArchiCAD, Microstation уже нет

будущего, и возможно, сами вендоры это понимают. Поэтому все силы

корпораций сегодня тратятся не на увеличение производительности

геометрического ядра, а на поиск нового успешного продукта или

новых уникальных разработчиков, как Leonid Raiz (Revit), Mike

Riddle (AutoCAD) или Gabor Bojar (ArchiCAD).

Из-за отсутствия новых успешных продуктов, основные усилия таких

больших корпораций начинают концентрироваться на навязывании своих

продуктов, агрессивном маркетинге и на том, чтобы поддерживать

текущее ресурсоёмкое жизнеобеспечение сложной и

забюрократизированной структуры.

Исследование Campaign for Clear

Licensing, показало, что аудиты, проводимые такими

поставщиками программного обеспечения, как Oracle и Autodesk

(Microsoft, SAP, IBM) блокируют конкуренцию и препятствуют

инновациям в ИТ-отделах компаний, где эти аудиты проводились.

Кто наименее полезный поставщик с точки

зрения аудита? Oracle был признан худшим поставщиком в процессе

аудита, за ним следуют IBM и Autodesk.

К началу 2000-х основные корпорации заняли свои ниши в отрасли и

каждый год спокойно распределяли прибыли среди акционеров. Но с

началом эры open source на горизонте появляется новый конкурент -

разработчики открытых и прозрачных продуктов, совсем не похожие на

специалистов по контракту, переехавших в Калифорнию или Бостон из

Азии или Европы.

Основной головной болью руководителей больших корпораций Oracle,

Microsoft, SAP, Autodesk, IBM к середине 2000-х становится не

миллион строк спагетти кода, а новые open source продукты,

стремительно набирающие популярность: Linux, GitHub, Spark,

Mozilla, Gimp, PHP, WordPress, Android, Blender и тысячи

других.

В случае с Oracle таким конкурентом стал молодой open source

стартап из Швеции - MySQL.

Борьба корпораций с open source

Обычно любые стартапы, стоящие на пути корпораций, уже к началу

2000-х можно было купить при поддержке BlackRock, но как купить

Оpen source-идею, за которой стоят сотни разработчиков со всего

мира?

MySQL - open source проект, который одновременно разрабатывали

сотни специалистов со всего мира. При этом код полностью бесплатен

и прозрачен для дальнейшей разработки (или написания инструментов

для него), благодаря чему MySQL быстро завоевал популярность на

рынке баз данных.

Популярность баз данных по годам с 2013 года

В борьбе за рынок Oracle начала снижать цены и предоставлять

большие скидки тем компаниям, которые уже использовали или ещё

только собирались использовать MySQL. Одновременно с этим Oracle,

осознавая угрозу своему бизнесу, всеми способами пытался купить это

быстрое, бесплатное и прозрачное DBMS решение.

В течение всего 2006 года Ларри Эллисон (глава Oracle с

одесскими корнями) неоднократно предлагал выкупить MySQL, но

трое друзей-шведов, основателей MySQL, постоянно отвергали

предложение от империи зла Oracle, взлёт которой произошёл

благодаря сотрудничеству с ЦРУ.

Стабильный Oracle c 1997 года

В итоге акционеры MySQL продали свой продукт компании

Sun (отцы-основатели МySQL получили от сделки по $10 mln.) и

уже в 2009 году Oracle сумел опередить IBM и заключил соглашение о

покупке компании Sun (вместе с продуктом MySQL) за $7.4

миллиардов.

В 2009 MySQL ждало большое обновление: в версии MySQL 5.4

появилась поддержка 16-процессорных серверов x86, и, по некоторым

тестам, производительность MySQL должна была вырасти в десятки

раз. Выход MySQL 5.4 был запланирован на 21

апреля, но, по случайности, за день до того произошла сделка с

Oracle.

Уже после покупки, чтобы не давать развития своему непокорному

приёмному open source сыну, с 2009 г., Oracle (которая теперь

являлась владельцем прав на MySQL) пыталась изнутри расшатать и

замедлить открытую модель

разработки знаменитой СУБД.

Таким образом, Oracle, при помощи BlackRock, расчистил рынок

своему основному закрытому спагетти продукту Oracle Database на

следующие 10 лет, а акционеры инвестиционных фондов теперь могли

ожидать выплаты дивидендов на ожидаемом уровне в ближайшие

годы.

Но open source MySQL-идею убить уже невозможно, и разработчики

из комьюнити MySQL начали перетекать в другие open source проекты.

В итоге все основные разработчики MySQL махнули рукой на Oracle и

перешли на более быстрые и современные open source базы данных -

MariaDB (форк копия MySQL), PostgreSQL и SQL-lite.

Подобные покупки постоянно происходят и на рынке САПР-решений.

Все те же тренды ждут любых разработчиков САПР и BIM-решений, а

сама история с MySQL похожа на историю с IFC, изначально открытым

форматом.

Oracle, по сути, сделал c MySQL то же самое, что сделал Autodesk

c IFC в середине 90-х, но гораздо быстрее и проще.

Autodesk и формат данных IFC

Идея открытого формата IFC родилась у визионера строительных

технологий Leonard Obermeyer,

который перед олимпиадой в Мюнхене во время строительства

мюнхенского аэропорта взаимодействовал с поставщиками и фирмами со

всего мира. Во время проектирования олимпийских проектов Leonard

Obermeyer понял, что нужен один общий язык, на котором будут

общаться строители и производители строительных элементов со всего

мира.

Так как сам Leonard Obermeyer не был программистом, эту идею он

передал своему родному факультету мюнхенского университета, где

дальнейшей разработкой нового открытого формата занимались Richard Junge и

Thomas Liebich с командой студентов.

Идеей создателей IFC-формата было создать всемирный и свободный

язык обмена данными в строительстве (несмотря на военные корни

формата IFC-STEP, протокола Application Protocol

225), но в начале 90-х ещё мало было известно об open

source.

Благодаря другу Leonard Obermeyer - Patrick MacLeamy (CEO

of HOK) - Autodesk

активно включается в развитие всемирной идеи IFC. Проходит всего

несколько лет, и регистрацию и разработку IFC берёт полностью под

свой контроль Autodesk.

Об этом подробнее в Часть 3: Отцы BIM технологий. Кто

стоит за успехом Autodesk и openBIM?

Но к концу 90-х, не имея нормальных 3D-продуктов, сам Autodesk

не смог применять нормально этот продукт в своих программах - и

идея мирового 3D формата уходит под контроль картельной организации

IAI (которая позже переименовывается в buildingSMART).

Для контроля над развитием IFC у руля buildingSMART остаётся

Patrick MacLeamy,

партнёр корпорации Autodesk по совместным проектам с компанией HOK

(где McLeamy был CEO). К слову, в некоторых странах ещё сегодня

представителями Autodesk и представителями buildingSMART являются

зачастую одни и те же специалисты.

Исходя из этих фактов, можно предположить, что американская

организация buildingSMART держит Autodesk в курсе возможных

вариантов развития, для того чтобы Autodesk смог вовремя

перехватить инициативу в мире форматов обмена данными и заниматься

новыми технологиями без оглядки на конкурентов.

Подобным образом Autodesk выпустил на рынок open source решение

Dynamo, которое используется в Revit и Civil 3D для расширения

функционала. Dynamo изначально представлялся как open source

продукт, который внезапно возник в 2011 году в

недрах Autodesk (или точнее был разработан по заказу Autodesk). Так

же, как и buildingSMART, к рождению которого приложила руку

корпорация Autodesk, - код Dynamo тоже не отличается прозрачностью.

Многие разработчики указывают на то, что

пакеты, завернутые в библиотеки DLL, часто запрещают доступ к коду,

что не позволяет пользователям исследовать ни код, ни то, как

отдельные куски кода обрабатываются или

анализируются в инструменте Dynamo. Что также не позволяет использовать

Dynamo в продуктах, по-настоящему открытых, таких как

BlenderBIM (для визуального программирования в Blender сегодня

используется Sverchok).

Типы open source: совершенно свободный,

с явным контролем, неявно контролируемый

Таким образом, Autodesk в контроле над открытыми проектами IFC и

Dynamo создала конструкцию, похожую на ту, что Oracle создал с

MySql. Только в мире баз данных - Oracle открыто, через Sun, купила

open source - MySql, а Autodesk на расстоянии контролирует движение

проектов Dynamo и buildingSMART (который, в свою очередь, старается

на расстоянии общаться с европейскими вендорами openBIM движения -

Nemetschek).

И если сегодня образуется по-настоящему новый open source формат

или у Revit появится достойный open source конкурент, - то Autodesk

пойдёт проверенным путём Oracle и, возможно, попытается выкупить

права на любой продукт на самых ранних стадиях, что, скорее всего,

опять продлит жизнь продуктам Autodesk ещё на одно десятилетие.

Как узнать кто уже мёртв, а кто ещё нет?

Мы маленькая строительная компания.

Сегодня buildingSMART неспешно пытается устанавливать правила на

рынке САПР, при этом интересы buildingSMART в основном диктуются

потребностями основных игроков в этой нише - Autodesk, Bentley

Systems (с 2019 Oracle).

Единственной более-менее свободной от лоббирования организацией

остаётся альянс ODA (Open Design Alliance).

Проблема Autodesk - организация открытых стандартов - ODA

ODA круто изменил ситуацию для пользователей CAD во всём мире,

когда позволил разработчикам CAD-приложений существенно сократить

затраты на поддержку формата DWG, ставшего де-факто отраслевым

стандартом для обмена CAD-данными.

ODA создала продукты (основным из которых является Teigha) с

возможностью для более чем 2000 организаций-членов работать без

всякой оглядки на Autodesk, чем фактически убрал искусственные

барьеры, которые сдерживали развитие всей отрасли САПР.

Альянс по Открытому Проектированию (Open Design Alliance)

является некоммерческим консорциумом, нацеленным на распространение

открытых форматов для обмена данными САПР. Технологическая

платформа ODA обеспечивает пользователей средствами для создания

широкого спектра приложений, включая средства визуализации и даже

полномасштабные САПР. Платформа поддерживает файлы DWG, DGN, RFA,

IFC, RVT с возможностями редактирования, импорта и экспорта в

другие файловые форматы.

История ODA началась с попытки Autodesk купить

компанию SoftDesk, которая в середине 90-х разрабатывала

свою САПР-платформу с целью полностью заменить AutoCAD. После

антимонопольного расследования суд запретил Autodesk покупать

SoftDesk, который позже (после передачи прав VISIO) был выкуплен

компанией Microsoft.

На основе технологий компании Softdesk и InteliCADD (позже

InteliCAD) в 1998 году образуется новый альянс OpenDWG. Альянс ODA

(OpenDWG Alliance) поставил своей целью уравнивать шансы всех

производителей САПР-решений, вне зависимости от того, в каких

отношениях с компанией Autodesk находятся эти разработчики.

Эквалайзер - урванитель САПР разработки

Первый конфликт между ODA и Autodesk возник в начале 2000-х

вокруг формата DWG.

В 1998 году ODA предоставила новые инструменты миллионам

пользователей программного обеспечения с возможностью продолжать

использовать формат файла DWG без привязки к единственному

поставщику продуктов - Autodesk.

Примечательно, что сам формат файла DWG и программа Autocad

были разработаны Mike Riddle и что DWG использовался в конце 1970-х

в его InteractCAD, и только в 1982 году John Walker выкупает

полностью продукт Autocad вместе с форматом DWG, основывая таким

образом фирму Autodesk для массовой продажи DWG продукта.

Сам Autodesk после покупки программы Autocad (20 лет) не

предоставлял API для доступа к файлам DWG, поэтому и ответом на

такую закрытость стало появление на рынке САПР первой открытой

инициативы: GNU LibreDWG, который мог читать формат DWG. Но, к

сожалению, LibreDWG не мог редактировать информацию в DWG

файле.

Этот барьер по изменению файла DWG смог преодолеть альянс ODA с

продуктом Teigha, который позволял работать с форматом DWG в любой

САПР-программе. Этот продукт уравнял шансы всех

САПР-разработчиков, и именно ему обязаны своим успехом

такие ныне известные компании, как бельгийская Bricsys, немецкая

Graebert, французская DraftSight, китайская ZWSoft, российская

NanoSoft и ряд других.

В ответ на открытые разработки Autodesk создал для сторонних

разработчиков САПР инструмент - RealDWG (настоящий истинный DWG) в

виде модулей экспорта и импорта, что позволяло сторонним

разработчикам САПР-программ наконец встраивать в свой функционал

экспорт и импорт чертежей в формате DWG.

С 2006 года на ODA посыпались судебные иски от

Autodesk, которая пыталась защитить купленный ими в 1982

году продукт DWG. И с момента противостояния с ODA, чтобы усложнить

жизнь конкурентам и искусственно ограничить конкуренцию, Autodesk

создавала каждые несколько лет новую версию самого правильного DWG

формата (при этом вставляя в формат водяные знаки Autodesk).

Иск компании Autodesk к альянсу ODA

через Американский окружной суд (US District Court)

В 2006 году компания Autodesk внедрила в обновленный формат

DWG 2007 технологию TrustedDWG, которая позволяла определить,

создан ли файл формата DWG в одной из программ Autodesk или в

программе, использующей RealDWG. В случае, если файл DWG 2007

создан в нелицензированной программе, AutoCAD показывал сообщение,

предупреждающее пользователя о возможных проблемах совместимости.

Компания мотивировала своё решение заботой о

пользователях.

Из-за резкого интереса конкурентов к инструментам ODA, спустя 25

лет после создания DWG, Autodesk в 2006 году решила зарегистрировать DWG

как свою торговую марку. Захватив рынок CAD, Autodesk

утверждала, что самый правильный DWG файл могут делать только

продукты Autodesk.

Autodesk выиграл суды, и на первый взгляд показалось, что

Autodesk отстоял свои права на формат DWG, но судебные запреты не

стали концом света для альянса ODA.

В 2007 году иск был окончательно отозван. Стороны заключили

мировое соглашение. ODA исключил код TrustedDWG из библиотек

DirectDWG, а Autodesk изменил предупреждающие сообщение в AutoCAD

2008. В итоге в решениях суда речь шла только о торговой марке

"DWG", при этом формат файла DWG остался общедоступным.

Информация о проигрыше в суде на официальном

сайте ODA

Возможно, уже сегодня подобная борьба разворачивается за форматы

RVT и RFA.

Revit (и похожий продукт форк PTC - Solidworkds) и

форматы RFA и RVT были разработаны Леонидом Райцем (и его учителем

по PTC - Самуилом Гайзбергом) в 90-е. После покупки при помощи

патентов и регистрации прав на торговые марки Autodesk пытался

закрепить своё право над 3D САПР-программой Revit и её

форматом.

В мае 2020 года, на пике интереса к продукту Revit и его BIM

решениям (а не на закате популярности, как это было с Autocad), ODA

официально выходит на рынок со своим продуктом BimRv SDK. BimRv SDK

от ODA предлагает работать с данными Revit без зависимости от

приложения Revit. Инструмент позволяет, например, создавать семейства

(геометрию типов), не используя Revit.

За несколько лет до публикации релиза BimRv ODA становится

первым вендором, который позволяет не просто читать информацию из

IFС, а дает возможность создавать IFC геометрию, чего ещё ни одна

САПР-компания сделать не смогла. Полный открытый IFC-набор

инструментов от ODA будет представлять

собой доступ к данным и к созданию объектов,

интегрированный с высокоскоростной визуализацией и возможностями

конвертирования IFC-данных в другие форматы, такие как

.dwg.

Логично, что если инструмент, редактирующий Revit или IFC файлы

от ODA, получит реальное распространение, то прибыли, которые

Autodesk сегодня делает на своих продуктах, могут резко упасть.

На опыте борьбы с Softdesk и после судебных тяжб с ODA по

продукту Teigha-DWG Autodesk понимает, что ODA c BimRv SDK уже

продвинулась на порядок дальше в своих возможностях, и теперь ODA

уже не допустит ошибок, которые были допущены в борьбе за

открытость формата DWG.

Поэтому сегодня Autodesk остаётся массово скупать новые

технологии на рынке стартапов или пробовать "усложнить" работу

альянса ODA, который пытается незаконно (по мнению Autodesk)

распространять форматы RVT и DWG и, по пути, стать тем самым

возрождённым SoftDesk, который Autodesk не получилось до конца

убить в самом начале развития.

Самый простой и верный способ обмануть человека это

прикинуться другом.

Публий Овидий Назон

Наблюдая за успехами ODA со стороны, через несколько месяцев

после того, как ODA опубликовал BimRV, Autodesk вынес волевое

решение присоединиться к альянсу ODA, чтобы, возможно ближе понять

все возможности альянса, который ещё не удалось купить. Autodesk

указал причину

присоединения к ODA: интерес к набору инструментов IFC от ODA

(который обеспечивает полную и гибкую совместимость с IFC для

любого настольного или веб-приложения). При этом в саму организацию

buildingSMART, которая занимается не только инструментами IFC, но и

разработкой непосредственно формата IFC, Autodesk вступил на один

месяц позже, в октябре 2020 года.

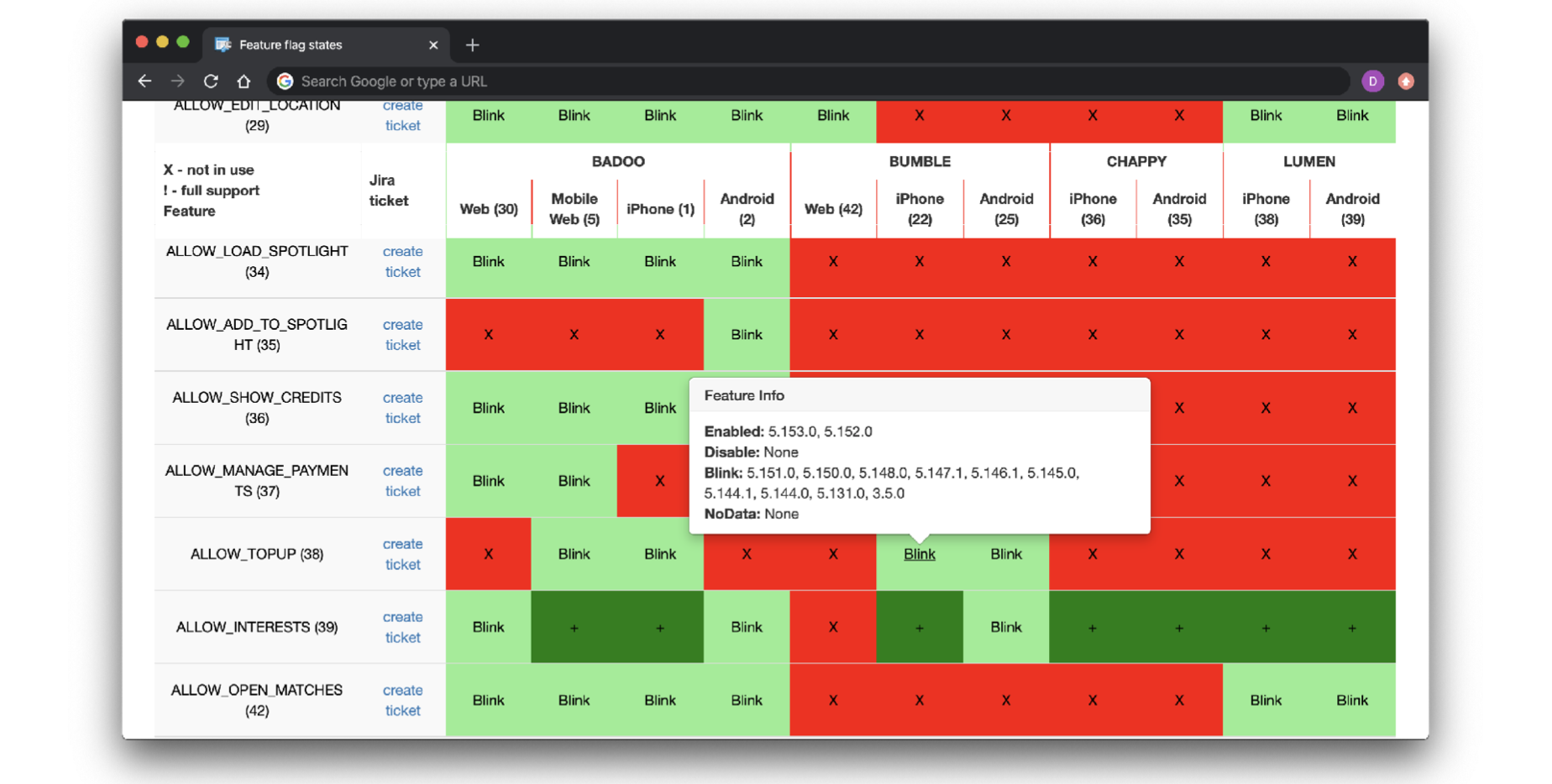

ODA показывает BimRV SDK - Autodesk

вступает в ODA - Autodesk вступает в buildingSMART

Из-за активности альянса ODA по раскрытию форматов RVT, RFA,

начиная с 2020 года Autodesk стал активно возвращаться к управлению

своим брошенным приемным сыном - форматом IFC, встраивая с версии

Revit-2020 все те возможности экспорта в IFC формат, которые до

этого (видимо, искусственно) тормозились или просто не

развивались.

Возможно, Autodesk понимает, что закрытые форматы сегодня больше

не смогут быть драйвером той бизнес-модели, которая успешно

работала в 90-е годы, и поэтому сегодня Autodesk ставит для себя

целью отказаться от форматов и

продавать главным образом облачные решения. Одновременно с этим

Autodesk спешит возглавить разработку открытых технологий в

САПР-мире вслед за своими друзьями: IBM, Microsoft, Oracle, SAP,

которые также заявили свои права на лидерство в open

source-разработках (об этом подробнее в следующей части).

Но открытость open source плохо сочетается с той политикой,

которую фирмы силиконовой долины проводили последние 30 лет.

В заключение

Времена настоящей конкуренции благодаря финансовым фондам уходят

в историю. Отсутствие конкуренции сказывается на развитии

технологий в нашей, и без того отсталой, отрасли строительства.

Старые корпорации, такие как Autodesk, Hexagon, Nemetschek

Group, Trimble, построившие отличную инфраструктуру в 90-е,

пытаются подстраиваться под быстрые изменения рынка. Разработка

Legacy программ, например, Revit и Archicad, тормозится.

Небольшие CAD и BIM стартапы или уничтожаются, или покупаются за

пару миллионов (или как Plngrid, Aconex уже миллиардов) долларов -

и уходят в бюрократическую систему дедлайнов и костылей; а к

самостоятельной разработке новых идей и инструментов у корпораций,

кажется, нет ни интереса, ни творческих способностей.

Олигополия в САПР

Кризис программного обеспечения в САПР и в других технологиях

носит также системный и поколенческий характер. Проблема в том, что

сейчас у руля BlackRock, Vanguard, Oracle, Autodesk и других

компаний стоит поколение X или Baby-Boomers, которые ещё помнят

деколонизацию доминионов и карибский кризис в 60е.

И, конечно, мы не можем не испытывать уважения к этому поколению

(наших родителей), но очевидно, что технологии развиваются слишком

быстро, чтобы отдавать управление новыми технологиями людям из

BlackRock или Autodesk, которые родились в то время, когда человек

ещё не изобрёл пульт от телевизора, а компьютеры были размером с

дом.

Определение поколений

В целом укрупнение капитала и монополизация рынка с дальнейшими

построениями олигополий или прямых монополистов это естественный

ход капитализма. Таким образом, капитализм на стероидах создал

бюрократию управления или, другими словами, плановую экономику на

мировом уровне.

Только если в Советском союзе при плановой экономике получаемая

прибыль принадлежала всем членам общества, то в мировой плановой

экономике прибыль получают только акционеры основных инвестиционных

фондов.

Плановая экономика тогда и сейчас

Ни в коем случае нельзя обвинять в алчности структуры,

построенные BlackRock и Vanguard: на их месте любая организация и

возможно любой человек поступил бы точно так же. Мы можем быть

благодарны им за то, что конкретно этот тупиковый путь выбрали

именно они.

Успокаивает только тот факт, что могущество теневых банков и

бюрократия в масштабах всей планеты - недавнее явление, которое наука

и политика только начинают понимать. Это тренд всего лишь

последних 20 лет и, благодаря истории, мы уже знаем, что плановая

экономика нежизнеспособна в рамках одной страны, и такая модель

ручного управления уж точно не имеет смысла в долгосрочной

перспективе в масштабах всей планеты.

Нам помогают проблемы и кризисы. Большие корпорации, благодаря

постоянной поддержке мамы BlackRock и папы Vanguard, не способны

сами создать для себя трудные времена, которые могли бы помочь

компаниями и технологиям выйти на новый уровень развития.

Тот уже не хитрый, о ком все говорят, что он хитер.

Александр Суворов

Логично, что BlackRock и Vanguard уйдут в историю со своей

бюрократией и сложными закрытыми конструкциями, точно так же, как

эта бюрократия и вертикальная система связей исчезла из плановой

экономики Советского Союза.Для поражения BlackRock и Vanguard не

хватает только сильного соперника, которым может стать сегодня

децентрализированная экономика.

Благодаря прозрачности информации: журналистам, появлению камер

и фотоаппаратов - в конце 20 века люди перестали убивать массово

других людей. А в 21 веке, благодаря интернету и децентрализованным

приложениям, на наших глазах при помощи open source кода создаётся

новая децентрализованная экономика, за которой пытаются угнаться

старые корпорации со своим другом BlackRock.

Эти многие западные компании и структуры в будущем ещё ждут своя

перестройка и своя гласность.

Настоящий показатель вашего богатства это то, чего вы будете

стоить, если потеряете все свои деньги.

Неизвестный автор

Остаётся надеяться на кризисы и чёрных лебедей, вроде COVID-19,

благодаря которым специалисты со всего мира после 2021 года,

возможно, перестанут торопиться переезжать в другие страны и искать

своё место в этой, хоть и денежной, но очень забюрократизированной

и устаревшей структуре. Такие новые уникальные специалисты, вроде

Gabor Bojar, Mike Riddle, Samuel Geisberg, могут уже сегодня

заниматься разработкой новых САПР-BIM технологий из любого

доступного места.

Новый мир программного обеспечения и технологий будет намного

прозрачней, способствуя тем самым увеличению количества

разработчиков, созданию новых удалённых рабочих мест и открытию

новых возможностей монетизации.

Про решения Оpen source, монетизацию про то почему IFC это

не open source поговорим в следующей части.

Если Вам интересна тема openSource и BIM (продукты с открытым

кодом в строительстве) подключайтесь к обсуждению в группе

телеграмм - bimopensource: https://t.me/bimopensource

Буду благодарен за репост в социальных сетях и рад вашим

комментариям, уточнениям и критике.

Схема связей BIM программ указанных в статье в хорошем качестве

доступна по ссылке.

Предыдущие статьи по теме:

Сравнение технологий в

строительстве и 5D проектирование в Азии и Европе: Казахстан,

Австрия, Германия, Китай, Украина

Сравнение технологий в

строительстве и 5D проектирование в Азии и Европе: Казахстан,

Австрия, Германия, Китай, Украина

Со времени написания первой

статьи на Хабре в 2019 году про зарплаты в строительной отрасли

("Можно ...

habr.com

Войны лоббистов и развитие

BIM. Часть 4: Борьба CAD и BIM. Монополии и лоббисты в строительной

отрасли

Войны лоббистов и развитие

BIM. Часть 4: Борьба CAD и BIM. Монополии и лоббисты в строительной

отрасли

В прошлой статье: часть 3:

Отцы BIM технологий. Кто стоит за успехом Autodesk и openBIM было

показан...

habr.com

Олигополия в САПР

Олигополия в САПР

Данные о держателях долей в уставном

капитале (только материнские компании, за исключением владения

фондами небольших дочерних компаний)

Данные о держателях долей в уставном

капитале (только материнские компании, за исключением владения

фондами небольших дочерних компаний)

Акционеры крупнейших CAD-компаний

Акционеры крупнейших CAD-компаний

Доля владения акциями BlackRock и

Vanguard в компаниях САПР

Доля владения акциями BlackRock и

Vanguard в компаниях САПР

Доля владения акциями BlackRock и

Vanguard в компаниях Big 5

Доля владения акциями BlackRock и

Vanguard в компаниях Big 5

Степень контроля (X - сила голоса) в

компании в зависимости от вечеличины пакета акций (Y - процент

капитала)

Степень контроля (X - сила голоса) в

компании в зависимости от вечеличины пакета акций (Y - процент

капитала)

Доля доли BlackRock в компаниях САПР

Доля доли BlackRock в компаниях САПР

Основные стартапы, приобретенные за последние 20 лет

Основные стартапы, приобретенные за последние 20 лет

Мы убрали с рынка всех конкурентов, но

почему мы не движемся вперед?

Мы убрали с рынка всех конкурентов, но

почему мы не движемся вперед?

Legacy code не проблема - если тебе не

нужно поменять его

Legacy code не проблема - если тебе не

нужно поменять его

Интерфейс - Геометрическое ядро. Мы не

знаем как это работает, но если удалить это приложение рухнет

Интерфейс - Геометрическое ядро. Мы не

знаем как это работает, но если удалить это приложение рухнет

Геометрическое ядро

Геометрическое ядро

Кто наименее полезный поставщик с точки

зрения аудита? Oracle был признан худшим поставщиком в процессе

аудита, за ним следуют IBM и Autodesk.

Кто наименее полезный поставщик с точки

зрения аудита? Oracle был признан худшим поставщиком в процессе

аудита, за ним следуют IBM и Autodesk.

Популярность баз данных по годам с 2013 года

Популярность баз данных по годам с 2013 года

Стабильный Oracle c 1997 года

Стабильный Oracle c 1997 года

Типы open source: совершенно свободный,

с явным контролем, неявно контролируемый

Типы open source: совершенно свободный,

с явным контролем, неявно контролируемый

Как узнать кто уже мёртв, а кто ещё нет?

Мы маленькая строительная компания.

Как узнать кто уже мёртв, а кто ещё нет?

Мы маленькая строительная компания.

Эквалайзер - урванитель САПР разработки

Эквалайзер - урванитель САПР разработки

Иск компании Autodesk к альянсу ODA

через Американский окружной суд (US District Court)

Иск компании Autodesk к альянсу ODA

через Американский окружной суд (US District Court)

Информация о проигрыше в суде на официальном

сайте ODA

Информация о проигрыше в суде на официальном

сайте ODA

ODA показывает BimRV SDK - Autodesk

вступает в ODA - Autodesk вступает в buildingSMART

ODA показывает BimRV SDK - Autodesk

вступает в ODA - Autodesk вступает в buildingSMART

Олигополия в САПР

Олигополия в САПР

Определение поколений

Определение поколений

Плановая экономика тогда и сейчас

Плановая экономика тогда и сейчас