Шестьдесят лет назад Вуди Бледсо (Woody Bledsoe) сын земледельца

изобрёл технологию идентификации лиц. Но свидетельство о его

причастности к открытию практически исчезло.

Редакция Нетологии подготовила адаптированный перевод

статьи Wired об этой неизвестной широкому кругу истории, о

наработках Бледсо и его команды, которые используются в современной

технологии распознавания лиц.

Около тридцати лет Вуди Бледсо был профессором Техасского

университета в Остине и работал над развитием автоматизированных

рассуждений и искусственного интеллекта. По воспоминаниям Ланса,

сына Бледсо, профессор был восторженным учёным-оптимистом, который

ещё в конце 1950 годов мечтал создать компьютер, наделённый

человеческими возможностями и способный доказывать сложные

математические теоремы, поддерживать разговор и прилично играть в

пинг-понг.

Но в начале карьеры Бледсо увлечённо искал возможность научить

машины распознавать лица недооценённую тогда, но потенциально

мощную человеческую способность. Это были первые исследования по

идентификации лиц (1960 года), и работа профессора привлекла

интерес спецслужб США. Главные инвесторы Вуди, скорее всего, были

подставными компаниями ЦРУ.

Распознавание лиц: благо и ящик Пандоры

Сегодня функция распознавания лиц используется для обеспечения

безопасности в телефонах, ноутбуках, паспортах и платёжных

приложениях. Ожидается, что эта технология кардинально изменит

рынок таргетированной рекламы и ускорит диагностику определённых

заболеваний. В то же время технология идентификации лиц

превращается в инструмент государственного давления и корпоративной

слежки.

Так, при помощи этой технологии в Китае правительство отслеживает

представителей уйгурского этнического меньшинства, сотни тысяч

которых поместили в лагеря для политических заключённых. А в США,

по данным The Washington Post, Иммиграционная и таможенная полиция

и ФБР проводит цифровой розыск: ищет подозреваемых в

государственных базах данных водительских удостоверений иногда без

предварительного обращения в суд.

В 2019 году расследование Financial Times показало, что

исследователи из Microsoft и Стэнфордского университета собрали и

выложили в открытый доступ большое количество пакетов данных с

изображениями людей без ведома или согласия сфотографированных.

Впоследствии эти данные были уничтожены, но исследователи

техстартапов и одной китайской военной академии успели их

заполучить.

Исследования Вуди Бледсо по распознаванию лиц,

проведённые в 1960 годах, предвосхитили технологические прорывы и

их этические аспекты, которые мы наблюдаем сейчас. И тем не менее,

эти основополагающие работы почти совсем неизвестны большая их

часть так и не была обнародована.

В 1995 году по неизвестным причинам Вуди попросил сына уничтожить

архив исследований. Но большая часть бумаг сохранилась, и тысячи

страниц его работ теперь хранится в Центре американской истории

Бриско в Техасском университете.

Среди прочего сохранились десятки фотографий людей, и некоторые

лица помечены странными математическими записями, как будто

поражённые неким геометрическим кожным заболеванием. На этих

портретах можно разглядеть историю зарождения технологии, которая в

ближайшие десятилетия будет активно развиваться и проникнет во

многие сферы деятельности человека.

Как всё начиналось. Метод кортежей

Вудро Вильсон (Вуди) Бледсо родился в 1921 году в многодетной семье

земледельца-издольщика из Оклахомы. Был десятым ребёнком в семье и

сколько себя помнил всегда помогал отцу по хозяйству. Обладал

математическим складом ума. Окончил среднюю школу. Три месяца

проучился в Университете Оклахомы, после чего Вуди призвали в армию

в канун Второй мировой войны.

После войны Вуди изучал математику в Университете Юты, а затем

уехал в Беркли для получения степени доктора наук. Закончив

аспирантуру, Вуди занимался исследованиями в области ядерного

оружия в правительственной корпорации Sandia в Нью-Мексико вместе с

такими светилами, как Станислав Улам (Stanislaw Ulam), который

участвовал в создании водородной бомбы.

В Sandia Вуди сделал первые шаги в компьютерном мире,

приверженность к которому пронесёт через всю жизнь. Сначала писал

код для проектов по ядерному оружию. А позднее Вуди заинтересовался

автоматическим распознаванием паттернов, особенно машинным чтением

процессом обучения системы распознавать немаркированные изображения

написанных символов.

Вуди Бледсо и его коллега Ибен Браунинг (Iben Browning)

изобретатель-эрудит, авиаинженер и биофизик придумали метод,

который впоследствии стал известен как метод кортежей

(n-tuple).

Учёные начали с проецирования напечатанного символа скажем, буквы Q

на прямоугольную сетку из клеток наподобие разлинованного листа

бумаги. Каждой клетке-ячейке присваивался двоичный номер в

зависимости от наличия или отсутствия в ней части символа: 0 для

пустой клетки, 1 для заполненной. Затем ячейки случайным образом

группировались в упорядоченные пары, как наборы координат.

Теоретически группы могли включать любое количество ячеек, отсюда и

название метода. Далее при помощи нескольких математических

действий система присваивала сетке символа уникальное значение. А

при столкновении с новым символом сетка этого символа сравнивалась

с другими в базе данных до тех пор, пока не находилось ближайшее

совпадение.

Суть метода состояла в том, что он позволял распознавать множество

вариантов одного и того же знака: большинство Q, как правило,

получали довольно схожие результаты по сравнению с другими Q. Лучше

всего процесс работал с любым шаблоном, а не только с текстом. По

словам Роберта С. Бойера (Robert S. Boyer), математика и давнего

друга Вуди, метод кортежей помог определить область распознавания

шаблонов. Это был один из первых шагов к вопросу: Как

запрограммировать машину делать то, что делают люди?".

Примерно в то время, когда он разрабатывал метод

кортежей, Вуди впервые мечтал создать машину, которую он называл

компьютерным человеком.

Спустя годы он вспоминал дикое волнение, которое испытывал,

формулируя навыки для искусственного разума:

Я хотел, чтобы он читал напечатанные знаки и рукописный текст. Я

мог видеть его либо его часть в маленькой камере, которая крепилась

бы на мои очки, с наушником, через который я бы слышал, как он

называет имена моих друзей и знакомых, когда я встречал бы их на

улице Понимаете, мой компьютерный друг мог бы распознавать

лица.

Исследования в компании Panoramic Research Incorporated

В 1960 году Вуди вместе с Ибеном Браунингом и ещё одним коллегой из

Sandia основал компанию Panoramic Research Incorporated

(Panoramic). Сначала они располагались в небольшом помещении в

Пало-Альто, который ещё не был известен как сердце Кремниевой

долины. В то время большинство компьютеров массивных устройств,

которые хранили данные на перфокартах или магнитных лентах,

размещались в офисах крупных компаний и правительственных

лабораториях. Компания Вуди не могла себе позволить купить

компьютер, поэтому учёные арендовали вычислительное время на такой

машине у своих соседей, часто поздно вечером, когда оно было

дешевле.

Бизнес Panoramic заключался в том, чтобы тестировать

идеи, которые, как мы надеялись, перевернут мир.

По словам Нельса Уинклесса (Nels Winkless), писателя и

консультанта, который участвовал в нескольких проектах Panoramic, а

позже стал одним из основателей журнала Personal Computing, их

задача заключалась в том, чтобы делать то, что другие люди находят

слишком глупым.

Изобретения некоторых исследователей Panoramic получили широкую

известность. Например, Хелен Чан Вульф (Helen Chan Wolf), пионер в

программировании роботов, работала над созданием робота Шейки

(Shakey the Robot). По мнению Института инженеров по электротехнике

и радиоэлектронике, это первый в мире робот, воплощающий в себе

искусственный интеллект.

Panoramic тщетно пыталась найти финансирование. Вуди сделал всё

возможное для презентации технологии распознавания символов, в том

числе представив изобретение Обществу справедливого страхования

жизни и журналу McCall's. Но контракт так и не заключили.

На протяжении всего своего существования у Panoramic

был, по крайней мере, один надёжный покровитель, который помогал ей

держаться на плаву, Центральное разведывательное

управление.

Если в бумагах Вуди Бледсо когда и были упоминания о ЦРУ, то,

скорее всего, они были уничтожены в 1995 году. Но фрагменты

сохранившихся материалов явно свидетельствуют о том, что в течение

многих лет компания Вуди работала с подставными компаниями ЦРУ.

Нельс Уинклесс, который приятельствовал с командой Panoramic,

говорит, что компания, скорее всего, была создана благодаря

финансированию агентства. Никто никогда не говорил мне об этом

прямо, вспоминает Уинклесс, но так оно и было.

Согласно данным сайта the Black Vault, который занимается запросами

по Закону о свободном доступе к информации, компания Panoramic

Research Incorporated входила в число 80 организаций, работавших

над проектом MK-Ultra. Это печально известная программа ЦРУ по

контролю разума, где применялись психологические пытки без согласия

людей. Через подставной исследовательский фонд the Medical Sciences

Research Foundation компании Panoramic поручили заниматься

подпроектами по изучению бактериальных и грибковых токсинов и

дистанционному управлению деятельностью отдельных видов

животных.

Дэвид Х. Прайс (David H. Price), антрополог из Университета

Сен-Мартина, считал, что Вуди и его коллеги также получали деньги

от Общества по изучению экологии человека. От имени этого общества

ЦРУ предоставляло гранты учёным, чьи работы могли улучшить методы

допроса, которые использовались агентством, или выступить в

качестве прикрытия для таких исследований.

Но проведение самых значимых исследований компании Panoramic

обеспечила другая фиктивная компания the King-Hurley Research Group

(King-Hurley). Согласно серии исков, поданных в 1970 годах, ЦРУ

использовало эту исследовательскую группу для закупки самолётов и

вертолётов для секретных военно-воздушных сил агентства, известных

как Air America. Некоторое время King-Hurley также финансировала

психофармакологические исследования в Стэнфорде.

В начале 1963 года King-Hurley принимала разного рода презентации

идей только от Вуди Бледсо. Он предложил провести исследование для

определения целесообразности создания упрощённой машины для

распознавания лиц. Опираясь на их с Браунингом работу по методу

кортежей, Вуди хотел научить систему распознавать 10 лиц. То есть

он планировал использовать базу данных из 10 фотографий разных

людей и узнать, сможет ли машина идентифицировать новые фотографии

каждого из них. Вскоре можно будет увеличить число людей до тысяч,

писал Вуди. В течение месяца King-Hurley выдал ему разрешение на

старт работ.

Первые эксперименты в области распознавания лиц

Сегодня идентификация десяти людей может показаться довольно

скромной целью, но в 1963 году она была невероятно амбициозной.

Скачок от распознавания написанных символов к распознаванию лиц был

гигантским. Хотя бы потому что не было ни стандартного метода

оцифровки фотографий, ни существующей базы цифровых изображений, на

которую можно было бы опираться. Современные исследователи могут

обучать свои алгоритмы на миллионах селфи в свободном доступе, а

Panoramic пришлось бы строить базу данных с нуля.

Была проблема и посерьёзнее: трёхмерные лица людей в отличие от

двухмерных знаков не статичны. Изображения одного и того же

человека могут различаться по повороту головы, интенсивности

освещения и ракурсу, а также в зависимости от возраста, причёски и

настроения на одной фотографии человек может выглядеть беззаботным,

на другой встревоженным.

По аналогии с выявлением общего знаменателя в

чрезвычайно сложной дроби команда должна была скорректировать

вариативность и упорядочить изображения, которые они

сравнивали.

И вряд ли можно было бы с уверенностью утверждать, что их

компьютеры справятся с этой задачей. Одной из основных машин была

CDC 1604 со 192 КБ оперативной памяти примерно в 21 000 раз меньше,

чем у обычного современного смартфона.

С самого начала Вуди полностью осознавал эти сложности, поэтому

выбрал подход разделяй и властвуй: разбил исследования на части и

поручил их разным сотрудникам.

Работа над оцифровкой изображений проходила следующим образом.

Исследователь снимал чёрно-белые фотографии участников проекта на

16-миллиметровую плёнку. Затем использовал сканирующее устройство,

которое разработал Браунинг, чтобы преобразовать каждый снимок в

десятки тысяч точек данных. Каждая точка должна была иметь значение

интенсивности света в диапазоне от 0 (самая тёмная) до 3 (самая

светлая) в определённом месте на снимке. Получалось слишком много

точек для единовременной обработки компьютером, поэтому

исследователь написал программу NUBLOB, которая нарезала

изображение на образцы случайного размера и вычисляла для каждого

уникальное значение наподобие тех, что присваивались по методу

кортежей.

Над наклоном головы работали Вуди, Хелен Чан Вульф и ещё один

исследователь. Сначала учёные нарисовали серию пронумерованных

маленьких крестиков на левой стороне лица участника эксперимента от

вершины лба до подбородка. Затем сделали два портрета, на одном из

которых человек смотрел вперёд, а на другом повернулся на 45

градусов. Проанализировав местоположение крестиков на этих двух

изображениях, экстраполировали данные на снимок лица с поворотом на

15 или 30 градусов. Загружали в компьютер чёрно-белую картинку

размеченного лица, а на выходе получали автоматически крутящийся

портрет страшноватый, точечный и удивительно точный.

Решения исследователей были оригинальными, но

недостаточно эффективными. Через тринадцать месяцев после начала

работы команда Panoramic признала, что им не удалось обучить машину

распознать хотя бы одно лицо, не то что десять.

Рост волос, выражения лица и признаки старения этот тройной вызов

представлял собой колоссальный источник изменчивости, написал Вуди

в марте 1964 года в отчёте о проделанной работе для King-Hurley.

Поставленная задача выходит за рамки текущего состояния области

распознавания образов и современных компьютерных технологий. При

этом Вуди рекомендовал финансировать больше исследований, чтобы

попытаться найти совершенно новый подход к решению проблемы

распознавания лиц.

Человеко-машинный подход к распознаванию лиц

В течение следующего года Вуди пришёл к выводу, что наиболее

многообещающий подход к автоматизированному распознаванию лиц тот,

который сужает область до взаимосвязей между главными элементами:

глазами, ушами, носом, бровями, губами.

Система, которую он предложил, была похожа на метод французского

криминолога Альфонса Бертильона, который он создал в 1879 году.

Бертильон описывал людей на основе 11 физических измерений, включая

длину левой ноги и длину от локтя до конца среднего пальца. Идея

состояла в том, что если провести достаточно измерений, то каждый

человек станет уникальным. Метод был трудоёмким, но работал: при

помощи него в 1897 году, задолго до широкого распространения

дактилоскопирования, французские жандармы идентифицировали

серийного убийцу Жозефа Ваше.

На протяжении 1965 года Panoramic пробовала создать полностью

автоматизированную систему Бертильона для идентификации лиц.

Команда пыталась разработать программу, которая могла бы определять

носы, губы и другое при помощи светлых и тёмных участков на

фотографии. Но их постигла неудача.

Тогда Вуди и Вульф занялись изучением того, что они

назвали человеко-машинным подходом к распознаванию лиц методом,

который включил в уравнение немного человеческого

участия.

К проекту Вуди привлёк своего сына Грегори и его друга им дали 122

фотографии, на которых было изображено около 50 человек. Ребята

сделали 22 измерения каждого лица, включая длину уха и ширину рта.

Затем Вульф написала программу для обработки данных.

Машина научилась сопоставлять каждый комплект измерений

с фотографией. Результаты были скромными, но неоспоримыми: Вульф и

Вуди доказали, что система Бертильона теоретически

работоспособна.

Их следующим шагом, в конце 1965 года, было создание более

масштабной версии того же эксперимента, чтобы сделать человека

более эффективным в их системе человек-машина. На деньги

King-Hurley они приобрели планшет RAND устройство стоимостью 18 000

долларов, которое выглядело как планшетный сканер изображений, а

работало как iPad. При помощи стилуса исследователь рисовал на

планшете и на выходе получал компьютерное изображение относительно

высокого разрешения.

Через планшет RAND провели новую партию фотографий, подчёркивая

стилусом ключевые элементы лица. Этот процесс хотя и был сложным,

но проходил гораздо быстрее, чем раньше: данные ввели примерно для

2 000 снимков, включая как минимум два изображения каждого лица. В

час обрабатывали порядка 40 снимков.

Даже при такой, более крупной выборке команда Вуди с трудом

преодолевала обычные препятствия.

По-прежнему не была решена проблема с улыбками, которые

искажают лицо и кардинально меняют межлицевые измерения, а также со

старением.

При попытке сопоставить фотографию Вуди 1945 года с фотографией

1965 года система сбивалась с толку. Она не видела большого

сходства между молодым человеком с широкой улыбкой и густыми

тёмными волосами и человеком более старшего возраста с мрачным

выражением лица и поредевшей шевелюрой.

Фото Вуди Бледсо из исследования 1965 года. Фотограф: Dan

Winters

Фото Вуди Бледсо из исследования 1965 года. Фотограф: Dan

Winters

Как будто десятилетия создали другого человека, и в каком-то смысле

это так и было. К этому моменту Вуди устал искать новые контракты

для Panoramic и оказался в нелепом положении, когда то ли слишком

много работы, то ли её недостаточно. Он постоянно представлял новые

идеи своим спонсорам, некоторые из которых сегодня считаются

сомнительными с этической точки зрения.

В марте 1965 года за 50 лет до того, как Китай начал использовать

совпадение паттернов лица для идентификации этнических уйгуров в

провинции Синьцзян Вуди предложил Управлению перспективных

исследовательских проектов (Advanced Research Projects Agency ARPA)

при Министерстве обороны США поддержать Panoramic в изучении

использования черт лица для определения расового происхождения

человека. Существует очень большое количество антропологических

измерений людей со всего мира, которые принадлежат к различным

расовым и экологическим группам, писал Вуди. Это обширное и ценное

хранилище данных, которое было собрано с большим трудом и крупными

затратами, но не использовано должным образом. Согласилась ли ARPA

финансировать этот проект, остаётся неизвестным.

Вуди вкладывал в Panoramic тысячи долларов из собственных средств

без гарантии их возврата. А тем временем его друзья из Техасского

университета в Остине уговаривали его устроиться в университет,

завлекая стабильной зарплатой. И в январе 1966 года Вуди покинул

Panoramic. Вскоре после этого компания закрылась.

С мечтой о создании компьютерного человека Вуди

переехал с семьёй в Остин, чтобы посвятить себя изучению и

преподаванию автоматизированных рассуждений. Но на этом его работа

над технологией распознавания лиц не завершилась.

Самый успешный эксперимент Вуди Бледсо по распознаванию

лиц

В 1967 году Вуди взялся за последнее задание, связанное с

распознаванием паттернов лица. Целью эксперимента было помочь

правоохранительным органам быстро просеивать базы данных

арестованных в поисках совпадений.

Как и прежде, финансирование проекта, судя по всему, поступило от

правительства США. В документе 1967 года, рассекреченном ЦРУ в 2005

году, упоминается внешний контракт на систему распознавания лиц,

что позволило бы в сто раз сократить время поиска.

Основным партнёром Вуди по проекту был Питер Харт (Peter Hart),

инженер-исследователь Лаборатории прикладной физики Стэнфордского

научно-исследовательского института. (Сейчас известный как SRI

International. Институт отделился от Стэнфордского университета в

1970 году из-за разногласий в кампусе по поводу сильной зависимости

института от военного финансирования.)

Вуди и Харт начали с базы данных из порядка 800 снимков по два

снимка 400 взрослых мужчин европеоидной расы. Сфотографированные

различались по возрасту и повороту головы. При помощи планшета RAND

учёные зафиксировали 46 координат для каждой фотографии, в том

числе пять значений для каждого уха, семь для носа и четыре для

каждой брови. На базе предыдущего опыта Вуди по нормализации

вариаций изображений применили математическое уравнение, чтобы

повернуть головы в анфас. Затем, для учёта разницы в масштабах,

увеличили или уменьшили каждое изображение до стандартного размера,

где опорной метрикой было расстояние между зрачками.

Задача системы состояла в том, чтобы запомнить одну

версию каждого лица и использовать её для идентификации

другого.

Вуди и Харт предложили машине один из двух коротких путей. При

первом, известном как групповое совпадение, система разделяла лицо

на черты левая бровь, правое ухо и так далее и сравнивала

относительные расстояния между ними.

Фотограф: Dan Winters

Фотограф: Dan Winters

Второй подход основывался на байесовской теории принятия решений,

где машина использовала 22 измерения, чтобы сделать общее

обоснованное предположение.

По итогам обе программы справились с задачей примерно одинаково

хорошо. А также оказались лучше соперников-людей. Когда Вуди и Харт

попросили трёх человек сопоставить подгруппы из 100 лиц, даже

самому быстрому из них понадобилось шесть часов. Компьютер CDC 3800

выполнил аналогичное задание примерно за три минуты, добившись

стократного сокращения времени. Люди лучше справлялись с поворотами

головы и плохим качеством фотосъёмки, но компьютер значительно

превосходил в плане определения возрастных изменений.

Исследователи пришли к выводу, что машина доминирует

или почти доминирует над человеком. Это был самый большой успех

Вуди в его исследованиях по распознаванию лиц.

Это была также его последняя работа по этой теме, которая никогда

не была опубликована в интересах государства, о чём Вуди и Харт

очень жалели.

В 1970 году, через два года после окончания сотрудничества с

Хартом, робототехник по имени Майкл Касслер сообщил Вуди, что Леон

Хармон (Leon Harmon) из Bell Labs планирует провести исследование

по распознаванию лиц. Меня возмущает, что это исследование второго

рода будет опубликовано и окажется в итоге лучшей системой

человекмашина", ответил Вуди. Мне кажется, что при условии усердной

работы Леон будет отставать от нас где-то на 10 лет к 1975 году.

Должно быть, Вуди был разочарован, когда несколько лет спустя

исследование Хармона попало на обложку журнала Scientific American,

в то время как его собственная, более продвинутая работа хранилась

в запасниках.

Использование метода Вуди Бледсо в современной технологии

распознавания лиц

В последующие десятилетия Вуди завоёвывал награды за вклад в

автоматизированные рассуждения. В течение года занимал пост

президента Ассоциации развития искусственного интеллекта. Но его

работа по распознаванию лиц в значительной степени оставалась

непризнанной и почти забытой, в то время как собирали лавры

другие.

В 1973 году японский учёный-программист Такэо Канаде (Takeo Kanade)

совершил большой скачок в технологии распознавания лиц.

На основе базы данных из 850 оцифрованных фотографий со

Всемирной выставки в Суите (Япония) в 1970 году Канаде разработал

программу, которая могла извлекать черты лица нос, рот и глаза без

участия человека. Канаде удалось осуществить мечту Вуди об

исключении человека из системы человек-машина.

За эти годы пару раз Вуди использовал свои знания в области

распознавания лиц.

В 1982 году его привлекли как эксперта к уголовному делу в

Калифорнии. Предполагаемый член мексиканской мафии обвинялся в

совершении серии ограблений в округе Контра-Коста. У прокурора было

несколько доказательств, в том числе кадры видеонаблюдения за

длинноволосым мужчиной с бородой, в солнцезащитных очках и зимней

шапке. Но на фотографиях обвиняемый представал чистовыбритым

мужчиной с короткими волосами. Вуди измерил лицо грабителя, сравнил

его с фотографиями обвиняемого и выяснил, что лица принадлежали

двум разным людям из-за разницы в ширине носов. Несмотря на то, что

мужчина всё же попал в тюрьму, он был оправдан по четырём пунктам,

где свидетелем выступал Вуди.

Только за последние 10 лет технология распознавания лиц научилась

работать с несовершенствами, говорит Анил К. Джейн (Anil K. Jain),

учёный-программист Мичиганского государственного университета и

соредактор Руководства по распознаванию лиц (Handbook of Face

Recognition).

Почти все проблемы, с которыми сталкивался Вуди, отпали. Cегодня

есть неисчерпаемый запас оцифрованных изображений. Через социальные

сети вы можете получать столько снимков лица, сколько захотите,

говорит Джейн. А благодаря достижениям в области машинного

обучения, объёму памяти и вычислительной мощности компьютеры

эффективно самообучаются. Учитывая несколько простых правил, они

могут анализировать огромные объёмы данных и создавать шаблоны

практически для чего угодно, начиная от человеческого лица и

заканчивая пакетом чипсов никаких замеров с помощью планшета RAND

или метода Бертильона больше не требуется.

Даже учитывая то, как далеко зашло распознавание лиц с середины

1960 годов, Вуди Бледсо определил многие проблемы, которые ещё

предстоит решить в этой области.

Метод Вуди по нормализации изменчивости положения,

состояния лица по-прежнему используется. По словам Джейн, чтобы

сделать распознавание лиц более точным, глубокие сети часто

поворачивают лицо в анфас с помощью опорных точек на лице, чтобы

экстраполировать новое положение.

И хотя современным системам на основе глубокого обучения

программист не даёт явного указания идентифицировать носы и брови,

поворот Вуди в этом направлении в 1965 году задал направление

развития отрасли на десятилетия. Первые 40 лет главенствовал именно

метод, основанный на выделении признаков, говорит Такэо Канаде, в

настоящее время профессор Института робототехники

Карнеги-Меллона.

Сегодня в какой-то степени вернулись к тому, что напоминает первые

попытки Вуди разгадать человеческое лицо, когда он использовал

вариацию метода кортежей для поиска паттернов похожих черт в

гигантском поле точек данных. По словам Анил Джейн, как бы ни были

сложны современные системы распознавания лиц, они просто сравнивают

пары изображений и присваивают им оценку схожести.

Но, возможно, самое главное это то, что работа Вуди Бледсо задала

этический тон исследованиям в области распознавания лиц сохраняющим

актуальность и проблематичным. В отличие от других технологий,

меняющих мир, катастрофические возможности которых стали очевидны

спустя годы соцсети, YouTube, квадрокоптеры потенциальные

злоупотребления технологией распознавания лиц были очевидны

практически с момента её зарождения в компании Panoramic.

Многие предубеждения, которые можно списать на пережитки времени

исследований Вуди привлечение к экспериментам практически только

белых людей, кажущееся беспечным доверие к государственной власти,

желание использовать распознавание лиц для дискриминации по

расовому признаку, всё это присуще и современной сфере

распознавания лиц.

В 2019 году в ходе тестирования программного обеспечения

Rekognition от Amazon 28 игроков НФЛ были ошибочно определены как

преступники. Спустя несколько дней Американский союз защиты

гражданских свобод предъявил иск Министерству юстиции США, ФБР и

Управлению по борьбе с наркотиками на предмет получения информации

об использовании ими технологии распознавания лиц от Amazon,

Microsoft и других компаний. В отчёте Национального института

стандартов и технологий за 2019 год, который протестировал код

более 50 разработчиков программного обеспечения для распознавания

лиц, говорится, что белые мужчины неверно сопоставляются с

преступниками реже, чем представители других групп. В 2018 году

пара учёных выступила с резкой критикой: Мы считаем, что технология

распознавания лиц самый опасный механизм наблюдения, когда-либо

изобретённый.

Весной 1993 года из-за дегенеративного заболевания БАС речь Вуди

ухудшилась. Но он продолжал преподавать в Техасском университете до

тех пор, пока его речь не стала неразборчивой. Он продолжал и

исследования в области автоматизированных рассуждений пока не

перестал держать ручку. До конца оставаясь учёным, Вуди делал

записи своей речи, чтобы отслеживать развитие болезни.

Вуди Бледсо умер 4 октября 1995 года. В некрологе не упоминалась

его работа по распознаванию лиц. На фотографии в некрологе

седовласый Вуди смотрит прямо в камеру и его лицо озаряет широкая

улыбка.

Комментарий Елены Герасимовой, руководителя направления

Аналитика и Data Science в Нетологии

Идеи Вуди Бледсо не имели коммерческого успеха, возможно, потому,

что их время пришлось на одну из зим искусственного интеллекта.

Было мало доверия к технологиям, не хватало мощностей для

демонстрации впечатляющих результатов, а технологиями воссоздания

мозга человека занимались в основном энтузиасты академик Андрей

Николаевич Колмогоров, американский математик Джордж Цибенко и

другие.

Тем не менее благодаря этим исследованиям стали возможны

современные прорывы, которые основаны на мощных вычислительных

мощностях, облаках, микрочипах.

В 1998 году подходы к распознаванию рукописных цифр

усовершенствовал Ян Лекун в его сети LeNet благодаря эволюции

вычислительных мощностей, которых не было во времена исследований

Вуди Бледсо

В 1998 году подходы к распознаванию рукописных цифр

усовершенствовал Ян Лекун в его сети LeNet благодаря эволюции

вычислительных мощностей, которых не было во времена исследований

Вуди Бледсо

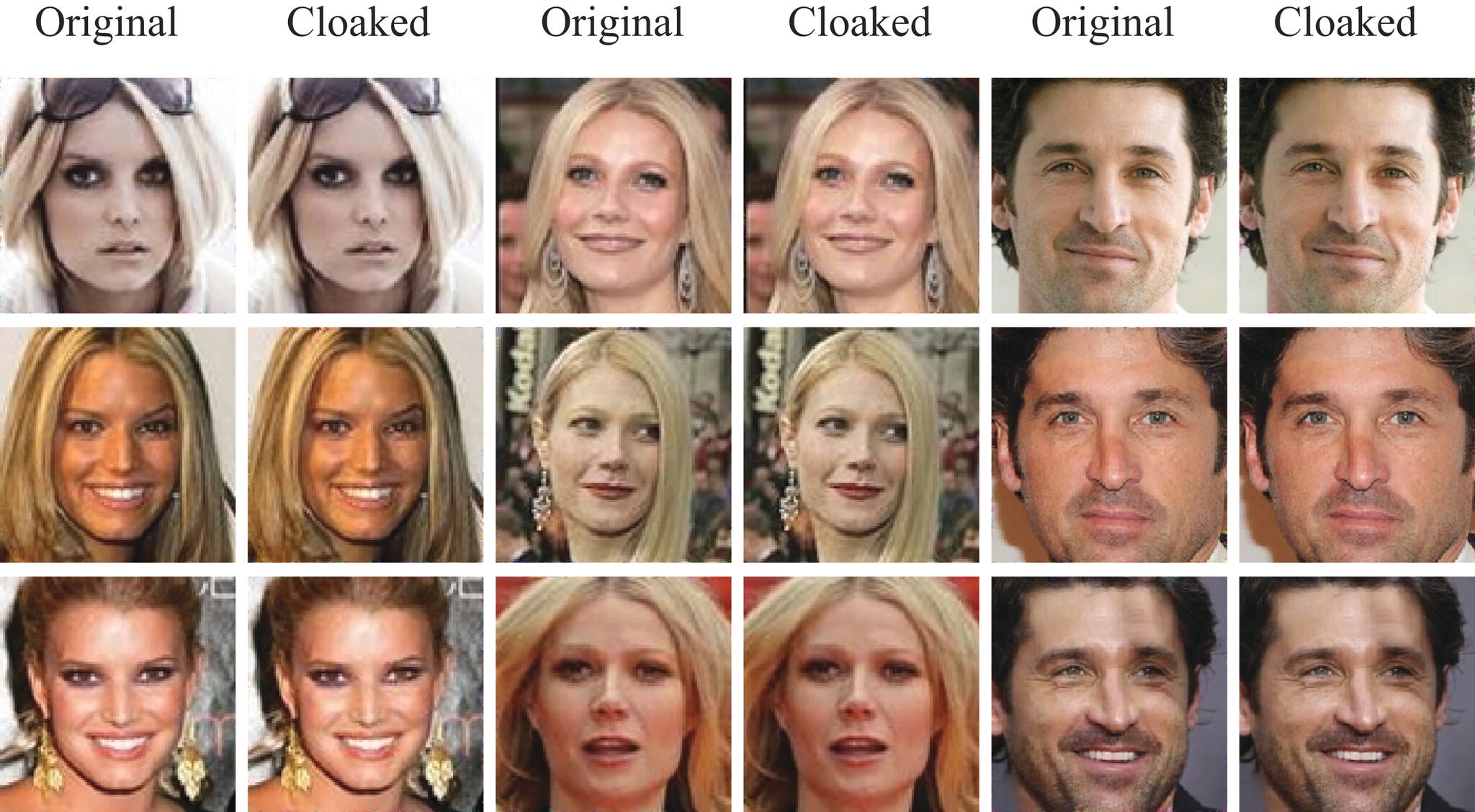

Технология распознавания лиц граничит с более продвинутой

технологией генерации лиц, которая используется для, например,

создания дипфейков и генерации лиц взрослых и детей, а также

котиков, собак. Казалось бы, что проще сделать фото человека и

загрузить его, условно, в электронный каталог одежды; или снять

симпатичное видео с младенцем и игрушками; или научить нейронную

сеть создавать изображение ребенка в одежде, интерьере или с

игрушкой, которую мы планируем размещать в каталоге и таким образом

демонстрировать? Ответ подскажет сумма инвестиций в компании

разработчиков технологии создания фотореалистичных изображений

только в США в 2019 году суммарный объём инвестиций составил более

500 млн долларов.

Генерация

фотореалистичных изображений людей

Генерация

фотореалистичных изображений людей

Если вам интересна работа с данными, нейронными сетями, предлагаем

познакомиться с нашими программами, обучение по которым опирается

на научную базу и исследования:

- Профессия

Data Scientist. Премия

Знак качества в номинации Подготовка профессионалов цифровой

индустрии (2019).

- Курс

Deep Learning. На лендинге курса сможете познакомиться с

примерами проектов в рамках курса и посмотреть, как проходит

обучение.

А тем, кто ищет подходы к внедрению искусственного интеллекта,

машинного обучения и цифровой перезагрузке, предлагаем посмотреть

информацию по курсу

Трансформация бизнеса: внедрение искусственного интеллекта.

Студенты создают стратегию внедрения искусственного интеллекта и

прорабатывают реальные бизнес-кейсы под руководством зарубежных и

российских экспертов.

Кадр из

фильма Пятый Элемент

Кадр из

фильма Пятый Элемент

Успешное соединение с HTTP Toolkit

Успешное соединение с HTTP Toolkit

Запрос открытия двери

Запрос открытия двери

Момент успешного распознавания, версия с

обработкой отдельных снимков

Момент успешного распознавания, версия с

обработкой отдельных снимков

Момент успешного распознавания, версия с

обработкой видеопотока

Момент успешного распознавания, версия с

обработкой видеопотока

На всех трех кадрах родитель

присутствует, но по отдельному кадру найти его бывает непросто

На всех трех кадрах родитель

присутствует, но по отдельному кадру найти его бывает непросто

На верхнем графике вероятность

присутствия родителя хотя бы плечом, а на нижнем вероятность того,

что родитель смотрит в камеру, например, общается с преподавателем

На верхнем графике вероятность

присутствия родителя хотя бы плечом, а на нижнем вероятность того,

что родитель смотрит в камеру, например, общается с преподавателем

Пример аугментаций на одном изображении.

Для наглядности аугментации сделаны до масштабирования к разрешению

64х64Код для аугментаций

Пример аугментаций на одном изображении.

Для наглядности аугментации сделаны до масштабирования к разрешению

64х64Код для аугментаций

Пример нормализации цвета на изображениях

из публичного датасетаКод для нормализации цвета

Пример нормализации цвета на изображениях

из публичного датасетаКод для нормализации цвета

Качество на отложенной выборке растет по

мере увеличения выборки для дообучения

Качество на отложенной выборке растет по

мере увеличения выборки для дообучения

Примеры итоговых GIF с улыбками нашей

коллеги и ее детей

Примеры итоговых GIF с улыбками нашей

коллеги и ее детей

Статистика дисконнектов. В этом уроке

был единственный дисконнект на стороне ученика

Статистика дисконнектов. В этом уроке

был единственный дисконнект на стороне ученика

Кликбейт

Кликбейт

Нормальная табличка сюда не влезла,

наслаждайтесь 10/10 шакалов

Нормальная табличка сюда не влезла,

наслаждайтесь 10/10 шакалов