Часть 1

Часть 2

Позиционирование, трэкинг. Full body tracking. Решения и

цены

Основное, что нужно знать.

Всё, что вы можете получить, используя Oculus Go, Google Dream,

Samsung Gear или мобильный телефон вложенный в шлем это 3DoF,

вращение головой. То есть вы не сможете перемещаться в

пространстве, двигаясь вперед, в шлеме вроде Oculus Go. У

полноценных шлемов типа HTC или Quest 2 куда больше степеней

свободы:

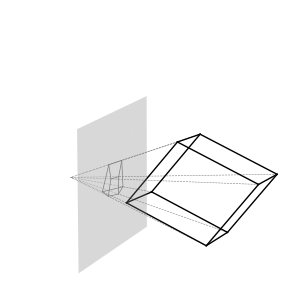

Кроме того, есть внутренний трекинг (использующий камеры на шлеме)

и внешние маяки (LightHouse или так называемые базовые станции) с

трекерами. Также есть камеры глубины типа кинекта и обычные камеры,

считывающие маркеры/ir-светодиоды.

Подробнее о принципах FBT можно почитать в этих статьях:

раз,

два.

Чем хорош и интересен Full Body Tracking?

Лично меня он заинтересовал после просмотра видео, где блогер

использует пинки в игре Blade and Sourcery:

Возможность использовать ноги в качестве оружия это качественно

новый уровень погружения и интерактивности, и рано или поздно это

станет игровым стандартом.

Vive trackers + LightHouse

Довольно дорогое удовольствие. Один vive tracker стоит от 10 до 17

тысяч рублей в зависимости от версии. Третий релиз трекеров легче и

работают они значительно дольше. Базовая станция 2.0 обойдётся в 25

тысяч рублей, б/у станцию 1.0 можно купить за 8-12 тысяч рублей.

Советуют использовать не менее 3-х трекеров.

Датчики обратно-совместимы. Можно использовать трекеры 3.0 с

базовыми станциями 1.0 и 2.0. Непонятно, с какой частотой они

обновляются (отслеживаются). Но вот

тут есть обсуждение этого вопроса.

Базовые станции первых и вторых версий отличаются довольно

сильно:

sdvuh, IXBT:

Главное, пожалуй, что БС 2 поколения могут работать до 4 штук

вместе и обеспечивать трекинг до 10*10 метров, а первого только 4*4

на 2 штуках. Но для обычного пользователя это, имхо, малоприменимо.

Ну и точность трекинга выше, типа не 1 мм, а 0,1 мм, тоже не

слишком важно)

Whisper, IXBT:

1. 2 бски могут стоять друг от друга по диагонали на 10 метров

против 5 метров у первых

2. Заявляли большую точность по сравнению с первыми станциями. В

целом мне и первых БСок тут хватает при стрельбе из снайперки на

большое расстояние в Pavlov этого достаточно.

3. Поддержка до 4-х БСок для одной зоны (вот тут точно не помню

уже, может и больше). Первые только 2 б-ски поддерживают.

4. Ещё заявляли, что меньше движущихся частей и из-за этого выше

надежность. Но тут у меня сомнения, так как много слышал про

поломки вторых БС-ок и очень мало про первые.

Senso Suit

Преордер костюма с 15 трекерами, в каждом из которых вибромотор для

обратной связи + базовая станция), обойдется в 600$. На русских

порталах продают за 200 000.

Senso известна также своими перчатками Senso Gloves DK3 1000$ за

комплект.

Tundra tracker

На кикстартере появился

Tundra tracking с более демократичными ценами, прямой конкурент

HTC.

Комплекты уже включают в себя базовую станцию для отслеживания

трекеров:

3 трекера 300$, 22 500р

5 трекеров 456$, 34 200р

7 трекеров 630$, 47 250р

SlimeVR Full Body Tracker Crowdfunding Pre-Launch

Также готовится к выходу

SlimeVR, комплект из 5 датчиков за 140$. Про него можно сказать

только то, что частота обновления будет 100 герц, и они могут

работать без подзарядки до 15 часов.

Cookie-Body Tracking DK1 180

Главная цель

проекта сделать FBT как можно более дешевым.

Работает в 120 герц, 1 cm precision, 85x55 FOV, 3m range. Обещают

отдать комплект за 600 SEK (5400 руб).

Преордер обещают на Kickstarter к концу апреля.

Латенси в районе 3-5мс и трекеры не требуют батареек.

Судя по всему, это трекинг при помощи распознавания маркеров (?). В

Driver4VR, например, недавно

появился такой режим.

Может быть, CookieBody будет работать лучше/быстрее, чем

Driver4VR?

Демонстрация.

Shockwave-костюм

Костюм из спандекса за 265$ c 12 IMU-трекерами и 64 точками для

имитации прикосновения (ну или для ощущений от взрыва гранат) при

помощи вибромоторов.

Первые, кто вложился в

проект, могли заказать за 195$.

На май-июнь запланировано производство, и в июле уже будут

отгружать. Также они планируют трекинг для ног и перчатки.

Костюм нативно поддерживает SteamVR, может использоваться через

Driver4VR. Указано, что поддерживает следующие игры: The Age of

Monsters, Sci-WAR: 2220 и Ghost Assassin VR, VR Chat, Skyrim VR,

Fallout 4, Alyx.

К сожалению, не нашёл частоту обновления. Если вас заинтересует

костюм поищите

у них в

дискорде или в комментах на кикстартере.

Почему так дёшево? Думаю, основная причина в том, что Shockwave не

использует внешний трекинг, а использует IMU (Инерционно

измерительный блок) то есть акселерометры. Такой вид трекинга можно

назвать инерционным.

Пять месяцев назад многие бейкеры в комментах требовали видео с

доказательством, что костюм работает. Судя по тому, что в комментах

видны отменённые заказы пруфы были предоставлены не в срок. Сейчас

видео с демонстрацией есть, но в любом случае, будьте осторожными и

оцените риски перед заказом.

Самый доступный трекинг для VR

Driver4vr позволяет использовать Kinect (1500р с авито) или PS Eye

для полного трекинга тела.

Кроме того, при помощи Driver4vr можно использовать и обычные

вёб-камеры + маркеры из кубиков, прикреплённые к телу.

Нативно Driver4vr не поддерживает несколько кинект-камер, а ведь

именно это приходит сразу в голову. Однако это не фантастика:

Странно, конечно, что у драйвера до сих пор нет поддержки

RealSense-камер, которые должны быть уже намного более

технологичными, чем Kinect.

Что именно выбрать, зависит от размеров вашего кошелька. Один

Kinect справляется с трекингом хуже, чем две базовых станции HTC.

Но и стоимость HTC больше чуть ли не в 10 раз.

Вот здесь попытались сравнить качество трекинга Kinect/HTC:

Отмечу также, что на форумах писали, что Kinect+Driver 4VR

потребляет довольно много CPU, так что непонятно, потянет ли

компьютер сразу два кинекта.

*Driver 4VR не поддерживает 2 кинекта, но на ютубе можно найти

демонстрацию, где задействовано несколько кинектов.

Системы перемещения в VR

Virtux Omni

Я позвонил представителям в России и представился обеспеченным

человеком, который хочет купить себе версию дорожки для дома. Но

оказалось, что даже вымышленный обеспеченный Я не настолько богат,

чтобы себе это позволить.

10 500$ платформа, два пояса, 4 пары обуви.

13 000$ платформа, датчики, два пояса и 8 пар обуви.

Пока проходим мимо.

ROVR

Гораздо более демократичные цены, чем у Omni ROVR1

обойдётся в 700

евро.

Стоит, правда, отметить, что доставка таких больших и тяжелых

устройств может быть довольно дорогим удовольствием.

Cyberith Virtualizer

600-1000$ в зависимости от комплекта.

600-1000$ в зависимости от комплекта.

Kat Walk

Первое, что хочется узнать про платформу для VR это цена. У KAT

WALK C она не то чтобы совсем неподьёмная

1499$ (164 т.р)

Про Kat Walk на Pikabu я увидел следующий отзыв:

1) В комплекте идут резиновые накладки на ноги разных

размеров с пластиковыми (скорее всего) шайбами на подошвах. Резина

рвётся, шайбы царапают поверхность.

2) Делая большой шаг (а в очках естественно вы не видите края

платформы ) будут постоянные зацепы за этот край. Это бесит

3) Нельзя поиграть в любую игру которую захочешь. Надо чтобы игра

была оптимизирована их разработчиками. Список таких игр на прошлый

год был весьма скромный. В их магазине есть и простенькие игры с

уровнем графики относительно современных мобильных телефонов, НО!

бесплатных там всего пару штук. За все остальные надо платить, при

чём ты не можешь купить эту игру. Ты покупаешь время, которое

проведёшь в игре. И цены по лично моим меркам дурные.

4) После каждого перезапуска надо делать калибровку, чтобы при

физическом передвижении вперёд персонаж не двигался назад.

Калибровка иногда дико выпендривается и надо ковырять вручную ПО,

чтобы прописывать положение пояса.

5) Сам пояс в плане комплекции игрока вообще не универсальный, как

по обхвату талии, так и по высоте человека.

6) Херовы датчики 6 если быть точнее. Один ресивер получает данные

с двух датчиков ног и ещё один получает данные с металлической оси,

на которой висит пояс + датчик позади пояса в области поясницы.

Далеко не всегда вся эта песня хочет синхронизироваться друг с

другом.

7) Опять же, не знаю как сейчас, но мы покупали две установки,

которые комплектуются терминалом, похожим на тот, в котором

пополняется мобильный счёт и оплачиваются всякие гос.услуги.

Большая тяжелая е**ла с отвратительной антивандальной клавиатурой,

которой невозможно пользоваться.

8) Поверхность чаши покрыта несколькими трапециевидными листами то

ли пластика, то ли тонкого металла. И не дай б**ь боже начнутся

задираться уголки этого материала (а они априори начнут). Всё,

пиз**ц. Плюс эту поверхность надо постоянно смазываться перед игрой

какой-то силиконовой полиролью.

9) Ох сколько раз в кураже мы бились руками и геимпадами о

металлическую трубу, которая идёт от платформы вверх и держит всю

конструкцию

Не знаю где вы нашли их за $1500, мы покупали примерно за 120000

грн каждую + растаможка и доставка обошлась примерно столь

же

Kat Loco

Гораздо интереснее и доступнее выглядит

Kat

loco. Комплект состоит из трёх трекеров, которые крепятся на

ногах и поясе и позволяют перемещаться по VR вполне естественно.

Однозначно не у всех найдется место дома, куда можно поставить

большую платформу типа KAT Walk C, поэтому Kat Loco вариант. Более

подробно о нём напишу чуть ниже.

Цена вопроса 230$

Впечатления по Kat Loco от Ивана Ивко

(IXBT):

Кто не в курсе, это набор датчиков из 3 штук, на пояс и лодыжки,

которые позволяют двигаться в играх за счет перемещения ног. Это

шагание на месте и некоторые другие опции. Kat Loco помогают

освободить руки а так же использовать датчики для захвата

движений.

Сразу предупрежу, я тестил часа 2, и в игре из этого времени был

минут 15, т.е. это скорее впечатления от процесса настройки, чем от

игрового процесса.

1) Базовая настройка и подключение. В целом, все достаточно просто

и по инструкции, но было 2 момента, на которые я убил основное

время, это Kat gateway (утилита управления) должна стартовать от

имени администратора, иначе она не может взаимодействовать со

SteamVR (считывать положение шлема, эмулировать контроль,

встраиваться в оверлей). Это, в принципе, в FAQ на сайте описано

(на 4 странице, ага), но не очевидно и без привязки к главным

симптомам (только к части), как будто это редкая ситуация.

При этом сама утилита никак не сообщает, что у нее какие-то

проблемы взаимодействия, просто не делает то, что должна. Минут 20

убил на эксперименты и переустановки.

Датчики беспроводные, но для связи с компьютером и отслеживания в

пространстве используется собственная базовая станция, поэтому

требуется калибровка при первой установке и смене места игры

(кстати, в инструкции указано, что отслеживание гарантируется при

расстоянии до базовой станции от 1 до 2 метров, 1,5

оптимально).

Тут у меня произошел затык, поскольку для калибровки требуется

всячески вращать датчик согласно инструкциям на экране. При первой

калибровке я его вращал диодомом, обращенным к БС (что показалось

логичным, т.к. именно так он будет во время игры закреплен на

поясе). А по факту оказалось, что это надо делать держа диодом к

себе.

К чему это привело после первой калибровки я в играх двигался туда,

куда хотел, только когда смотрел на БС, а стоило чуть чуть

повернуться, направление движения поворачивалось в другую сторону.

Отследить это можно прям в стиме, в оверлее есть меню Кат со

статистикой, которое отображает угол поворота шелма и датчиков, и

было видно, что эти углы в разные стороны меняются. Но тоже, я не

сразу допер, что дело в неверной калибровке.

Также, говоря о настройке, стоит упомянуть о необходимости

калибровки направления. Тут суть в чем глядя прямо вперед и стоя

ровно жмется кнопка калибровки, в итоге синхронизируются углы

поворота датчика и шлема (чтобы при дальнейших поворотах менялись

равномерно). Про необходимую частоту этой калибровки в инструкции

написано обтекаемо при старте игры и если заметите неточности в

определении направления движения. По факту, у меня средний датчик

висел на поясе шорт и слегка сползал туда сюда, в результате чего

синхронизация углов слегка сбивалось (на 10-15 градусов). И это

приводило к тому, что, к примеру, когда я пытался идти вперед, в

игре персонаж двигался не вперед, а под небольшим углом от этого

направления. Калибровка это исправляла, но ненадолго.

Вероятно, крепить надо на ремень или т.п., чтобы жестко держалось,

позже это проверю.

2) Возможности

Базовый режим перемещение вперед, когда шагаешь. Именно эту часть я

потестил меньше всего, т.к. была глубокая ночь, и не хотелось

топать и будить соседей. Дополню отзыв позже, пока отмечу, что мне

показалось недостаточной чувствительность. Я начал двигаться только

когда выкрутил ее на максимум. Правда, уже после еще раз посмотрел

рекламные видео, в них человек шагает не очень высоко, но часто, я

же шагал реже, но высоко поднимая ноги. Мб в этом дело.

Даже когда датчик шагов срабатывал, была явная задержка между

началом шагов и началом движения в игре, по ощущениям что то типа

0,5 1 секунды. Насчет быстроты остановки не скажу. Замечал при

движении рывки (т.е. шагаю, двигаюсь вперед, остановился, снова

начал двигаться, хотя я не прекращал шагать). Мб это было связано

как раз с неправильным шаганием.

(тут отмечу, что разрабочики заявляют о поддержке румскейл, т.е. мб

тут как раз логика, чтобы когда ходишь медленно, локомоушн не

врубался, и можно было своими ногами по комнате перемещаться, а

начинаешь часто шагать локомоушн).

Про возможность бега не скажу. Заявлено, что чтобы бежать в игре,

надо шагать еще чаще, но у меня пока и с просто перемещением

проблемы)). Буду дальше тестировать.

- Привязка направления перемещения. По умолчанию привязано к

направлению шлема, однако есть опция независимого осмотра. Т.е.

можно идти куда-то и при этом вертеть головой по сторонам, смотреть

в другую сторону. Фича работает.

- Режим бокового перемещения (опция). Отставляешь ногу вбок,

движется вбок. (есть еще какой-то альтернативный режим с поворотом

лодыжки но я его пока не вкурил)

- Режим Движения назад (опция). Отставляешь ногу назад, движется

назад.

- Режим Круиза (опция). Выставляешь ногу вперед, движется

вперед.

В основном я тестировал в последних трех режимах на

чувствительности по умолчанию, т.к. они тихие. Чувствительности по

умолчанию тут хватает. задержка начала движения +- такая же, как и

при шагании, отслеживается четко, прерываний движения нет.

Минусы

- То, что я писал выше про необходимость калибровки направления.

Выставляешь вперед левую ногу, движешься вперед. Чуть покрутишься,

выставляешь правую начинаешь двигаться не вперед, а вперед и

вбок.

- (главный на мой взгляд минус) движение в этих трех режимах

дискретное. Т.е. Вперед назад влево вправо. Нельзя держа ногу

впереди сдвинуть ее правее и начать двигаться вперед вправо все

равно будешь двигаться вперед. Только когда совсем вправо ногу

сдвинешь, начнешь двигаться уже только вправо. Написал по этому

поводу разрабам, чтобы сделали непрерывную (а не дискретную) смену

движения в зависимости от положения ног (что, ИМХО, логично), мб

пофиксят. Это бы решило и первую проблему (калибровки), т.е.

движешься чуть не туда ну сдвинул ногу вбок и норм.

3) Поддержка в играх, возможность конфигурирования

Система, по сути, эмулирует нажатие определенных кнопок с

контроллеров. Т.е. указываешь в профиле для игры, какой джойстик

используется для локомоции и какая кнопка за это отвечает и вперед.

ОФициальный список поддерживаемых (т.е. для которых профили

протестировали) игр довольно велик, порядка 100 штук. Но

наблюдаются несостыковки, к примеру, в No Man's Sky у меня

перемещение не работало, а потом я понял, что это потому, что

профиль сделан под раскладку вайв махалок (т.е. движение по нажатию

курка), а у меня индекс контроллеры (движение по стику). Но

кастомные профили как для существующих, так и для отсутствующих игр

создаются очень легко, так что это не проблема. Т.е. я бы сказал

что проблем совместимости быть не должно,

Еще интересно, что нет выбора кнопки для бега, хотя возможность

перехода на бег заявлена (и даже можно указать для игры, зависит ли

скорость перемещения от скорости шага или же сразу максимальная).

Просто в той же NMS на индексе это не банальное нажатие на левый

стик, а нажатие при беге на правый стик.

В целом, по итогам короткого теста, я бы сказал, что штука

интересная, но несколько сырая, не вставил и вперед играть. Я

безусловно буду еще разбираться, мб чего-то не понял или сделал не

так, буду пробовать с ней играть, позже напишу впечатления, как

наиграю хотя бы 10 часов.

Погонял еще Kat Loco.

Пока 10 часов не наиграл, так что не буду спешить с

впечатлениями.

Кратко

1) Если шагать как в рекламном ролике (т.е. часто и мелко, а не

редко и высоко) отслеживает хорошо, можно ходить без рывков.

2) В разных играх это несколько по разному. Если в Павлов рывки у

меня все же случались изредка, то в но мен з скай очень плавно

перемещаюсь, без рывков, при примерно одинаковом темпе ходьбы. Есть

параметр-настройка для игр, коэффициент передачи движения в игру,

попробую с ним поиграться, мб в этом дело (вероятно, условная

мертвая зона стиков (с точки зрения игры) разная)

3) Как работает отвязка от направления контроллеров/шлема.

Судя по всему, кат считывает положение тела и (в зависимости от

настроек) шлема и контроллеров. Далее если выставлена настройка

отвязать перемещение от взгляда при получении сигнала движение

передает команду наклон стика (условно, в зависимости от того,

какой контроллер используется со шлемом), причем не вперед, а в

таком направлении и под таким углом, чтобы компенсировать поворот

контроллеров/шлема, и двигаться в направлении тела. Видно, если

бежишь вперед и машешь контроллером влево вправо, этакие рыскания,

когда Кат вносит поправки на лету.

В разных играх работает по разному, в Павлове и НМС хорошо (игра

была в библиотеке от разработчика), а в ходячих работает странно

ведешь контроллером правее, начинаешь двигаться слишком сильно

левее и наоборот корректировки некорректно работают. Но при этом

вполне нормально работает, если выставить в настройках Кат Локо

привязка к HMD (в игре остается привязка к направлению

контроллера). Когда идешь, если смотреть в сторону, небольшое

смещение вбок добавляется, но несущественно.

WalkOVR

От 84$

От 84$ за

один датчик до 229$ за 5 датчиков.

Обзор:

Принцип примерно тот же, что у Kat Loco.

Сравнение Kat Loco и Walkovr:

WalkOVR

Kat Loco

На последней минуте обзора ютубер говорит, что ему больше нравится

Kat Loco.

Virtusphere

Нельзя не вспомнить и про

ВиртуСферу.

Поставляется развлекательным паркам, скорее всего, ценник 10

000$+

Это, видимо, ранняя версия:

Infinadeck

Infinadeck

Большая, громоздкая, дорогая всенаправленная беговая дорожка.

Real Go

Создается

студентами ИТМО, выглядит недурно, но сколько будет стоить

непонятно.

Устройства для игр в сидячем положении

Cybershoes

Принцип действия вы сидите на стуле (он должен уметь вращаться

вокруг оси) и перебираете ногами. Цена 369$. Непонятно, почему так

дорого вроде, относительно простое устройство.

3Drudder

Давишь на пятки идёшь назад, давишь носками идёшь вперёд. Чем

больше наклон тем выше скорость. За 100 баксов можно купить на

Amazon.

Мне не очень нравятся как сидячие игры, так и данные устройства. В

тот же шутер хотелось бы играть стоя чтобы приседать и стрелять из

укрытия, выглядывать из-за угла. Что касается беговых дорожек

сомневаюсь, что цены могут значительно понизиться, и это довольно

громоздкое устройство, как ни крути.

Оптимальным устройством для передвижения в VR кажется Kat Loco, но

к нему есть ряд вопросов.

Система не имеет своего трекинга и базируется на акселерометрах.

Kat Loco может срабатывать ложно, либо не срабатывать совсем.

Даже в случае если эти проблемы будут решены вряд ли те жесты, что

есть для управления устройством, сейчас идеальны. Для стрейфа,

например, нужно довольно сильно отставить ногу влево. Получится ли

в шутерах сделать это быстро, или лучше использовать стик?

Останется ли возможность прямо из игры отключить Kat Loco и сделать

пару шагов по комнате естественным образом?

Но мне кажется, для того, чтобы это устройство корректно работало

на нём должен быть трекинг. Было бы неплохо, если бы софт работал

вместе с внешним трекингом. Также вполне логично ожидать

акселерометры сразу в трекерах, чтобы обходиться без покупки Kat

Loco.

С другой стороны нужно ли будет такое управление, если мы сможем

управлять движением в VR с помощью мысли? Или передвижение с

помощью мыслей, а не движения ног может убить погружение? Возможно,

мы так и продолжим использовать в VR наши руки и ноги, даже когда

мы сможем управлять персонажем с помощью мысли.

На ютубе, кстати, есть видео Home Made VR BOOTS, в котором парень

сделал примерно тот же Kat Loco. И главное, что его побудило на это

тошнота при перемещении в VR при помощи обычных контроллеров:

Мне кажется логичным попробовать создать контроллеры для ног.

Что-то вроде педалей, которые можно было бы использовать стоя,

чтобы не терять мобильности. Большие пальцы ног, например, вполне

можно использовать, чтобы нажимать на кнопки. Это может быть

сделано в виде тапок/стелек с кнопкой, или в виде контроллера,

который бы надевался на большой палец и был направлен кнопкой к

полу. Чтобы было меньше ложных срабатываний, можно использовать

даблклики.

Возможно, стоит попробовать поискать мышцы на теле, которые не

используются во время игры,

прилеплять туда EMG-сенсоры и использовать их для контроля

передвижения.

На Ali есть готовы сенсоры для Arduino.

Как может выглядеть игра, которая это использует:

Тут видео с созданием одного из таких контролеров:

С удовольствием купил бы пару таких контроллеров в виде готового

решения чтобы вся установка заключалась в переназначении клавиш

(при срабатывании) и настройке чувствительности. А также с

документацией, какие точки и мышцы лучше всего использовать.

Вообще, люди, далёкие от сферы контроллеров, даже не представляют,

сколько разных решений пытаются воплотить в жизнь для того, чтобы

нормально взаимодействовать с компьютерами. Вот, например,

контроллер, который располагается во рту. Для того, чтобы с

помощью него управлять смартфоном, контроллер нужно крутить на

языке, зажимать зубами, возможно, даже посасывать.

И ещё одна интересная самоделка для передвижения в VR:

В главе Motion Sickness можно увидеть, что есть также любопытные

программно-аппаратные решения, которые решают проблему перемещения

в VR.

Костюмы с обратной связью

Самое интересное в этом секторе это Teslasuit, который может бить

током (миоэлектростимуляция) в любую из 68 точек, вызывая

сокращение мышц. Помимо этого костюм способен передавать холод,

тепло и у него есть инерционный трекинг.

Демонстрация:

Цена на Теслу, как и в случаев одноименного автомобиля, не

бюджетная более 5000$

Искренне не понимаю, почему пока нет ни одного проекта DYI-костюма,

который бы использовал электромиостимуляцию.

4*4 см/5*9 см EMS электрода колодки стимулятор нервной мышцы

силиконовый гель десятки электродов цифровой акупунктурный

физиотерапия десятки подушек с али-экспресса.

4*4 см/5*9 см EMS электрода колодки стимулятор нервной мышцы

силиконовый гель десятки электродов цифровой акупунктурный

физиотерапия десятки подушек с али-экспресса.

Весьма бюджетно, как и сам китайский прибор.

Если у кого-то вдруг появится желание сделать что-то похожее готов

к кооперации. У меня есть контакты профессиональных швей и

закройщиц, могу поучаствовать деньгами и найти людей, которые

помогут с ардуино или программной частью, но совершенно не знаю,

как создать и реализовать схему устройства и сопряжение с ардуино.

Тут нужно иметь возможность влиять на силу тока, частоту и

длительность разряда.

На тему применения электродов для обратной связи есть довольно

интересные и перспективные исследования.

Есть возможность манипулировать человеком при помощи EMS. Вот тут,

например, подают немного электричества на ногу в случае, если

комната маленькая, а человек уже близко подходит к стене.

Что интересно, пока я гуглил про EMS в VR, я нашёл видео, где

пытаются ускорить человеческую реакцию посредством

электростимуляции:

А вот это уже интереснее:

Об этом эксперименте я узнал благодаря каналу VR Studio.

Mean Gene Hacks выложил видео, как он испытывал гальваническую

стимуляцию вестибулярного аппарата малыми токами, играя в

гонки:

Самое устройство было изобретено давно, он лишь его немного допилил

и сделал современным.

Подробнее о самом устройстве, где есть схема сборки:

Стоимость сборки около 50 баксов.

Работа с вестибулярным аппаратом также может быть полезна для того,

чтобы новичков не тошнило в VR.

Аналогичная сборка.

Тут я могу порекомендовать походить по профилям учёных, участвующих

в проекте. Например по проектам, в которых участвует Pattie Maes из

MIT. У него

много работ по HCI (Human Computer Interaction):

Вернёмся к жилетам.

На рынке есть относительно бюджетные

Tactot и

TactSuit от bhaptics.

Жилеты используют вибромоторы для симуляции тактильных

ощущений.

TactSuit X40 (40 вибромоторов) 499$

TactSuit X16 (16 вибромоторов) 299$

Haptic face (6 вибромоторов) 149$

Arms (6 вибромоторов для каждой руки) 249$

Hands (3 вибромотора для каждой руки) 249$

Feet (3 вибромотора для каждой ноги) 249$.

В комплекте получается совсем уже не детская цена в 1 395$, 104

т.р.

Из плюсов жилета можно отметить возможность подключения

аудиокабеля. Это позволяет использовать их при просмотре фильмов вы

будете чувствовать все басы.

Есть также Vest Pro Woojer с 6 точками обратной связи за 500$.

Эти жилеты используют запатентованный, мощный, полифонический и

бесшумный тактильный преобразователь Osci . Я так понимаю, это

что-то типа мини-сабвуферов.

Но всё, что есть сейчас на рынке, это только вершина айсберга.

Есть, например, стартапы,

которые создают искусственную кожу с помощью ультразвуковых

передатчиков.

В целом же костюмов мало, они примитивные и дорогие, с весьма

ограниченной поддержкой в играх. И их однозначно стоит где-нибудь

попробовать, прежде чем покупать. Но ситуация с костюмами для VR

всё же лучше, чем с перчатками.

Haptic gloves. Перчатки для VR с обратной связью

В целом, перчатки становятся дешевле и выбор довольно большой. 2-3

года назад я не видел перчаток дешевле 300-500 т.р, сейчас перчатки

появились и в потребительском сегменте.

Перчатки с обратной связью должны не только иметь трекинг пальцев и

руки, но и оказывать сопротивление нажатию или вибрировать.

Haptic-перчатки, которые могут оказывать серьезное сопротивление

(т.н силовые), пока находятся в районе профессионального сегмента

их используют для работы хирургов, спасателей и обучения

космонавтов. Сопротивление осуществляется при помощью магнитных

тормозов или через шумный компрессор. Стоимость выше 5000 $.

Самые интересные и продвинутые модели, заслуживающие внимания, это

HaptX Gloves DK2, Senseglove Nova и Teslasuit Glove.

HaptiX Gloves

DK2

Sensogloves

Nova

Sensogloves

Nova

В этом видео по таймкоду видны ранние прототипы Sensogloves Nova,

это довольно любопытно:

Teslasuit Glove

Я не особо понимаю, зачем нужны остальные перчатки. Они очень

дорогие, но с ограниченным функционалом. Как правило, там лишь

трекинг и вибромоторы. Вы можете почувствовать вибрацию при

прикосновении к объекту, но если вы попробуете сжать объект ваши

руки не встретят сопротивления.

Для игровых целей мне в таком случае куда ближе обычный контроллер

я хотя бы могу сжать рукоять и почувствовать, как будто это

пистолет.

Давайте рассмотрим одну из таких перчаток.

Manus gloves

Это Manus Gloves за 5000 $ и вот впечатления пользователя.

А так выглядят Senso Gloves DK3 за 500$

Основа перчаток 7 IMU-датчиков и 5 вибромоторов. Считывание 150 FPS

с отзывчивостью 10мс.

Перчаток довольно много, и у меня нет цели подробно рассказывать о

каждых. Достаточно просто увидеть общие тренды перчатки до сих пор

сырые, дорогие, возможно, бесполезные.

Но сейчас народ уже вовсю мастерит разные перчатки, в том числе с

обратной связью. На сборку некоторых ходит всего 22$. Сейчас такое

интересное время, что, может, какой-то из этих проектов и выстрелит

когда-нибудь на кикстартере.

В целом, чтобы отслеживать движение пальцев, VR-перчатки не

обязательны. Это умеют делать контроллеры HTC и Valve Index.

Есть также

Etee

контроллеры за 260 евро:

Есть поделки в виде трекинга рук и пальцев на основе Leap

Motion

Oculus Quest 2 умеет отслеживать руки и пальцы посредством камеры.

Я попробовал, и мне понравилось работает вполне сносно, думал,

будет гораздо хуже.

Технологии будущего

У VR есть ещё очень много проблем и ограничителей, они

только-только начали массово входить в нашу жизнь. Видеокарт нету,

либо они очень дороги. Даже самые топовые видеокарты с трудом тянут

разрешение 4-5k, а ведь уже есть возможность купить шлемы с 8k

разрешением и 200 FOV.

SLI и Crossfire вроде как умерли, и даже WiFi6 не обладает

достаточным каналом для того, чтобы передавать разрешение в 5к.

И это всё ещё очень дорогая технология, особенно, если ты хочешь не

только качественный шлем, но и полный трекинг. С OLED-экранами

шлемы делать перестали и делают на LCD, у которого есть свои

особенности. DPI оставляет желать лучшего. Но всё же свет в конце

тоннеля виден движение и развитие есть, прогресс уже не остановить.

Давайте расскажу, что может изменить VR в будущем.

CREAL

Это копипаста, к сожалению не нашёл источник:

Современные дисплеи это такие цветные плоские экраны, и они к

сожалению не способны передавать свет таким же образом, как он

поступает в глаза в реальной жизни. Эту проблему и пытаются

разрешить швейцарские инженеры из стартапа CREAL. Ну типа See Real

смотри реально.

Они разрабатывают так называемые Lightfield дисплеи, которые

способны передавать свет теми же самыми лучами, как и в реальной

жизни. Я не понял, как это конкретно происходит, но знаю, зачем это

нужно чтобы глаза сфокусировались как в реальной жизни, не

испытывая дискомфорта. Традиционные линзы выдают картинку только в

одной фокальной плоскости, поэтому механизм зрительной аккомодации

у пользователя не работает и зафиксирован тоже в одном значении.

Про аккомодацию тоже почитайте сами, я не понял её настолько, чтобы

пересказать коротко без ошибок. В моем понимании это способность

физически менять диоптрии своего глаза с помощью напряжения мышц

глаза для того, чтобы смотреть вблизи или вдалеке.

Ну а пока разрешение таких дисплеев составляет 1000 х 1000 пикселей

в области обзора 60 градусов.

Управление силой мысли, Brain Computer Interface.

Да, мы все ждём Neurolink, но уж сейчас у геймеров появляются

первые гарнитуры, которые способны вполне сносно работать.

MindControl

от Next-mind обойдётся в 400$.

Обзор на Habr.

Самые ощутимые проблемы это довольно большие задержки при

использовании и то, что нет игр и приложений (кроме трёх игр для

примера), которые бы это поддерживали прямо сейчас. Возможность

привязки горячих клавиш на какое-то мысленное усилие было бы

идеальным вариантом.

В области BCI происходит примерно то же самый замкнутый круг, что

был со шлемами для VR 10-15 лет назад. Пока не будет потребителей в

достаточном количестве не будет и игр. Пока не будет игр не будет

потребителей.

Надо отметить, что Next-mind далеко не первый стартап. Есть также

Neurosky

Mindwave.

О BCI и его значимости

очень много говорит Гейб.

Он утверждает, что игры будущего смогут чувствовать, когда игроку

скучно, и добавлять событий. В самом продвинутом варианте подлинно

знать, чего боится человек, и использовать его страхи. Да, одна из

серий сериала Чёрное зеркало была как раз об этом.

Возможно, Гейб в интервью намекает и на другую возможность не

только на чтение мысленной активности игрока, но и о

непосредственном воздействии на игрока.

Однако, чтобы считывать эмоции, возможно, вовсе не обязательно

использовать только нейроинтерфейсы. Есть, например, вот такое

интересное

исследование по электрогастрографии, в котором к людям

прикрепляли EGG-датчики в районе живота и наблюдали за

показателями:

Мы обнаружили, что отрицательные стимулы ослабляют

показатели парасимпатической активации EGG или активности отдыха и

переваривания. Мы сравниваем EGG с остальными физиологическими

сигналами и описываем значение для выявления аффекта. Кроме того,

мы представляем, как носимые EGG могут поддерживать будущие

приложения в таких разнообразных областях, как уменьшение тошноты в

виртуальной реальности и помощь в лечении расстройств пищевого

поведения, связанных с эмоциями.

Подробнее о Oculus Quest 2

Заказ с Амазона

Адрес доставки указывать на английском:

Baranov Vladimir Vladimirovich

Taganskaya 12-12 (Улица, дом, квартира)

Ekaterinburg,

Sverdlovsk region (Свердловская область)

620011

Russian Federation

С вас далеко не сразу после заказа спишут деньги, и после покупки

на Ali это было не привычно. У меня деньги списали через 3-5

дней.

Через несколько дней после этого на эл.почту (и по смс) пришло

сообщение от DPD (транспортная компания), в котором они попросили

заполнить на их сайте сведения для таможенного оформления (нужны

будут паспортные данные). В письме будет ссылка на их сайт, логин,

пароль и пин-код на это у вас будет пять дней.

Через некоторое время придет новое письмо, с требованием оплатить

таможенную пошлину, которая составляет 15% от стоимости товара

свыше 200$.

Далее вас проинформируют о том, что ваш заказ принят для доставки

там можно будет самому выбрать удобное для доставки время. 2 мая я

сделал заказ на Амазон, а 21 курьер уже привез мой заказ.

Кабель и роутер я заказал на Ali. Кабель обошелся в 1200р, роутер в

5.2т.р

(Xiaomi Redmi AX6 WiFi 6 6-ядерный 512M сетчатый домашний IoT 6

усилитель сигнала 2,4G 5 ГГц оба 2 двухдиапазонных OFDMA).

Что касается моделей роутеров, VR-комьюнити сделало

вот такую табличку.

SideQuest

Игры в магазине Oculus Quest 2 очень дорогие, бесплатных вообще

единицы. Включив режим разработчика и поставив SideQuest, можно

поиграть в неплохие игры бесплатно или за относительно небольшую

плату.

Для установки необходимо сделать несколько шагов:

1 Шаг.

Аккаунт разработчика.

2 Шаг.

Установка ADB драйвера.

3 Шаг. Активируем режим разработчика в Oculus app на смартфоне

4 Шаг.

Качаем и

устанавливаем SideQuest

5 Шаг. Коннектимся по кабелю. Разрешаем отладку по USB, надев

шлем.

Подробный гайд по настройке.

SideQuest можно установить даже на телефоне, недавно появился

экспериментальный режим передачи игр на гарнитуру без кабеля, через

wifi.

Кстати, зарегистрироваться в SideQuest на компьютере у меня так и

не получилось регистрация работает только с телефона.

Из приложений могу порекомендовать Pavlov VR Shack компьютер для

игры не нужен, хотя мобильная графика шлема, конечно, гораздо

слабее ПК-версии. Она сейчас где-то на уровне 2000-2003 года (Half

Life-1, Halo).

В этом видео как раз рассматривают самые популярные шутеры Oculus в

плане технологичности графики:

Motion Sickness

Меня слегка укачивает в играх, где нужно передвигаться на стиках.

Не так чтобы это было большой проблемой даже не тошнит, но есть

дискомфорт. Периодически у тела возникает потребность расставить

широко ноги, как будто я на корабле. В шутерах, на самом деле,

довольно сложное управление, к этому надо привыкнуть. Я

одновременно использую стик для передвижения и другой стик, чтобы

быстро вертеть головой, но вместе с этим я использую движение в

реальности, кручу головой и разворачиваюсь.

После игры дискомфорт остается на 30-40 минут.

После 20-30-минутной сессии игры реальность ощущается как VR.

Сложно объяснить это ощущение, но я не чувствую полного слияния со

своим телом. Как будто руки до сих пор виртуальные, немного чужие,

и я не чувствую полную и безоговорочную связь с ними. Иногда

возникает импульсивное движение взаимодействовать с реальностью

так, как я бы это сделал в VR (проскролить или меню вызвать).

Про укачивание и приёмы борьбы с ним хорошо

написано на ixbt.

Отдельно хочется привести пост sdvuh, как он отчаянно боролся и

учился передвигаться в VR играх:

Решил написать финальный отчет по своим тренировкам

smooth locomotion. Сразу предупреждаю от попытки перенять мой опыт

без критики и осторожности все люди разные и что русскому хорошо,

то немцу может быть смерть.

Изначально после покупки моей первой VR гарнитуры (HP reverb g2) у

меня выявилась острая непереносимость smooth locomotion (хождения

со стика), при первой попытке в своей первой игре (Alyx) при

нажатии на стик я сразу же потерял равновесие и чуть было не упал.

Попытки как то приспособиться привели к печальным последствиям я не

смог в этот день продолжить игру, а мысли о продолжении подобного

издевательства вызывали отвращение.

Более месяца я играл с teleport locomotion и проблем никаких не

имел, но было очевидно, что большая часть VR игр для меня

недоступна, что меня категорически не устраивало и я был уверен в

том, что проблему буду так или иначе решать. Я надеялся, что

накопление опыта в VR само по себе решит проблему, но я ошибался

это так совершенно не работает, по крайней мере со мной.

13 дней назад я утвердился в своих целях, окончательно понял, что

VR для меня это серьезно и что время решительных действий

пришло.

Первый день тренировок был очень коротким, я начал новое

прохождение Alyx, со smooth locomotion. Я смог 20 секунд походить

по стартовому балкону, покрылся холодным потом, ощутил рвотные

позывы и на этом решил (был вынужден) прерваться.

Вторую тренировку я тоже провел на этом балконе и сразу же

воодушевился прогрессом: я смог продержаться порядка 5-ти минут,

что меня очень удивило и обрадовало. Я даже научился худо-бедно

ходить вперед по прямой поднимая взгляд вверх, но перемещение

спиной и стрейфы меня просто уничтожали на месте.

Третий день ознаменовался выходом с балкона и попытками начать

прохождение, худо-бедно дошел до жилища Рассела.

В четвертый я устроил себе испытания и постарался довести себя до

предела, стреляя на ходу и маневрируя. Игровая сессия была

достаточно долгой по сравнению с предыдущими и ознаменовалась

особенно неприятными последствиями. Как раз именно четыре первые

дня были самыми тяжелыми, после тренировок у меня болела голова в

области темени и за глазами, учащалось сердцебиение, была некая

дезориентация в пространстве, а после четвертой, когда я лег спать,

у меня были т.н. вертолеты ощущение вращения комнаты и мнимая

подвижность тела при закрывании глаз.

Я не знаю, прав я или не прав (я так и не смог найти никаких

нормальных статей по тренировке вестибулярного аппарата), но я

самовольно решил, что для адаптации мозга ключевую роль играет

преодоление болезненных последствий укачивания, так что каждый день

старался себя довести до плачевного состояния, старался относиться

к своему вестибулярному аппарату как к подопечному, которого я

должен хорошенько нагрузить и замучить, т.е. у меня совершенно не

было цели худо-бедно проползти игру.

С пятого по одиннадцатый день у меня наблюдался постепенный

прогресс, последствия тренировок мне уже не портили вечер и не

влияли на сон, где-то к 7-му дню я понял, что окончательная победа

неминуема.

12-й день (вчера), был первый, когда я смог поиграть полтора часа

без последствий вообще (полное прохождение Alyx со smooth

locomotion я завершил), а сегодня (13-й), я себе устроил экзамен,

целенаправленно пытаясь раздолбать себе вестибулярный аппарат теми

средствами, которые может предложить Alyx я ходил спиной зигзагами

по поверхности с перепадами высот, старался фиксировать взгляд по

разным сторонам, в конце даже выставил через консоль 200% рендеринг

и отправился в большую открытую и светлую (я заметил, что чем

светлее, тем сильнее укачивает) локацию, которая перед Джеффом.

Игра начала лагать, картинка подергиваться. Вестибулярный аппарат

местами срывался, плыл, но быстро восстанавливался без каких-либо

последствий для самочувствия. Считаю, что я победил. Теперь

собираюсь поиграть в blade and sorcery, потом пройти medal of honor

и, наконец, грозу тошнотиков boneworks.

Также пройдемся по приложениям, которые занимаются реализаций

передвижений в VR. Они так же могут помочь с MS.

Natural Locomotion, которое позволяет двигаться

естественно. Для движения необходимо махать контроллерами, а для

прыжков прыгать:

Можно также ходить при помощи ног, используя для отслеживания массу

девайсов от смартфона и Vive трекера до PS и Switch

контроллеров:

Также имеется PocketStrafe, которые использует смартфон:

И

Freedom Locomotion VR от Huge robot vr.

Последнее выглядит весьма достойно. Например, чтобы сделать стрейф,

нужно вытянуть левую руку влево, и от скорости махания

контроллерами зависит скорость вашего передвижения:

К сожалению, PocketStrafe и Freedom Locomotion VR заброшены.

Игра в облаке

Одна из самых перспективных вещей для автономных шлемов типа Oculus

Quest 2 это игра в облаке. Будет здорово, если можно будет поиграть

в PCVR из любой точки мира. Сейчас в SideQuest доступно Shadow VR,

но я пока его не пробовал и есть сомнения, что мне хватит 100 Мбит

от провайдера для качественной трансляции потока.

Что ещё полезного из софта для пользователя VR?

Vorpx

Позволяет играть на шлеме в обычные игры, но в 3D.

Trueopen vr drivers. Позволяет использовать контроллеры для

создания бюджетного VR.

У разраба есть канал на Youtube, там есть довольно много забавного.

Например, вот такой контроллер:

На этом заканчиваю, надеюсь было интересно.

Сцена из древней игры Gabriel Knight:

Sins of the Fathers компании Sierra On-Line

Сцена из древней игры Gabriel Knight:

Sins of the Fathers компании Sierra On-Line

Выпуск курса МИП-7 ВШБИ, 2018 год

Выпуск курса МИП-7 ВШБИ, 2018 год

VR-игра Wolfenstein: Cyberpilot компании

Arkane Studios/Machine Games

VR-игра Wolfenstein: Cyberpilot компании

Arkane Studios/Machine Games

Год назад мне посчастливилось принять

участие в совместном проекте Эрмитажа и компании КРОК по

воссозданию виртуальной копии нескольких залов музея Эрмитаж

Год назад мне посчастливилось принять

участие в совместном проекте Эрмитажа и компании КРОК по

воссозданию виртуальной копии нескольких залов музея Эрмитаж

Виртуальная выставка картин художника

Александра Верстова в старинном замке VR-игры "Owling Crowling

Bowling". Иллюстрация предоставлена Яной Артищевой

Виртуальная выставка картин художника

Александра Верстова в старинном замке VR-игры "Owling Crowling

Bowling". Иллюстрация предоставлена Яной Артищевой

Lost Horizon музыкальный фестиваль в VR

Lost Horizon музыкальный фестиваль в VR

Процесс игры на VR-арене

Процесс игры на VR-арене

Dragonsnake VR

Dragonsnake VR

Визуальное программирование в Unreal

Engine с помощью blueprints

Визуальное программирование в Unreal

Engine с помощью blueprints

Данные исследований агенства Engine creative

Данные исследований агенства Engine creative Данные исследований агенства Engine creative

Данные исследований агенства Engine creative

Данные исследования агенства Engine creative

Данные исследования агенства Engine creative

Данные исследования компании PHYGITALISM

Данные исследования компании PHYGITALISM

Тестовая карточка товара маркетплейса Ozon

Тестовая карточка товара маркетплейса Ozon

Карточка товара с дополненной реальностью

бренда Mr. Puzz на маркетплейсе Wildberries

Карточка товара с дополненной реальностью

бренда Mr. Puzz на маркетплейсе Wildberries

процесс ЭКО: врач берет эмбриона, смотрит

в микроскоп, где лазером отрезает от него кусочек для анализа.

процесс ЭКО: врач берет эмбриона, смотрит

в микроскоп, где лазером отрезает от него кусочек для анализа.