16 ноября 2012 года на сайте Республиканского исследовательского комитета (Republican Study Committee, или RSC), объединяющего более 170 членов палаты представителей США от республиканской партии, появился занимательный доклад. Документ провисел в открытом доступе не более суток его убрали под предлогом того, что он не соответствовал принятым стандартам RSC и не прошел всех согласований. Впоследствии доклад так и не вернулся на страницы сайта. О чем же говорилось в этом документе и почему его так поспешно изъяли из публичного доступа?

Таинственный доклад, с полным текстом которого по-прежнему можно ознакомиться на Scribd, представлял собой последовательную критику сложившейся системы авторского права и вскрывал основные недостатки копирайта в цифровую эпоху. Хотя авторы документа закономерно опирались на законодательство США, многие обозначенные в нем проблемы актуальны для всего мира. Кратко перечислим основные тезисы.

1. Копирайт наносит ущерб науке, задерживая ее дальнейшее развитие

Многие научные работы XX века защищены авторским правом и отсутствуют в свободном доступе. А между тем их могли бы использовать в своих изысканиях молодые ученые и совершать новые открытия, способствуя дальнейшему научно-техническому прогрессу.

2. Копирайт ограничивает доступность литературы

Технически все когда-либо созданные человечеством печатные тексты можно было бы оцифровать и выложить в открытый доступ, создав гигантскую цифровую библиотеку, в которой любой желающий смог бы отыскать нужное произведение на предпочитаемом языке. Однако появлению такого ресурса препятствует копирайт. Даже в эпоху стремительного развития цифровой дистрибуции вам все равно приходится пользоваться услугами традиционных библиотек. И хотя ряд учреждений оцифровывают доступный книжный фонд для лучшей сохранности и внутреннего использования, по закону они не имеют возможности публиковать цифровые копии литературных произведений в сети.

3. Ограничение развития различных отраслей искусства

Если бы срок защиты авторских прав был разумно ограничен, это стимулировало бы появление множества новых произведений на основе старых. Так, например, фанатское сообщество, сложившееся вокруг Звездных войн, получило бы возможность не только создавать собственный контент, развивающий популярную вселенную, но и монетизировать его, что потенциально могло бы подарить нам с вами куда более интересные и увлекательные фильмы, чем невнятная последняя трилогия.

Ограничение сроков действия копирайта пошло бы на пользу и такому направлению, как создание ремиксов. Данная проблема в большей степени актуальна для США, хотя имеет место и в ряде других стран. Согласно законодательству Соединенных Штатов Америки, диджей может свободно играть ремиксы лишь на живых выступлениях, тогда как запись альбомов для большинства независимых музыкантов является роскошью, которую они попросту не могут себе позволить, поскольку авторские выплаты правообладателям достигают 100 тысяч долларов за каждый используемый семпл.

По мнению авторов доклада, решить эти проблемы можно лишь путем радикального сокращения срока действия авторских прав, который не должен превышать 12 лет. Сейчас копирайт действует на протяжении всей жизни автора плюс в течение 70 лет после его смерти.

4. Цензура

Доступ к документам, на которые могут опираться историки и журналисты в своих исследованиях, может быть ограничен под предлогом защиты авторских прав, благодаря чему заинтересованная сторона сможет препятствовать появлению неугодных ей публикаций, имеющих историческое или общественное значение.

Книги, преданные забвению

Все перечисленные пункты достаточно очевидны и вряд ли требуют научного базиса для подтверждения, однако подобные труды существуют. Одной из самых ярких работ является исследование американского писателя, профессора Иллинойского университета Пола Хилда. В своих изысканиях он опирался на WorldCat крупнейшую в мире библиографическую базу данных, созданную Фредериком Гридли Килгуром еще в 1967 году и успешно развивающуюся и по сей день. Этот ресурс содержит свыше 240 миллионов записей практически обо всех видах произведений, когда-либо созданных на 470 языках мирах, что позволяет собрать весьма точную статистику.

Профессор Иллинойского университета, писатель

Пол Хилд

Профессор Иллинойского университета, писатель

Пол Хилд

Проанализировав сведения, представленные на WorldCat, ученый обнаружил интересную закономерность. По мере распространения грамотности и развития технологий в XX веке, количество ежегодно создаваемых печатных трудов значительно превысило показатели XIX века, причем это касается как художественной, так и научной литературы. Для сравнения: в 1980-х годах было издано в 8 раз больше новых книг, чем в 1880-х. С учетом такого распределения можно было бы ожидать, что в ассортименте магазинов книги, написанные в конце XX века, будут встречаться примерно в 8 раз чаще, нежели книги, впервые увидевшие свет в конце века XIX. Однако на деле распределение выглядит совершенно иначе.

Как видно из приведенного графика, шансы встретить в магазине книгу, написанную в период с 1820 по 1920 год, значительно выше, чем что-то более современное. Все дело в том, что произведения, увидевшие свет в этот временной период, уже получили статус общественного достояния и могут быть перепечатаны без дополнительных авторских отчислений или выкупа эксклюзивных прав у автора.

Продавать новые романы выгодно лишь в течение ограниченного периода времени: при наличии должной маркетинговой кампании охватить максимум целевой аудитории удается уже в первые год-два, затем же продажи существенно падают, поэтому выпуск дополнительных тиражей оказывается нецелесообразным. И хотя затраты на цифровую дистрибуцию несоизмеримо ниже по сравнению с издержками на печать бумажных книг, издателю все равно необходимо иметь лицензию на распространение соответствующего произведения, а приобретать таковую на срок более 2 лет опять же не имеет смысла, если только речь не идет о каких-то мегапопулярных тайтлах. С научными трудами все совсем печально: будучи слишком нишевыми, они и так плохо продаются, исчезая с книжных полок куда быстрее проходных дамских романов.

Из всего сказанного выше профессор делает неутешительный вывод:

Авторское право в том виде, к которому мы привыкли, способствует снижению уровня доступности книг. Существующая модель бизнеса стимулирует издателей продавать новые книги лишь в течение пары лет после релиза. Повторно книги возвращаются в магазины лишь по истечении авторских прав, притом в гораздо меньшем ассортименте.

Как видите, первые два пункта неудобного доклада о вреде копирайта имеют вполне научное обоснование. Причем проблема заключается не только в невозможности создания глобальной библиотеки, на что сетовал автор, но и в снижении доступности литературы в целом, обусловленном особенностями издательского бизнеса.

Устранение конкурентов: быстро, эффективно, законно

Справедливость же третьего тезиса можно с легкостью подтвердить многочисленными примерами из игровой индустрии. Вспомним тот же MERP (Middle-Earth Roleplaying Project) глобальную модификацию для Skyrim, разработчики которой поставили перед собой весьма амбициозную цель, пожелав не просто в точности воссоздать в виртуальном пространстве мир Средиземья, но и сделать настоящую RPG мечты во вселенной Властелина колец, где игрок мог бы примерить на себя роль Фродо Бэггинса и пройти нелегкий путь от Хоббитона до Ородруина, дабы уничтожить Кольцо Всевластия, или же оставить могущественный артефакт себе, попытавшись стать новым Властелином.

Разработка мода началась в 2008 году. Изначально небольшая команда энтузиастов взяла за основу движок Oblivion, однако после выхода следующей части Древних свитков ребята, оценив возможности обновленного Creation Kit, решили перенести свои наработки на новые рельсы. Возможно, этот проект никогда не дошел бы до релиза, разделив судьбу множества других фанатских долгостроев, застрявших на этапе вечной альфы, а может быть, однажды мы с вами действительно смогли бы поиграть в величайшую ролевую игру всех времен. Однако финал этой истории оказался куда прозаичнее: 31 августа 2012 года моддеры получили официальное письмо от юристов Warner Bros. Interactive Entertainment, в котором правообладатель потребовал прекратить дальнейшую работу над модификацией, пригрозив энтузиастам судом. Оно и понятно: на тот момент студия Monolith уже работала над Middle-earth: Shadow of Mordor, официальный анонс которой состоялся всего год спустя, и Warner Bros. не хотела конкуренции даже в виде бесплатного мода.

Похожая судьба ждала и мультиплеерный шутер Star Wars: Galaxy in Turmoil. Фанаты вселенной Звездных войн, опечаленные отменой Battlefront 3, решили создать собственный мультиплеерный шутер с нуля, взяв на вооружение игровой движок Unreal Engine 4. Разработчикам удалось довести проект до вполне играбельного состояния и даже выпустить в раннем доступе Steam, но однажды письмо счастья пришло и на их e-mail.

Electronic Arts, получившая эксклюзивные права на разработку игр по легендарной вселенной, оказалась недовольна появлением подобной игры: лишние конкуренты, особенно на фоне лутбоксового скандала, разворачивающегося вокруг нового Battlefront, который EA на старте всеми силами пыталась превратить в pay-2-win-проект, издателю были не нужны, тем более в виде абсолютно бесплатной игры.

Однако авторы Star Wars: Galaxy in Turmoil не сдались. Они полностью удалили все ассеты, так или иначе связанные с франшизой Звездных войн, переформатировав игру в научно-фантастический сетевой шутер с элементами киберпанка. Данный шаг помог уберечь проект от закрытия, но не от краха: без должного продвижения, которое было не по карману разработчикам, без громкого имени и статуса наследника того самого Battlefront, который так полюбился сообществу, игра перестала развиваться, растеряв львиную долю пользовательской базы.

Двухмерный файтинг My Little Pony: Fighting is Magic один из тех редких примеров, когда фанатская работа смогла выжить после релонча. Подобно создателям Star Wars: Galaxy in Turmoil, получив иск от Hasbro, авторы файтинга (команда из 9 человек, известная в сети под именем Mane6) полностью переработали оригинальную игру и привлекли необходимые для завершения разработки средства через краудфандинговую платформу Indiegogo, сумев добраться до полноценного релиза, который состоялся 30 апреля 2020 года. На этапе перезапуска проекта команда Mane6 нашла неожиданную поддержку в лице аниматора My Little Pony Лорен Фауст, которая помогла энтузиастам с созданием новых персонажей для файтинга в характерном визуальном стиле. Новая версия игры получила название Them's Fightin' Herds.

Впрочем, история Them's Fightin' Herds скорее исключение, чем правило. В Hasbro обратили внимание на проект слишком поздно: на момент, когда Mane6 получила официальное требование прекратить разработку, файтинг уже был достаточно известен в кругу ценителей и даже едва не вошел в перечень официальных дисциплин ежегодного киберспортивного турнира Evolution Championship Series благодаря уникальным движениям и комбо. Сложись обстоятельства иначе, игра канула бы в Лету, как и многие другие подобные проекты.

Продолжение Chrono Trigger под кодовым названием Crimson Echoes (Square Enix), ремейк Metal Gear Solid (Konami), MMO во вселенной покемонов PokeNet (Nintendo) перечислять отмененные по воле правообладателей фанатские проекты и их убийц можно бесконечно. И если мотивацию той же Nintendo еще можно понять (как ни крути, японский гигант старательно развивает принадлежащие ему франшизы), то Konami ведет себя подобно собаке на сене из поговорки, ведь во вселенных некогда знаковых Silent Hill и Metal Gear сегодня выходят лишь автоматы патинко.

Вот как выглядит официальный ремейк MGS 3 от Konami

Вот как выглядит официальный ремейк MGS 3 от Konami

Но, так или иначе, все эти примеры наглядно доказывают правоту авторов упомянутого нами доклада о вреде копирайта в его нынешнем виде.

Правообладатели на страже нравственности

Четвертый же пункт претерпел в наше время весьма неожиданную трансформацию. Если авторы доклада говорили прежде всего о цензуре со стороны политических сил, стремящихся скрыть нелицеприятные факты о тех или иных событиях, то сегодня мы с вами сталкиваемся с таким явлением, как цензура корпоративная, которая зачастую оказывается куда более бессмысленной и беспощадной.

Обратимся к событиям лета 2020 года. 10 июня на фоне массовых протестов в США стриминговый сервис HBO Max снял с ротации нестареющую киноклассику Унесенные ветром. После закономерного недовольства подписчиков конгломерат WarnerMedia выпустил следующее заявление:

Унесенные ветром это продукт своего времени, изображающий в том числе некоторые из этнических и расовых предрассудков, которые, к сожалению, были распространены в американском обществе. Подобные расистские моменты были ошибочными тогда и неприемлемы сегодня. Мы считаем, что показ этого фильма без объяснения и осуждения этих моментов безответственен.

Все это противоречит ценностям WarnerMedia, поэтому, когда фильм вернется на HBO Max, он вернется с обсуждением его исторического контекста и осуждением подобных предрассудков. При этом кинолента будет представлена без изменений, ведь поступить иначе все равно что заявить, что этого никогда не существовало. Для создания более справедливого, равноправного и инклюзивного общества необходимо признать и понять собственную историю.

Вчерашняя классика может впасть в

немилость по воле трендов

Вчерашняя классика может впасть в

немилость по воле трендов

Спустя 15 дней фильм действительно вернулся в каталог HBO Max. Впрочем, иного исхода сложно было ожидать: вряд ли кто-то осмелился бы предать забвению картину, завоевавшую 8 статуэток Оскар и включенную в 1989 году в Национальный реестр фильмов США. Однако теперь перед началом фильма зрителям демонстрируется лекция профессора Чикагского университета кинематографии Жаклин Стюарт, повествующая о стереотипном изображении афроамериканцев в кино, а вторую часть картины предваряет запись круглого стола на тему Сложное наследие Унесенных ветром, состоявшегося на кинофестивале TCM в 2019 году.

А вот современным сериалам повезло куда меньше. Так, Netflix, BBC и BritBox отказались от проката скетч-шоу Маленькая Британия. Причиной этого послужило неподобающее поведение актеров, которые карикатурно изображали представителей других рас. Тот факт, что британские комики Мэтт Лукас и Дэвид Уильямс изначально стремились создать максимально неполиткорректное шоу, в котором бы высмеивались все возможные стереотипы и пороки общества (причем в первую очередь под удар попали коренные англичане), руководством стриминговых сервисов был благополучно проигнорирован. Впал в немилость даже документальный (!) сериал Полицейские, выходивший с 1989 года: телеканал Paramount Network объявил о закрытии шоу всего за 5 дней до премьеры 33-го сезона. Официальной причиной для этого послужило унижающее человеческое достоинство изображение афроамериканцев.

Если в нулевых над скетчами Лукаса и

Уильямса смеялся весь мир, то сегодня их шоу считается аморальным

Если в нулевых над скетчами Лукаса и

Уильямса смеялся весь мир, то сегодня их шоу считается аморальным

Не остался в стороне и Дисней, хотя медиагиганту и понадобилось для раскачки больше времени. В соответствии с новой политикой инклюзивности компания ввела ограничения на доступ к ряду классических полнометражных мультфильмов в стриминговом сервисе Disney+, которые долгие годы оставались визитной карточкой компании. Такие анимационные ленты, как Питер Пен, Думбо, Книга джунглей, Коты-аристократы, и ряд других произведений перестали отображаться в детских профилях, а их описания были дополнены предупреждениями о содержащихся в мультфильмах расовых и культурных стереотипах, существовавших во время создания произведений.

Целесообразность подобного поступка вызывает вопросы. Если вы еще не прочли манифест Диснея, то попробуйте навскидку вспомнить, что такого криминального было в перечисленных мультфильмах. Вряд ли, будучи ребенком, вы задумывались о том, что вороны из Думбо являются прообразом уличных комиков, высмеивающих африканцев в характерном гриме (так называемый блэкфейс), а имя их главаря и вовсе отсылка к Законам Джима Кроу времен расовой сегрегации в США. Это весьма тонкий момент, на который могут обратить внимание лишь взрослые, хорошо знающие историю.

Да и для того, чтобы отыскать расистский подтекст в песенке Короля Луи, блестяще исполненной джазовым музыкантом Луи Прима, надо очень постараться. Во всяком случае, на формирование мировоззрения ребенка это произведение уж точно никак не повлияет (ну разве что привьет вкус к хорошей музыке).

Впрочем, повышение возрастного рейтинга весьма мягкая мера, ведь Дисней уже не раз демонстрировал, на что способен в борьбе за нравственные устои общества. Достаточно вспомнить хотя бы релиз фильма Всплеск, в котором все сцены с обнаженной Дэрил Ханна, даже самые невинные, на которых и так не разглядеть каких-либо подробностей, были любовно зацензурены с помощью компьютерной графики (к слову, довольно низкого качества).

А еще раньше Диснея уличили в удалении целого эпизода из культового мультсериала Симпсоны, один из персонажей которого, Леон Камповски, считал себя Майклом Джексоном и разговаривал его голосом, однако совершенно не умел петь. Так что в случае с классическими мультфильмами все еще обошлось малой кровью.

Поиск глубинных причин подобных действий со стороны правообладателей не является целью сегодняшнего материала, тем более что все и так достаточно очевидно. С одной стороны, громкие заявления и демонстративные поступки способствуют расширению рынка сбыта за счет повышения лояльности потенциальных клиентов, придерживающихся определенных политических и социальных взглядов. В то же время отказ от спорного контента позволяет компаниям избегать судебных исков от представителей тех или иных сообществ, о чем, в частности, напрямую заявляла Sony.

Напомним, что еще в апреле 2019 года компания объявила об ужесточении контроля за контентом эротического характера в играх, выходящих на платформе PlayStation. В интервью The Wall Street Journal официальные представители Sony четко обозначили причины данного поступка:

Мы обеспокоены тем, что можем стать целью судебного преследования, социальных акций, а также понести репутационные потери, которые негативно отразятся на деятельности компании в будущем.

В своем стремлении угодить вокальному меньшинству Sony пустилась во все тяжкие, начав с цензуры обложек для дисковых изданий и дойдя в конечном счете до вырезания пикантных моментов даже из игр с рейтингом 18+.

Слева версия обложки для семейной консоли

Nintendo Switch, справа для взрослой PlayStation 4

Слева версия обложки для семейной консоли

Nintendo Switch, справа для взрослой PlayStation 4

Новый регламент ударил по небольшим студиям. Все дело в том, что на первых порах у Sony вообще не было строгих критериев или письменного свода правил: ужесточение требований в отношении взрослого контента в играх вступило в силу неожиданно для всех, вскоре после череды скандалов, связанных с движением MeToo (судя по всему, именно они и послужили основной причиной столь скоропалительного пересмотра внутренней политики). И если крупные издатели вроде Capcom могли позволить себе выпускать специальные версии игр для консолей PlayStation, то у инди-разработчиков начались серьезные проблемы.

В Devil May Cry 5 мотоцикл Данте обзавелся

мощными ксеноновыми фарами, призванными скрыть прелести Триш

В Devil May Cry 5 мотоцикл Данте обзавелся

мощными ксеноновыми фарами, призванными скрыть прелести Триш

Трудности заключаются в том, что мы понятия не имеем, что нам скажут, до того как завершим работу над игрой и отправим ее на рассмотрение. Даже если еще несколько дней назад такой контент считался допустимым, это не значит, что завтра игру не отправят на доработку. Внесение корректив в готовый проект обходится очень дорого, к тому же мы терпим убытки из-за переноса релиза.

Здесь обозначена вторая по важности (после самого факта корпоративной цензуры) проблема постоянно меняющиеся правила игры. Те же Унесенные ветром снимались во времена действия Кодекса Американской ассоциации кинокомпаний, более известного как Кодекс Хейса (назван по имени Уильяма Харрисона Хейса, возглавлявшего ассоциацию в период с 1922 по 1945 год). Данный свод правил включал в себя 11 пунктов, соблюдение которых было обязательным, и еще 25 носящих рекомендательный характер. Хотя в этом перечне было немало странных (даже по тогдашним меркам) требований, если кинокартина им соответствовала, ее выпускали в прокат без каких-либо ограничений.

Уильям Харрисон Хейс главный борец за

нравственность в Голливуде начала XX века

Уильям Харрисон Хейс главный борец за

нравственность в Голливуде начала XX века

Сегодня ситуация в корне отличается. Мы с вами точно не знаем, что может произойти в следующий момент, какие тренды станут актуальными, какие политические или культурные веяния зародятся завтра. Для независимых создателей контента, будь то игровые инди-студии, небольшие музыкальные коллективы или авторы независимого кино, это может оказаться фатальным: проект, на реализацию которого ушли годы, способен в одночасье превратиться в токсичный актив, с которым не захочет иметь дело ни один издатель, звукозаписывающий лейбл или стриминговый сервис. В таких условиях смогут выживать лишь максимально беззубые творения, стремящиеся угодить всем и, как правило, не имеющие ничего общего с понятием искусство.

Для нас же с вами как потребителей контента последствия будут также весьма печальными: в эпоху цифровой дистрибуции правообладатель способен отменить или искалечить любое неправильное произведение, вырезав неудобные моменты, и никто ничего не сможет с этим поделать. Увы, главным девизом современного бизнеса стала любимая фраза Беликова Как бы чего не вышло. В рамках превентивного damage-control правообладатели предпочитают заблаговременно избавляться от всего, что потенциально может принести репутационные и/или финансовые потери, а когда речь заходит о миллионах и даже миллиардах долларов, интересы конечного потребителя уже мало кого волнуют.

Мой магазин мои правила: ноу-хау от Ubisoft

Впрочем, помимо исчезновения тех или иных произведений из сервисов цифровой дистрибуции в силу истечения сроков действия прав на их распространение или в угоду современным трендам, существует и еще одна серьезная проблема, для обозначения которой лучше всего подойдет такой эпитет, как произвол издателя.

Ранее мы уже обращались к теме копирайта в цифровую эпоху применительно к онлайн-магазинам компьютерных игр, однако прошлая публикация была встречена читателями неоднозначно: кто-то решил, что мы критикуем конкретно Steam (хотя на самом деле мы критиковали сложившуюся модель дистрибуции в целом, при которой издатель может сделать с приобретенной вами игрой все, что посчитает нужным, в том числе изменить до неузнаваемости и даже отобрать), а кто-то не воспринял высказанные опасения всерьез. Но Ubisoft расставила все точки над i, убедительно доказав, что мы были правы, хотя компания и превзошла все наши самые смелые ожидания.

Еще 12 мая 2020 года издатель изменил текст пользовательского соглашения, в котором появился весьма интересный пункт 8.2, касающийся условий прекращения действия учетной записи, необходимой для использования сервисов Ubisoft. Согласно ему, компания может закрыть ваш аккаунт в том случае, если он был неактивен более 6 месяцев. Разумеется, ни о какой компенсации денежных средств, потраченных на игры, речи не идет, о чем прямо сказано в пункте 8.3.

Обновленное EULA вызвало жаркие споры, причем у французского издателя нашлось и немало защитников, утверждавших, что речь идет о профилях, заблокированных после взлома или выявления факта использования читов, и что, вообще, все эти соглашения пишутся так, чтобы в случае чего прикрыть издателя в юридическом поле, а на самом деле никто ничего удалять, конечно же, не будет.

Однако все оказалось куда прозаичнее: пункт 8.2 не имеет скрытых трактовок, и понимать все, что в нем изложено, следует буквально, в чем ряд пользователей уже смогли убедиться самолично, получив спустя полгода вот такие замечательные письма счастья.

С точки зрения бизнеса обосновать данный шаг легко. Лояльной аудитории Ubisoft, которая покупает и играет в игры издателя на постоянной основе, бояться нечего: они и так будут регулярно авторизовываться в сервисе и никогда не получат подобный email. В то же время это неплохой способ стимулировать к покупке тех, кто заходит в Uplay лишь время от времени (например, чтобы поиграть в Реймана или перепройти старых Принцев Персии), делать это чаще: возможно, в очередной раз запустив лаунчер, такой пользователь польстится на скидку и прикупит что-нибудь новенькое, а там, глядишь, распробует новых Ассасинов и станет приобретать по игре каждый год (а может быть, и во внутриигровой магазин занесет немного наличности).

Прозорливые читатели могут возразить: никакое соглашение, будь то публичная оферта или подписанный собственноручно бумажный договор, не могут противоречить действующему законодательству, а значит, EULA Ubisoft не имеет силы в подавляющем большинстве стран, так как идет вразрез с законом о защите прав потребителей. И это действительно так, но, чтобы вернуть заблокированный аккаунт или получить компенсацию, вам придется подать иск против весьма крупного и богатого издателя.

А теперь ответьте для себя на следующие вопросы. Попав в подобную ситуацию, вы пойдете в суд? Решив судиться, сможете ли вы найти единомышленников для подачи коллективного иска? Есть ли у вас на примете кто-либо из влиятельных персон (представитель законодательной власти или известная медийная личность), кто был бы заинтересован в подобном процессе (например, ради пиара или из идейных соображений) и взялся бы участвовать в таком разбирательстве, оказывая посильную помощь?

Современные реалии таковы, что, будь вы хоть сто раз правы, выиграть у корпорации с огромной армией профессиональных юристов процесс в одиночку, не обладая достаточными финансовыми возможностями, без поддержки сильных мира сего, вы никак не сможете. И далеко не факт, что, когда лично у вас отберут аккаунт с играми, фильмами, книгами или другим цифровым контентом, обстоятельства сложатся в вашу пользу. Не говоря уже о том, что такое противостояние может затянуться на много лет, в течение которых вы все еще не сможете пользоваться своей учетной записью и привязанным к ней контентом.

Если снять розовые очки, то в современных реалиях вы должны четко осознавать, что прибегая к услугам площадок вроде UPlay вы не покупаете цифровой контент, а берете его в аренду на условиях, навязанных издателем, и можете в любой момент лишиться всей вашей коллекции без возможности восстановления или возврата средств. Это объективное положение вещей. Все, что вам нужно, решить лично для себя, как вы относитесь к потребляемому продукту в целом. Если вы не имеете привычки возвращаться к ранее пройденным играм, просмотренным фильмам или прочитанным книгам и четко осознаете, что деньги, которые вы отдаете платформам цифровой дистрибуции, это плата за сервис, а не за игру, фильм или музыкальный альбом как сущность, то по гамбургскому счету вам не о чем волноваться.

В противном же случае вы должны понимать, что ваша коллекция игр, музыки, фильмов, книг это не более чем таблица в базе данных, которая вам не принадлежит и однажды может быть стерта или отредактирована по воле правообладателя. Единственный, кто способен гарантировать вам доступ к контенту, вы сами. Как же это сделать?

Спасение утопающих

Для начала стоит вспомнить о возможности приобретения контента на физических носителях. Хотя сегодня на золото уходит отнюдь не каждый фильм, музыкальный альбом или игра, это не значит, что их вообще перестали выпускать: оптические диски, винил и даже картриджи для консолей прошлых лет все еще можно отыскать на полках магазинов или на том же Ebay, если речь идет о каких-то раритетных изданиях.

Старый добрый винил в наше время

становится как никогда актуален

Старый добрый винил в наше время

становится как никогда актуален

Помимо этого, вы можете использовать сервисы, которые позволяют приобрести цифровую копию того или иного произведения и пользоваться ею без онлайн-активации или привязки к аккаунту. Пусть подобных площадок не так много, но они существуют и зачастую способны по-настоящему удивить. Взять, к примеру, тот же Bandcamp: здесь представлены сотни уникальных в своей самобытности коллективов, которых не найти на Deezer и Spotify, к тому же, в отличие от популярных стриминговых сервисов, здесь вы можете скачать любые приобретенные композиции и альбомы в lossless-качестве.

Наконец, не стоит забывать о проектах вроде Public Domain Torrents, Legit Torrents и аналогичных. Названия этих площадок говорят сами за себя: здесь энтузиасты выкладывают фильмы, музыку, игры, имущественные авторские права на которые истекли или вообще никогда не существовали, то есть произведения, находящиеся в статусе общественного достояния. Копирование и распространение таких материалов является полностью легальным, так что, пользуясь услугами подобных площадок, вы не нарушаете действующее законодательство.

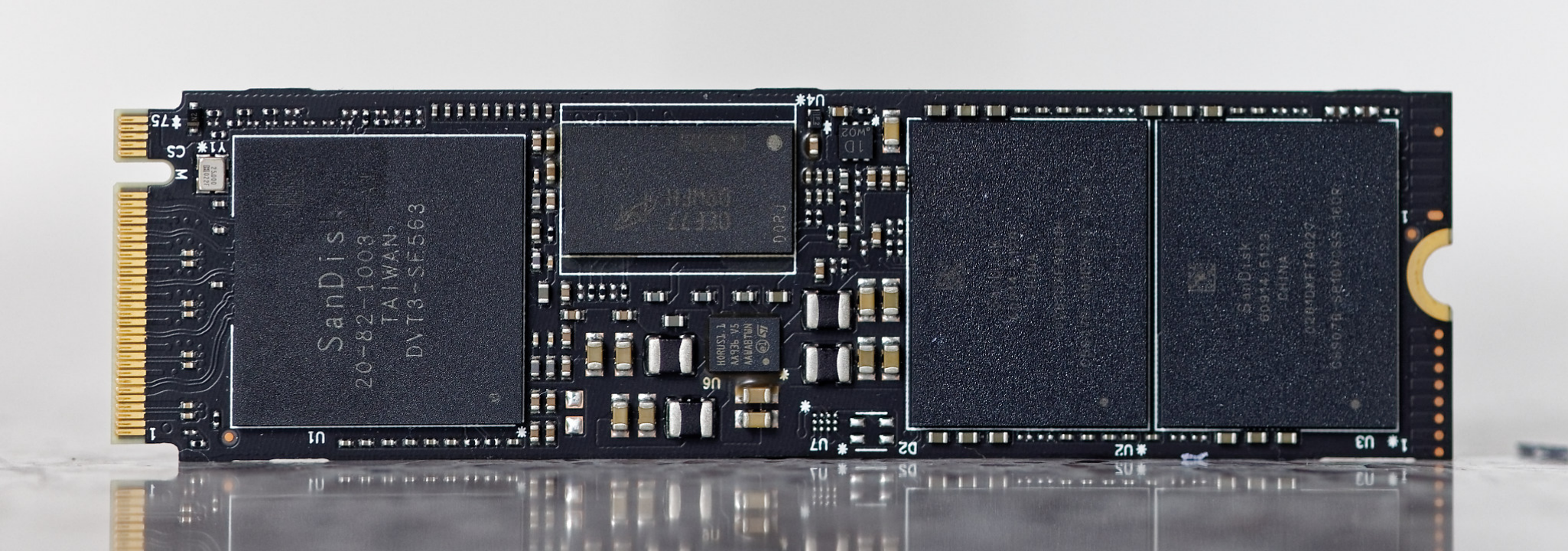

Сохранить же резервные копии полученного тем или иным способом цифрового контента вам поможет надежное сетевое хранилище и накопители Western Digital. На Хабре уже неоднократно выходили публикации, посвященные самостоятельной сборке NAS, так что вы сможете без труда отыскать не один десяток готовых рецептов. Что же касается накопителей для реализации подобного проекта, то лучшим выбором были и остаются жесткие диски WD Red Plus.

Данная линейка включает в себя девять моделей емкостью от 2 до 14 терабайт, предназначенных для эксплуатации в составе сетевых устройств хранения данных и вобравших в себя последние технологические достижения Western Digital. Ниже мы во всех подробностях рассмотрим каждую из используемых технологий, чтобы вы, уважаемые читатели, смогли по достоинству оценить предлагаемые нами решения.

-

Высокая надежность

Одна из особенностей жестких дисков WD Red Plus заключается в том, что парковка блока головок дисков осуществляется только при обесточивании NAS, поскольку параметр APM (Advanced Power Management) по умолчанию имеет значение 0. Параметр spindown (standby) timer также принимает нулевое значение: полная остановка мотора происходит лишь при отключении питания. Это позволяет, во-первых, сократить время отклика накопителя, а во-вторых, дополнительно продлить срок службы электродвигателя. И это при том, что привод блока головок может похвастаться ресурсом в 600 тысяч циклов парковки, что вдвое больше, чем у обычных винчестеров.

-

Платформа HelioSeal четвертого поколения

Жесткие диски WD Red Plus и WD Red Pro емкостью 8 терабайт и более созданы на базе платформы HelioSeal версии 4.0. Их корпуса абсолютно герметичны и заполнены инертным газом гелием, плотность которого практически в семь раз меньше плотности воздуха. Низкое сопротивление газовой среды дало возможность использовать более тонкие магнитные пластины, что позволило увеличить их количество, а снижение силы трения способствовало сокращению энергозатрат на раскрутку шпинделя. В свою очередь, уменьшение турбулентности помогло повысить точность позиционирования магнитных головок, благодаря чему удалось уменьшить зазор между ними и поверхностью блинов, а также сократить площадь треков, расположив их более компактно.

Как следствие, гелиевые накопители оказываются не только вместительнее, но и практически на 50% экономичнее и на 45C холоднее воздушных аналогов, что делает такие устройства идеальным решением для эксплуатации в составе сетевых хранилищ, работающих в режиме 24/7, а также ультракомпактных устройств серии My Cloud, потенциал системы охлаждения которых ограничен вследствие малых размеров корпуса.

-

Защита от вибрации

При вращении на каждую магнитную пластину действуют дисбалансирующие силы, причем одновременно в двух плоскостях: горизонтальной (блины смещаются в плоскости сечения оси шпинделя) и вертикальной (вектор приложен перпендикулярно, блок пластин как бы колеблется вверх-вниз). Чтобы нивелировать перечисленные эффекты, в заводских условиях проводится тщательная балансировка каждого устройства, в ходе которой подбирается оптимальная длина фиксирующих винтов. Помимо этого, мы используем систему демпферов и амортизаторов, которые эффективно гасят возникающую вибрацию. Данный комплекс мер получил название 3D Active Balance Plus.

Дополнительную надежность механизму придает технология StableTrac, предусматривающая двухстороннюю фиксацию вала электропривода.

Все это позволяет стабилизировать магнитные пластины, что также оказывает положительное влияние на точность позиционирования пишущих головок во время операций ввода/вывода.

-

Прошивка NASware 3.0

Фирменная микропрограмма Western Digital гарантирует совместимость накопителей с широким спектром материнских плат и дисковых контроллеров, что полностью исключает возникновение конфликтов между комплектующими на аппаратном уровне. Поддержка набора команд ATA Streaming Feature Set обеспечивает возможность параллельного выполнения операций чтения/записи за счет оптимизации использование кэш-памяти диска, благодаря чему вы сможете использовать NAS в качестве мультимедийного сервера, транслируя потоковое видео одновременно на несколько устройств и не опасаясь падения производительности системы хранения.

В свою очередь, поддержка технологии TLER (Time Limited Error Recovery) помогает дополнительно обезопасить вашу цифровую коллекцию за счет наличия обратной связи между накопителем и RAID-контроллером. Все дело в том, что даже при штатной работе жесткого диска неизбежно возникают ошибки считывания, обусловленные нестабильностью сектора или сбоем во время записи. В подобных случаях HDD действует согласно следующему алгоритму:

-

происходит повторная попытка записи в тот же сектор с последующим контрольным чтением;

-

если уровень сигнала по-прежнему остается низким, контроллер расценивает это как однозначный признак износа магнитного покрытия;

-

данные переносятся в другой сектор, а дефектный соответствующим образом помечается в дальнейшем при перезаписи он будет игнорироваться.

Схема отлично работает, когда речь идет об одиночных винчестерах, однако, если накопители объединены в массив, в дело вступает RAID-контроллер, который должен отслеживать состояние каждого устройства. Проблема в том, что во время коррекции ошибок диск не реагирует на отправляемые команды, и, если период латентности превышает 7 секунд (по умолчанию), диск исключается из массива, так как контроллер воспринимает такое молчание как признак отказа оборудования.

TLER решает данную проблему следующим образом. При выявлении ошибки инициируется стандартный алгоритм коррекции, однако, если уложиться в положенное время не удается, диск отправляет сигнал RAID-контроллеру. Последний фиксирует сообщение в журнале, откладывая процедуру исправления до более удачного момента (например, до простоя системы), что позволяет не только полностью исключить вероятность произвольного распада массива, но и дополнительно снизить нагрузку на систему хранения.

Все перечисленное делает жесткие диски семейства WD Red Plus практически идеальным решением для построения высокоемкого производительного NAS, который поможет сохранить ваши любимые фильмы, музыку, компьютерные игры, записи любимых шоу и другой цифровой контент и оградить вашу коллекцию от вероломных действий со стороны правообладателей.

Сопоставление размеров пищущей и считывающей головок жесткого

диска и ребра 10-центовой монеты

Сопоставление размеров пищущей и считывающей головок жесткого

диска и ребра 10-центовой монеты

Вскрытый IBM Microdrive в сравнении с монетой достоинством 50

евроцентов

Вскрытый IBM Microdrive в сравнении с монетой достоинством 50

евроцентов Старые ноутбуки были куда прочнее. На фото Siemens Nixdorf

PCD-5ND

Старые ноутбуки были куда прочнее. На фото Siemens Nixdorf

PCD-5ND В старых моделях жестких дисков система парковки блока головок

в принципе отсутствовала

В старых моделях жестких дисков система парковки блока головок

в принципе отсутствовала Если присмотреться, то можно заметить кромку Samsung

ShockSkinBumper

Если присмотреться, то можно заметить кромку Samsung

ShockSkinBumper Нет шариков нет проблем

Нет шариков нет проблем Жесткий диск с улучшенной ударостойкостью Fireball EL от

компании Quantum на 2,5 гигабайта

Жесткий диск с улучшенной ударостойкостью Fireball EL от

компании Quantum на 2,5 гигабайта Жесткий диск Maxtor DiamondMax Plus 21

Жесткий диск Maxtor DiamondMax Plus 21