Затраты на хранение данных зачастую становятся основным пунктом расходов при создании системы видеонаблюдения. Впрочем, они были бы несравнимо больше, если бы в мире не существовало алгоритмов, способных сжимать видеосигнал. О том, насколько эффективны современные кодеки, и какие принципы лежат в основе их работы, мы и поговорим в сегодняшнем материале.

Для большей наглядности начнем с цифр. Пускай видеозапись будет вестись непрерывно, в разрешении Full HD (сейчас это уже необходимый минимум, во всяком случае, если вы хотите полноценно использовать функции видеоаналитики) и в режиме реального времени (то есть, с фреймрейтом 25 кадров в секунду). Предположим также, что выбранное нами оборудование поддерживает аппаратное кодирование H.265. В этом случае при разных настройках качества изображения (высоком, среднем и низком) мы получим примерно следующие результаты.

|

Кодек |

Интенсивность движения в кадре |

Использование дискового пространства за сутки, ГБ |

|

H.265 (Высокое качество) |

Высокая |

138 |

|

H.265 (Высокое качество) |

Средняя |

67 |

|

H.265 (Высокое качество) |

Низкая |

41 |

|

H.265 (Среднее качество) |

Высокая |

86 |

|

H.265 (Среднее качество) |

Средняя |

42 |

|

H.265 (Среднее качество) |

Низкая |

26 |

|

H.265 (Низкое качество) |

Высокая |

81 |

|

H.265 (Низкое качество) |

Средняя |

39 |

|

H.265 (Низкое качество) |

Низкая |

24 |

Но если бы сжатия видео не существовало в принципе, мы бы увидели совсем иные цифры. Попробуем разобраться, почему. Видеопоток представляет собой не что иное, как последовательность статичных картинок (кадров) в определенном разрешении. Технически каждый кадр является двумерным массивом, содержащим информацию об элементарных единицах (пикселях), формирующих изображение. В системе TrueColor для кодирования каждого пикселя требуется 3 байта. Таким образом, в приведенном примере мы бы получили битрейт:

19201080253/1048576 = ~148 Мб/с

Учитывая, что в сутках 86400 секунд, цифры выходят поистине астрономические:

14886400/1024=12487 ГБ

Итак, если бы мы записывали видео без сжатия в максимальном качестве при заданных условиях, то для хранения данных, полученных с одной единственной видеокамеры в течение суток нам бы потребовалось 12 терабайт дискового пространства. Но даже система безопасности квартиры или малого офиса предполагает наличие, как минимум, двух устройств видеофиксации, тогда как сам архив необходимо сохранять в течение нескольких недель или даже месяцев, если того требует законодательство. То есть, для обслуживания любого объекта, даже весьма скромных размеров, потребовался бы целый дата-центр!

К счастью, современные алгоритмы сжатия видео помогают существенно экономить дисковое пространство: так, использование кодека H.265 позволяет сократить объем видео в 90 (!) раз. Добиться столь впечатляющих результатов удалось благодаря целому стеку разнообразных технологий, которые давно и успешно применяются не только в сфере видеонаблюдения, но и в гражданском секторе: в системах аналогового и цифрового телевидения, в любительской и профессиональной съемке, и многих других ситуациях.

Наиболее простой и наглядный пример цветовая субдискретизация. Так называют способ кодирования видео, при котором намеренно снижается цветовое разрешение кадров и частота выборки цветоразностных сигналов становится меньше частоты выборки яркостного сигнала. Такой метод сжатия видеоданных полностью оправдан как с позиции физиологии человека, так и с точки зрения практического применения в области видеофиксации. Наши глаза хорошо замечают разницу в яркости, однако гораздо менее чувствительны к перепадам цвета, именно поэтому выборкой цветоразностных сигналов можно пожертвовать, ведь большинство людей этого попросту не заметит. В то же время, сложно представить, как в розыск объявляют машину цвета паука, замышляющего преступление: в ориентировке будет написано темно-серый, и это правильно, ведь иначе прочитавший описание авто даже не поймет, о каком оттенке идет речь.

А вот со снижением детализации все оказывается уже совсем не так однозначно. Технически квантование (то есть, разбиение диапазона сигнала на некоторое число уровней с последующим их приведением к заданным значениям) работает великолепно: используя данный метод, размер видео можно многократно уменьшить. Но так мы можем упустить важные детали (например, номер проезжающего вдалеке автомобиля или черты лица злоумышленника): они окажутся смазаны и такая запись будет для нас бесполезной. Как же поступить в этой ситуации? Ответ прост, как и все гениальное: стоит взять за точку отсчета динамические объекты, как все тут же становится на свои места. Этот принцип успешно используется со времен появления кодека H.264 и отлично себя зарекомендовал, открыв ряд дополнительных возможностей для сжатия данных.

Это было предсказуемо: разбираемся, как H.264 сжимает видео

Вернемся к таблице, с которой мы начали. Как видите, помимо таких параметров, как разрешение, фреймрейт и качество картинки решающим фактором, определяющим конечный размер видео, оказывается уровень динамичности снимаемой сцены. Это объясняется особенностями работы современных видеокодеков вообще, и H.264 в частности: используемый в нем механизм предсказания кадров позволяет дополнительно сжимать видео, при этом практически не жертвуя качеством картинки. Давайте посмотрим, как это работает.

Кодек H.264 использует несколько типов кадров:

- I-кадры (от английского Intra-coded frames, их также принято называть опорными или ключевыми) содержат информацию о статичных объектах, не меняющихся на протяжении длительного времени.

- P-кадры (Predicted frames, предсказанные кадры, также именуемые разностными) несут в себе данные об участках сцены, претерпевших изменения по сравнению с предыдущим кадром, а также ссылки на соответствующие I-кадры.

- B-кадры (Bi-predicted frames, или двунаправленные предсказанные кадры) в отличие от P-кадров, могут ссылаться на I-, P- и даже другие B-кадры, причем как на предыдущие, так и на последующие.

Что это означает? В кодеке H.264 построение видеоизображения идет следующим образом: камера делает опорный кадр (I-кадр) и уже на его основе (поэтому он и называется опорным) производит вычитание из кадра неподвижных частей изображения. Таким образом создается P-кадр. Затем из этого второго кадра вычитается третий и также создается P-кадр с изменениями. Так формируется серия разностных кадров, которые содержат только изменения между двумя последовательными кадрами. В результате мы получаем такую цепочку:

[НАЧАЛО СЪЕМКИ] I-P-P-P-P-P-P-P-P-P-P-P-P-P- ...

Поскольку в процессе вычитания возможны ошибки, приводящие к появлению графических артефактов, то через какое-то количество кадров схема повторяется: вновь формируется опорный кадр, а вслед за ним серия кадров с изменениями.

-P-P-P-P-P-P-P-I-P-P-P-P-P-P-P ...

Полное изображение формируется путем наложения P-кадров на опорный кадр. При этом появляется возможность независимой обработки фона и движущиеся объектов, что позволяет дополнительно сэкономить дисковое пространство без риска упустить важные детали (черты лиц, автомобильные номера и т. д.). В случае же с объектами, совершающими однообразные движения (например, вращающимися колесами машин) можно многократно использовать одни и те же разностные кадры.

Независимая обработка статических и динамических объектов позволяет сэкономить дисковое пространство

Данный механизм носит название межкадрового сжатия. Предсказанные кадры формируются на основе анализа широкой выборки зафиксированных состояний сцены: алгоритм предвидит, куда будет двигаться тот или иной объект в поле зрения камеры, что позволяет существенно снизить объем записываемых данных при наблюдении за, например, проезжей частью.

Кодек формирует кадры, предсказывая, куда будет двигаться объект

В свою очередь, использование двунаправленных предсказанных кадров позволяет в несколько раз сократить время доступа к каждому кадру в потоке, поскольку для его получения будет достаточно распаковать только три кадра: B, содержащий ссылки, а также I и P, на которые он ссылается. В данном случае цепочку кадров можно изобразить следующим образом.

[НАЧАЛО СЪЕМКИ] I-B-P-B-P-B-P-B-P-B-P-B-P-B-P-B-P-

Такой подход позволяет существенно повысить скорость быстрой перемотки с показом и упростить работу с видеоархивом.

В чем разница между H.264 и H.265?

В H.265 используются все те же принципы сжатия, что и в H.264: фоновое изображение сохраняется единожды, а затем фиксируются лишь изменения, источником которых являются движущиеся объекты, что позволяет значительно снизить требования не только к объему хранилища, но и к пропускной способности сети. Однако в H.265 многие алгоритмы и методы прогнозирования движения претерпели значительные качественные изменения.

Так, обновленная версия кодека стала использовать макроблоки дерева кодирования (Coding Tree Unit, CTU) переменного размера с разрешением до 6464 пикселей, тогда как ранее максимальный размер такого блока составлял лишь 1616 пикселей. Это позволило существенно повысить точность выделения динамических блоков, а также эффективность обработки кадров в разрешении 4K и выше.

Кроме того, H.265 обзавелся улучшенным deblocking filter фильтром, отвечающим за сглаживание границ блоков, необходимым для устранения артефактов по линии их стыковки. Наконец, улучшенный алгоритм прогнозирования вектора движения (Motion Vector Predictor, MVP) помог заметно снизить объем видео за счет радикального повышения точности предсказаний при кодировании движущихся объектов, чего удалось достичь за счет увеличения количества отслеживаемых направлений: если ранее учитывалось лишь 8 векторов, то теперь 36.

Помимо всего перечисленного выше, в H.265 была улучшена поддержка многопоточных вычислений: квадратные области, на которые разбивается каждый кадр при кодировании, теперь могут обрабатываться независимо одна от другой. Появилась и поддержка волновой параллельной обработки данных (Wavefront Parallelel Processing, WPP), что также способствует повышению производительности сжатия. При активации режима WPP обработка CTU осуществляется построчно, слева направо, однако кодирование каждой последующей строки может начаться еще до завершения предыдущей в том случае, если данных, полученных из ранее обработанных CTU, для этого достаточно. Кодирование различных строк CTU с временной задержкой со сдвигом, наряду с поддержкой расширенного набора инструкций AVX/AVX2 позволяет дополнительно повысить скорость обработки видеопотока в многоядерных и многопроцессорных системах.

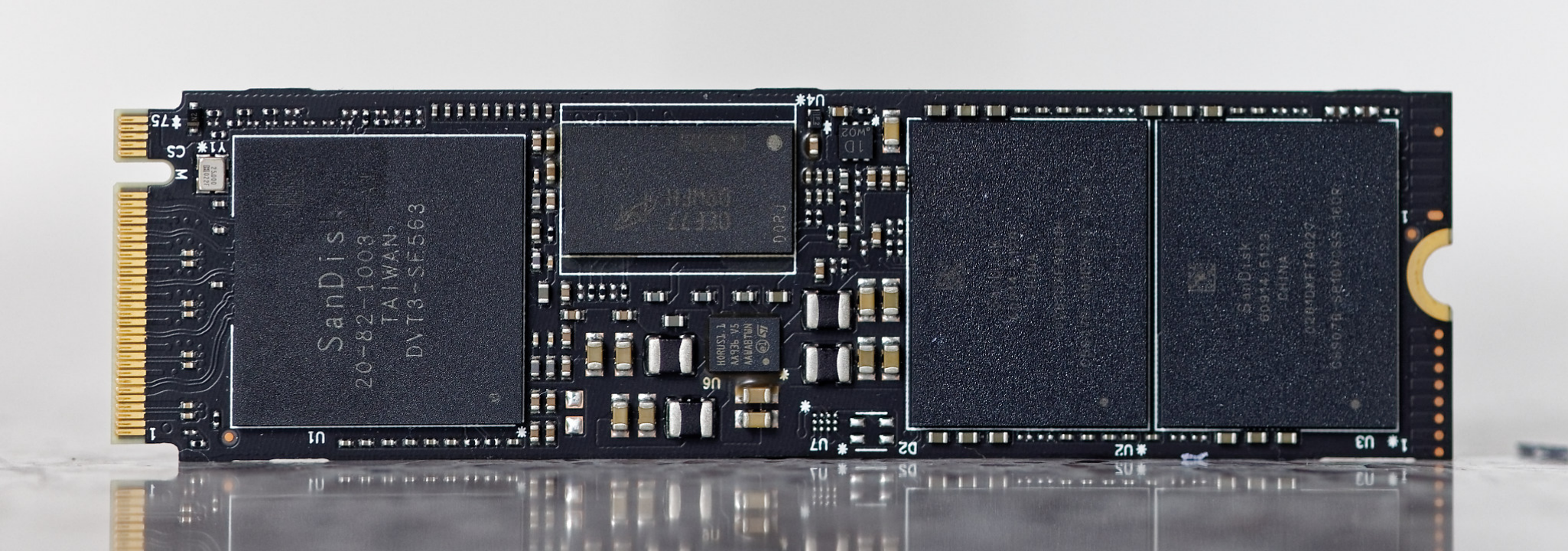

Флэш-карты для видеонаблюдения: когда значение имеет не только размер

И вновь вернемся к табличке, с которой мы начали сегодняшний разговор. Давайте подсчитаем, сколько дискового пространства нам понадобится в том случае, если мы хотим хранить видеоархив за последние 30 дней при максимальном качестве видеозаписи:

13830/1024 = 4

По нынешним меркам 4 терабайта для винчестера индустриального класса практически ничто: современные жесткие диски для видеонаблюдения имеют емкость до 14 терабайт и могут похвастаться рабочим ресурсом до 360 ТБ в год при MTBF до 1.5 миллионов часов. Что же касается карт памяти, то здесь все оказывается не так однозначно.

В IP-камерах флэш-карты играют роль резервных хранилищ: данные на них постоянно перезаписываются, чтобы в случае потери связи с видеосервером недостающий фрагмент видеозаписи можно было восстановить из локальной копии. Такой подход позволяет существенно повысить отказоустойчивость всей системы безопасности, однако при этом сами карты памяти испытывают колоссальные нагрузки.

Как видно из нашей таблицы, даже при низком качестве изображения и при условии минимальной активности в кадре, всего за сутки будет записано около 24 ГБ видео. А это значит, что 128-гигабайтная карточка будет полностью перезаписана менее чем за неделю. Если же нам требуется получать максимально качественную картинку, то все данные на таком носителе будут полностью обновляться раз в сутки! И это лишь при разрешении Full HD. А если нам понадобится картинка в 4K? В этом случае нагрузка вырастет практически в два раза (в заданных условиях видео в максимальном качестве потребует уже 250 ГБ).

При бытовом использовании подобное попросту невозможно, поэтому даже самая бюджетная карта памяти способна прослужить вам несколько лет к ряду без единого сбоя. А все благодаря алгоритмам выравнивания износа (wear leveling). Схематично их работу можно описать следующим образом. Пусть в нашем распоряжении есть новенькая флеш-карта, только что из магазина. Мы записали на нее несколько видеороликов, использовав 7 из 16 гигабайт. Через некоторое время мы удалили часть ненужных видео, освободив 3 гигабайта, и записали новые, объем которых составил 2 ГБ. Казалось бы, можно задействовать только что освободившееся место, однако механизм выравнивания износа выделит под новые данные ту часть памяти, которая ранее никогда не использовалась. Хотя современные контроллеры тасуют биты и байты куда более изощренно, общий принцип остается неизменным.

Напомним, что кодирование битов информации происходит путем изменения заряда в ячейках памяти за счет квантового туннелирования электронов сквозь слой диэлектрика, что вызывает постепенный износ диэлектрических слоев с последующей утечкой заряда. И чем чаще меняется заряд в конкретной ячейке, тем раньше она выйдет из строя. Выравнивание износа как раз направлено на то, чтобы каждая из доступных ячеек перезаписывалась примерно одинаковое количество раз и, таким образом, способствует увеличению срока службы карты памяти.

Нетрудно догадаться, что wear leveling перестает играть хоть сколько-нибудь значимую роль в том случае, если флэш-карта постоянно перезаписывается целиком: здесь на первый план уже выходит выносливость самих чипов. Наиболее объективным критерием оценки последней является максимальное количество циклов программирования/стирания (program/erase cycle), или, сокращенно, циклов P/E, которое способно выдержать флеш-память. Также достаточно точным и в данном случае наглядным (так как мы можем заранее рассчитать объемы перезаписи) показателем является коэффициент TBW (Terabytes Written). Если в технических характеристиках указан лишь один из перечисленных показателей, то вычислить другой не составит особого труда. Достаточно воспользоваться следующей формулой:

TBW = (Емкость Количество циклов P/E)/1000

Так, например, TBW флеш-карты емкостью 128 гигабайт, ресурс которой составляет 200 P/E, будет равен: (128 200)/1000 = 25,6 TBW.

Давайте считать дальше. Выносливость карт памяти потребительского уровня составляет 100300 P/E, и 300 это в самом лучшем случае. Опираясь на эти цифры, мы можем с достаточно высокой точностью оценить срок их службы. Воспользуемся формулой и заполним новую таблицу для карты памяти емкостью 128 ГБ. Возьмем за ориентир максимальное качество картинки в Full HD, то есть в сутки камера будет записывать 138 ГБ видео, как мы выяснили ранее.

|

Ресурс карты памяти, циклов P/E |

TBW |

Время наработки на отказ |

|

100 |

12,8 |

3 месяца |

|

200 |

25,6 |

6 месяцев |

|

300 |

38,4 |

1 год |

Хотите использовать карты на 64 ГБ или писать видео в 4K? Смело делите рассчитанные сроки на два: в среднем потребительские карты памяти придется менять раз в полгода, причем в каждой камере. То есть каждые 6 месяцев вам придется закупать новую партию флеш-карт, нести дополнительные расходы на сервисное обслуживание и, конечно же, подвергать опасности охраняемый объект, так как камеры придется выводить из эксплуатации на время замены.

Наконец, еще один момент, на который следует обратить пристальное внимание при выборе карты памяти, ее скоростные характеристики. В описании практически всех современных флеш-карт можно встретить запись вида: Производительность: до 100 МБ/с при чтении, до 90 МБ/с при записи; запись видео: C10, U1, V10. Здесь C10 и U1 означают не что иное, как класс скорости записи видео, причем если заглянуть в справочные материалы, то классам C10, U1 и V10 соответствует 10 МБ/с. Откуда разница в 9 раз и почему маркировка тройная? На самом деле все достаточно просто.

В рассмотренном примере 100 и 90 МБ/с это номинальная скорость, то есть максимально достижимая производительность карты в операциях последовательного чтения и записи при условии использования с совместимым оборудованием, которое само по себе обладает достаточной производительностью. А показатели C10, U1 и V1 (10 МБ/с) это минимальная устойчивая скорость передачи данных в наихудших условиях тестирования. Данный параметр необходимо учитывать при выборе карт для камер видеонаблюдения по той простой причине, что если он окажется ниже битрейта видеопотока, то это чревато появлением на записи графических артефактов и даже выпадением целых кадров. Очевидно, что в случае с охранными системами подобное недопустимо: любые дефекты картинки чреваты потерей критически важных данных например, улик, которые могли бы помочь при поимке злоумышленника.

Что же касается наличия сразу трех маркировок, то причины этого сугубо исторические. C10 относится к самой первой из созданных SD Card Association классификаций, которая была составлена еще в 2006 году, получив простое и незамысловатое название Speed Class. Появление классификации UHS Speed Class, на которую указывает маркировка U1, связано с созданием интерфейса Ultra High Speed, который сегодня используется в подавляющем большинстве флеш-карт. Наконец, последняя классификация, Video Speed Class (V1), была разработана SD Card Association в 2016-м в связи с распространением устройств, поддерживающих запись видео сверхвысоких разрешений (4K, 8K и 3D).

Поскольку перечисленные классификации частично пересекаются, мы подготовили для вас сравнительную таблицу, в которой скоростные характеристики флеш-карт сопоставлены между собой и соотнесены с видео различного разрешения.

|

Speed Class |

UHS Speed Class |

Video Speed Class |

Минимальная устойчивая скорость записи |

Разрешение видео |

|

C2 |

2 МБ/с |

Запись видео стандартного разрешения (SD, 720 на 576 пикселей) |

||

|

C4 |

4 МБ/с |

Запись видео высокой четкости (HD), включая Full HD (от 720p до 1080p/1080i) |

||

|

C6 |

V6 |

6 МБ/с |

||

|

C10 |

U1 |

V10 |

10 МБ/с |

Запись видео Full HD (1080p) с фреймрейтом 60кадров в секунду |

|

U3 |

V30 |

30 МБ/с |

Запись видео с разрешением до 4K и фреймрейтом 60/120 кадров в секунду |

|

|

V60 |

60 МБ/с |

Запись видеофайлов с разрешением 8K и фреймрейтом 60/120 кадров в секунду |

||

|

V90 |

90 МБ/с |

Следует учитывать, что приведенные в таблице соответствия актуальны для любительских, полупрофессиональных и профессиональных видеокамер. В отрасли видеонаблюдения, где запись в реальном времени ведется с максимальной частотой 25 кадров в секунду, а для сжатия видеопотока применяются высокоэффективные кодеки H.264 и H.265, задействующие кодирование с предсказанием, в подавляющем большинстве случаев будет достаточно карт памяти, соответствующих классу U1/V10, так как битрейт в таких условиях практически никогда не превышает порог в 10 МБ/с.

Карты памяти WD Purple microSD для систем видеонаблюдения

С учетом всех перечисленных особенностей компания Western Digital разработала специализированную серию карт памяти WD Purple microSD, которая на данный момент включает в себя две продуктовые линейки: WD Purple QD102 и WD Purple SC QD312 Extreme Endurance. В первую вошли четыре накопителя объемом от 32 до 512 ГБ, во вторую три модели, на 64, 128 и 256 ГБ. По сравнению с потребительскими решениями, WD Purple были специально адаптированы под современные цифровые системы видеонаблюдения за счет внедрения ряда важных усовершенствований.

Главным преимуществом пурпурной серии является существенно больший по сравнению с бытовыми устройствами рабочий ресурс: карты линейки QD102 способны выдержать 1000 циклов программирования/стирания, тогда как QD312 уже 3000 циклов P/E, что позволяет многократно продлить срок их службы даже в режиме круглосуточной записи, и делает данные карточки идеально подходящими для эксплуатации на особо охраняемых объектах, где запись ведется в режиме 24/7. В свою очередь, соответствие классам скорости UHS Speed Class 1 и Video Speed Class 10 позволяет использовать карты WD Purple в камерах высокого разрешения, в том числе для записи в режиме реального времени.

Помимо этого, карты памяти WD Purple имеют и ряд других важных особенностей, о которых необходимо упомянуть:

- влагостойкость (изделие способно выдержать погружение на глубину до 1 метра в пресную или соленую воду) и расширенный диапазон рабочих температур (от -25C до +85C) позволяют одинаково эффективно использовать карты WD Purple для оснащения как внутридомовых, так и уличных устройств видеофиксации независимо от погодных и климатических условий;

- защита от воздействия статических магнитных полей с индукцией до 5000 Гс и устойчивость к сильной вибрации и ударам вплоть до 500 g полностью исключают вероятность утраты критически важных данных даже в случае повреждения видеокамеры;

- функция удаленного мониторинга помогает оперативно отслеживать состояние каждой карты и эффективнее планировать проведение сервисных работ, а значит, дополнительно повысить надежность охранной инфраструктуры.

Для большей наглядности мы подготовили для вас сравнительную таблицу, в которой приведены основные характеристики карт памяти WD Purple.

|

Серия |

WD Purple QD102 |

WD Purple QD312 |

||||||

|

Объем, ГБ |

32 |

64 |

128 |

256 |

512 |

64 |

128 |

256 |

|

Форм- фактор |

microSDHC |

microSDXC |

||||||

|

Производи-тельность |

До 100 МБ/с в операциях последовательного чтения, до 65 МБ/с в операциях последовательной записи |

|||||||

|

Скоростной класс |

U1/V10 |

|||||||

|

Ресурс записи (P/E) |

1000 |

3000 |

||||||

|

Ресурс записи (TBW) |

32 |

64 |

128 |

256 |

512 |

192 |

384 |

768 |

|

Диапазон рабочих температур |

От -25 C до 85 C |

|||||||

|

Гарантия |

3 года |

|||||||

Профессор Иллинойского университета, писатель

Пол Хилд

Профессор Иллинойского университета, писатель

Пол Хилд

Вот как выглядит официальный ремейк MGS 3 от Konami

Вот как выглядит официальный ремейк MGS 3 от Konami

Вчерашняя классика может впасть в

немилость по воле трендов

Вчерашняя классика может впасть в

немилость по воле трендов

Если в нулевых над скетчами Лукаса и

Уильямса смеялся весь мир, то сегодня их шоу считается аморальным

Если в нулевых над скетчами Лукаса и

Уильямса смеялся весь мир, то сегодня их шоу считается аморальным

Слева версия обложки для семейной консоли

Nintendo Switch, справа для взрослой PlayStation 4

Слева версия обложки для семейной консоли

Nintendo Switch, справа для взрослой PlayStation 4

В Devil May Cry 5 мотоцикл Данте обзавелся

мощными ксеноновыми фарами, призванными скрыть прелести Триш

В Devil May Cry 5 мотоцикл Данте обзавелся

мощными ксеноновыми фарами, призванными скрыть прелести Триш

Уильям Харрисон Хейс главный борец за

нравственность в Голливуде начала XX века

Уильям Харрисон Хейс главный борец за

нравственность в Голливуде начала XX века

Старый добрый винил в наше время

становится как никогда актуален

Старый добрый винил в наше время

становится как никогда актуален

Внутриигровое меню обеспечивает доступ к

дополнительным функциям эмулятора

Внутриигровое меню обеспечивает доступ к

дополнительным функциям эмулятора

Сопоставление размеров пищущей и считывающей головок жесткого

диска и ребра 10-центовой монеты

Сопоставление размеров пищущей и считывающей головок жесткого

диска и ребра 10-центовой монеты

Вскрытый IBM Microdrive в сравнении с монетой достоинством 50

евроцентов

Вскрытый IBM Microdrive в сравнении с монетой достоинством 50

евроцентов Старые ноутбуки были куда прочнее. На фото Siemens Nixdorf

PCD-5ND

Старые ноутбуки были куда прочнее. На фото Siemens Nixdorf

PCD-5ND В старых моделях жестких дисков система парковки блока головок

в принципе отсутствовала

В старых моделях жестких дисков система парковки блока головок

в принципе отсутствовала Если присмотреться, то можно заметить кромку Samsung

ShockSkinBumper

Если присмотреться, то можно заметить кромку Samsung

ShockSkinBumper Нет шариков нет проблем

Нет шариков нет проблем Жесткий диск с улучшенной ударостойкостью Fireball EL от

компании Quantum на 2,5 гигабайта

Жесткий диск с улучшенной ударостойкостью Fireball EL от

компании Quantum на 2,5 гигабайта Жесткий диск Maxtor DiamondMax Plus 21

Жесткий диск Maxtor DiamondMax Plus 21