Всем привет! Данная статья 2 по счету в блоге от команды ОЛЛИ ИТ на Хабре. Я искренне рада данной возможности, и надеюсь, что материалы нашего блога будут для вас полезны.

Для тех, кто никогда об этом не слышал

Задача любой ИТ-инфраструктуры сводится к обеспечению надежной платформы для бизнес-процессов компании. Традиционно считается, что качество информационно-технологической инфраструктуры оценивается по трем основным параметрам: доступность, безопасность, надёжность.

Самым очевидным шагом в будущее сталообъединение разрозненныхточек хранения данных и их обработки. Иными словами, почему бы не реализовать распределенную СХД не на отдельных серверах, а прямо на хостахвиртуализации, отказавшись тем самым отсети хранения и выделенного железа, и совместив таким образом функции.Речь идет огиперконвергенции.

Гиперконвергенцияберет свое начало в концепции конвергентной инфраструктуры.

Технологии в конвергентной инфраструктуре могут быть разделены и использоваться независимо друг от друга. Но при этом, эти же самые технологии вгиперконвергентнойинфраструктуре настолько тесно интегрированы, что не могут быть разбиты на отдельные компоненты.

На сегодняшний день наиболее распространенными системамигиперконвергенцииявляютсяNutanix,CiscoHyperflex,Vmware vSAN,Dell VxRAIL (комплекс сервера + ПО Vmware vSAN),HuaweiFusionCube,StarWindVirtual SAN и другое.Все они среди прочего доступны в России.

Но мало кто знает оPivot3!

Компания Pivot3 была основана несколькими ветеранами IT индустрии из компаний Compaq, VMware и Adaptec, движимыми идеей упрощения ЦОДов благодаря объединению ресурсов хранения, обработки и передачи данных в едином, мощном, легко встраиваемом решении, которое бы сокращало расходы, операционные риски, и упрощало управление в целом.Pivot3создаетгиперконвергентныерешения для критически важных инфраструктур в безопасных и интеллектуальных средах, таких как: университетские городки, города, аэропорты,call-центры, компании с большим штатом разработчиков,транспортные и федеральные объектыи т.д.

РешенияPivot3, разработанные специально для рабочих нагрузок на основе видео, таких как:видеонаблюдение, аналитика, визуализация и VDI, снижают совокупную стоимость владения, снижают риски иответственность, упрощаютуправление за счет автоматизации.Pivot3-этоединственная инфраструктураHCI,созданнаядля быстрой и удобной работы с большими объемами видеоданных.Ключевая и важная инновация-управление производительностью на основе политик, всестороннее использованиеNVMeи эффективное хранение.

ГиперконвергентныерешенияPivot3

Архитектура и функциигиперконвергентнойинфраструктурыPivot3обеспечивают значительные преимущества для инфраструктуры виртуальных рабочих столов (VDI). HCIPivot3оптимизирует развертывание виртуальных рабочих столов за счет минимизации объема инфраструктуры и совокупной стоимости владения, обеспечения оптимального взаимодействия с пользователем и упрощения перехода от пилотного к полномасштабному развертыванию.

Угиперконвергентнойинфраструктуры есть множество преимуществ. В первую очередь это инновационная технология, которая в ближайшие годы станетмейнстримоми сильно подвинет классические подходы к построению ЦОД. HCI помогает причесать разрозненную ИТ-среду, избавиться от необходимости управления несколькими системами, что несёт как организационный порядок, так и финансовую эффективность. Кроме того, сокращаются капитальные и операционные расходы. При классической инфраструктуре необходим штат специалистов, каждый из которых является экспертом в своей области,тогда как управлением HCI и всеми ее компонентами может заниматься одна группа администраторов.

Ниже представленыпримерыпреимуществгиперконвергентнойинфраструктуры* (HCI).

Гиперконвергентнаяинфраструктура (HCI)*

-

Комбинация вычислительных ресурсов и ресурсов хранения;

-

Стандартная платформаx86;

-

Модульность;

-

На базегипервизораотVMware;

-

Большая гибкость;

-

Лучшая эффективность использования;

-

Подходит для VDI инфраструктуры;

-

Высокие показатели компрессии идедупликацииданных.

Почемустоит обратить внимание наPivot3?

-

Длязадачи, где обычно требуется 4узла,Pivot3необходимо всего3;

-

Производительность базы данныхзначительно увеличилась(БД Микс пакеты 8k, комбинация запись/чтение, 100% случайное, глубина очереди 128, средние IOPS и задержка);

-

Отклик приложений;

-

Большее количество транзакций(больше 10);

-

Большая плотность данных на один узел;

-

Pivot3можетобеспечитьболеевыгоднуюэкономическуюценность, по сравнению сдругимипроизводителями, например-Nutanix.

Pivot3: Направленность на производительность

Прорыв в производительности дляHCI:

HCIAcceleratorNodes

-

NVMePCIeflashинтегрирован в многоуровневую архитектуру хранения;

-

Постоянный уровень хранения,R&Wкэш;

-

Управление расширенным QoS для повышения эффективности иприоритезации.

Многоуровневое хранение

Объемы хранимых данных ежегодно увеличиваются на 5080%, что заставляет разработчиков искать альтернативы сложным СХД с ограниченноймасштабируемостью, создавать решения, более эффективно использующие ресурсы ЦОД и сокращающие время простоя, а кроме того, упрощать администрирование за счет автоматизации операций, ведь расходы на управление также быстро растут. Эта задача повышения эффективности хранения данных решается с помощью консолидации и многоуровневого хранения. Многоуровневое, иерархическое хранение информации - один из подходов, которые приходят на смену экстенсивному наращиванию емкости хранения данных.

Сравним показатели!

В качестве примерасравним общие данные эффективности оборудования на примереPivot3.

1) Многоуровневое хранение

Одноуровневая архитектуруHCI

-

Устаревшая архитектура SAS/SATA является ограничивающим фактором для производительности;

-

Сложности с консолидацией разных типов задач.

А теперь сравним ее смногоуровневойархитектуройPivot3:

-

NVMeобеспечивает оперативный отклик;

-

QoSавтоматически подбирает оптимальный уровень размещения данных для соответствияSLA;

-

Результат эффективная консолидация разных типов задач.

Помимо многоуровневой архитектуры,Pivot3обладаетболее эффективнойутилизациейресурсов:

Часть ресурсов берётся уVMs:

-

Более высокие накладные расходыHCIOS;

-

Доступ к хранилищу черезгипервизор.

Более эффективно, большеVMs:

-

Меньше накладных расходовHCI OS;

-

Обходгипервизораозначает повышенную производительность хранилища.

Распределённая производительность

Традиционная архитектураHCI

-

Объём хранения,IOPSи ширина канала ограничены;

-

ВозможностиVMограничены производительностью конкретного узла.

Распределённая архитектураPivot3

-

Объём хранения,IOPSи ширина канала агрегируются;

-

VMдоступны все имеющиеся ресурсы.

Pivot3 + Citrix

Помимо всего перечисленного важно отметить, чтоCitrixиPivot3 объявили об укреплении сотрудничества для поддержки Citrix Virtual Desktops на платформе интеллектуальнойгиперконвергентнойинфраструктуры (HCI)Pivot3, что довольно актуально на сегодняшний день в связи с переходом сотрудников на удаленную работу.

Сеть технологических партнёров, с которыми сотрудничаетPIVOT3

Продуктовые линейкиотPivot3

-

Оптимизация для работы вЦОДах;

-

Консолидация множественных задач с разнообразными требованиями к ресурсам;

-

Архитектура для полнофункционального использованияNVMe;

-

Автоматизированное управление на основе политик;

-

Широкий функционал по управлению данными корпоративного класса.

-

Оптимизация для видеонаблюдения;

-

Архитектура для сохранения целостности видеоконтента и предотвращения простоев системы и потерь данных;

-

Масштабирование вычислительной мощности, ресурсов хранения или канала линейно и/или независимо;

-

Доставка видеоконтента на любые устройства;

-

Сертификация у основных производителей ПО для управлениявидеоконтентом.

***

В заключениеможно сказать, что современные решения HCI от компанииPivot3сочетают в себе высокопроизводительныефлеш-каналыпередачи данных NVMe PCIe, механизмы обеспечения качества обслуживания на основе политик (QoS), распределенные ресурсы производительности и мобильность гибридных облачных систем для достижения максимальных рабочих показателей, гибкости имасштабируемости.

Хроники

расчистки площадки.

Хроники

расчистки площадки.

Так эта же площадка выглядела в июле и в

октябре 2020 года.

Так эта же площадка выглядела в июле и в

октябре 2020 года.

Нас уже заметили.

Нас уже заметили.

Так на схеме выглядит половина

дата-центра. Вторая половина такая же.

Так на схеме выглядит половина

дата-центра. Вторая половина такая же.

Приоткроем плитку фальшпола в холодном коридоре.

Приоткроем плитку фальшпола в холодном коридоре.

Ряд ИБП Vertiv (ex-Liebert) в энергоцентре.

Ряд ИБП Vertiv (ex-Liebert) в энергоцентре.

Стеллажи c батареями в помещении АКБ.

Стеллажи c батареями в помещении АКБ.

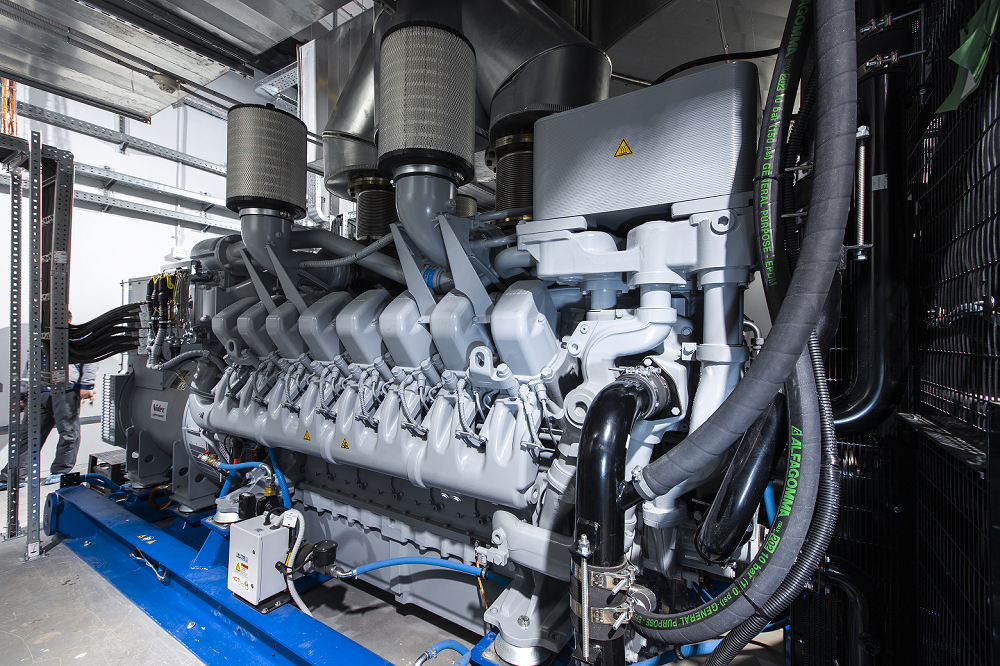

ДГУ марки MTU 16V4000 DS2250 мощностью 1965 кВт.

ДГУ марки MTU 16V4000 DS2250 мощностью 1965 кВт.

Один бак топливохранилища вмещает 12,6

куб. м, всего таких баков два.

Один бак топливохранилища вмещает 12,6

куб. м, всего таких баков два.

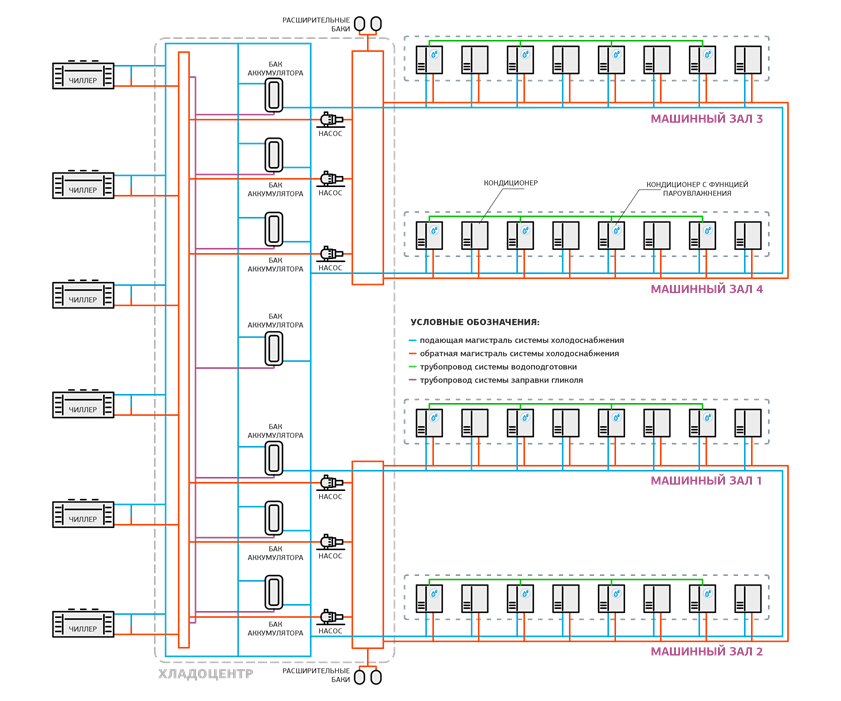

Общая схема системы холодоснабжения.

Общая схема системы холодоснабжения.

Бак оборудован манометром: если давление

выходит за рабочие пределы, срабатывает предохранительный клапан.

Бак оборудован манометром: если давление

выходит за рабочие пределы, срабатывает предохранительный клапан.

Циркуляционные насосы в одном из хладоцентров.

Циркуляционные насосы в одном из хладоцентров.

Отличить "горячий" и "холодный" контур

можно по цвету стрелок.

Отличить "горячий" и "холодный" контур

можно по цвету стрелок.

Таких секций на крыше две.

Таких секций на крыше две.

Аккумулирующие баки и трубы оклеены

теплоизоляционным материалом K-Flex и защищены от физического

воздействия металлическим кожухом.

Аккумулирующие баки и трубы оклеены

теплоизоляционным материалом K-Flex и защищены от физического

воздействия металлическим кожухом.

Такие же кнопки есть и около эвакуационных выходов.

Такие же кнопки есть и около эвакуационных выходов.

Одна из кроссовых.

Одна из кроссовых.

Суть всех вопросов: Почему средняя

мощность 5 кВт на стойку? Как так, 21-й век, 21-й год, а цифра не

меняется? Это слишком мало.

Суть всех вопросов: Почему средняя

мощность 5 кВт на стойку? Как так, 21-й век, 21-й год, а цифра не

меняется? Это слишком мало.

Так выглядит план на этом этапе: пока все

стойки одинаковые.

Так выглядит план на этом этапе: пока все

стойки одинаковые.

График среднего потребления всех стоек

DataLine за год.

График среднего потребления всех стоек

DataLine за год.

Стандартная схема энергоснабжения

дата-центров DataLine.

Стандартная схема энергоснабжения

дата-центров DataLine.

Помещение ДИБП. Не рекомендую появляться

здесь без средств защиты слуха.

Помещение ДИБП. Не рекомендую появляться

здесь без средств защиты слуха.

Cхема электроснабжения мегаЦОДа Удомля.

Cхема электроснабжения мегаЦОДа Удомля.

Сенсорная панель на щите управления ДИБП.

Сенсорная панель на щите управления ДИБП.

Панель управления остановленного ДИБП.

Панель управления остановленного ДИБП.

ДИБП работает в режиме генератора.

ДИБП работает в режиме генератора. Смотрим на работу ДИБП под нагрузкой.

Смотрим на работу ДИБП под нагрузкой. Все параметры отображаются на дисплее.

Все параметры отображаются на дисплее.