Твердотельные накопители продолжают набирать популярность, но

традиционные жесткие диски не стоит списывать со счетов. Они

по-прежнему лучше подходят для долгосрочного хранения

данных, обеспечивая более выгодную цену в расчете

на гигабайт. Поэтому во многих ПК и ноутбуках вместе с

системным SSD можно встретить и жесткий диск. Сетевые хранилища и

системы видеонаблюдения тоже остаются традиционной сферой

использования HDD. А внешние накопители на HDD отличаются хорошим

балансом цены и емкости.

На рынке можно приобрести жесткие диски разных производителей,

но, по понятным причинам, в рамках данного руководства мы

ограничимся продукцией компании Seagate. Кроме того, накопители

Seagate отличаются высокой надежностью и приличным сроком

гарантии.

Но какую модель выбрать для ПК или NAS? Как получить

максимальную ёмкость и производительность за свои деньги? Об этом

мы и поговорим в нашей статье, приняв во внимание все последние

изменения на рынке.

Мы указывали цены на момент публикации, полученные в открытых

источниках. Цены меняются каждый день, поэтому для удобства мы

привели ссылки на Яндекс.Маркет, которые помогут найти актуальные

цены в вашем регионе. Мы принимали во внимание розничные цены новых

накопителей, без учета старых или бывших в употреблении моделей.

Кроме того, во многих магазинах постоянно действуют различные

акции, которые не мешает проверять. В любом случае, вы не

разочаруетесь, если купите любой из рекомендованных нами

накопителей.

Ключевые характеристики жестких дисков

Перед тем, как мы рассмотрим лучшие жесткие диски за свои

деньги, позвольте вкратце напомнить ключевые характеристики

накопителей. Мы не будем рассматривать их подробно, но понимания

критериев при выборе HDD небольшой ликбез необходим.

Форм-фактор

Сегодня на рынке доминируют жесткие диски в 3,5"

формате, которые чаще всего используются в компьютерах,

NAS, системах видеонаблюдения, внешних боксах. Причина кроется в

оптимальном сочетании емкости, производительности и занимаемого

пространства. Поэтому большая часть нашего руководства будет

посвящена как раз 3,5" формату.

В ноутбуках и внешних боксах применяются 2,5" жесткие

диски из-за меньших размеров. Емкость при этом тоже

придется принести в жертву она ограничена 5 Тбайт. Модели 2,5"

малой емкости сегодня вытесняются SSD, но жесткие диски емкостью в

несколько терабайт остаются интересными для некоторых сценариев,

например, для хранения игровой библиотеки на ноутбуке или

резервного копирования на переносном жестком диске.

Отдельная категория внешние накопители. Они

представляют собой те же 2,5" или 3,5" HDD, заключенные в корпус. В

случае 2,5" HDD есть преимущество дополнительное питание чаще всего

не требуется. Кроме того, внешние накопители часто предлагают

бонусы, такие как USB-концентратор или дополнительный софт

резервирования.

Емкость

Основной параметр жесткого диска, выражается в терабайтах.

Следует помнить, что производители жестких дисков считают емкость в

десятичной системе, а не в двоичной (MiB,

GiB, TiB), поэтому на практике ёмкость после

форматирования будет меньше. Как правило, жесткие диски

значительной емкости обеспечивают более выгодную стоимость

гигабайта. Поэтому иногда выгоднее немного доплатить, но

существенно выиграть по емкости.

Скорость вращения шпинделя

Раньше данный параметр был один из основных, поскольку влиял на

производительность жесткого диска (пропускную способность и

задержки). Но поскольку в качестве системных накопителей все чаще

устанавливают SSD, а HDD используют для хранения данных, то

скорость вращения шпинделя уже не так важна. Распространены два

варианта: 7.200 об/мин и 5.400 об/мин. При прочих

равных большая скорость вращения дает более высокий уровень

производительности. Но при этом возможны жертвы по

энергопотреблению и уровню шума, поэтому слепо гнаться за высокой

скоростью вращения не стоит. Она должна быть достаточной, чтобы

жесткий диск давал приемлемый уровень производительности.

Тип записи и другие технологии

Жесткие диски высокой емкости (обычно 10 Тбайт и выше) перешли

на гелиевое наполнение вместо обычного воздуха,

что привело к улучшениям по уровню шума и энергопотреблению. В

нашем обзоре гелиевые HDD представлены линейкой

Exos. Пластины при этом получается располагать

ближе друг к другу, что позволяет добиться рекордных уровней

емкости в каждом поколении. Из-за себестоимости гелиевые жесткие

диски начинаются только с определенного уровня емкости. А младшие

линейки HDD используют воздух.

Из современных технологий магнитной записи следует упомянуть

перпендикулярную (PMR), на которой работают

большинство жестких дисков. Для дальнейшего увеличения емкости без

чрезмерного удорожания была разработана технология

черепичной записи (SMR). С одной стороны, она

позволяет в прежний бюджет уместить большую емкость. С другой

стороны, придется жертвовать снижением скорости записи. Для многих

сценариев SMR остается вполне разумным выбором. Например,

большинство представленных в статье 2,5" накопителей опираются на

SMR. Подробнее об этой технологии можно прочитать в нашей статье

SMR: понятно в теории, сложно на практике.

В этом году на рынок должны выйти жесткие диски с передовыми

технологиями записи HAMR и MAMR,

которые позволяют перейти на новые уровни емкости. Здесь мы

рекомендуем прочитать статью От витражей к терабайтам:

разгадываем тайны HAMR. Как только жесткие диски появятся

на рынке, мы добавим их в обзор.

Выбираем лучший 3,5" HDD

Жесткие диски 3,5" формата остаются наиболее

популярными на рынке из-за оптимального сочетания размеров, емкости

и скорости. Seagate разделяет свои 3,5" жесткие диски на несколько

линеек: Barracuda (Pro) для настольных ПК,

IronWolf (Pro) для NAS, SkyHawk

(AI) для видеонаблюдения, Exos для

серверов. Разница кроется в различных рабочих характеристиках,

прошивке, сертификации и т.д. В принципе, нет ничего страшного в

том, чтобы использовать тот же серверный жесткий диск Exos в

домашнем ПК, но придется смириться, например, с более высоким

уровнем шума.

Мы рассмотрим только накопители с интерфейсом SATA.

Потребительская линейка Seagate Barracuda остается весьма выгодной

до своей максимальной емкости 8 Тбайт. Но затем пальму первенства

перехватывает семейство Exos, как мы покажем ниже.

2.500 и 1 Тбайт - Seagate Desktop HDD ST1000DM003

Мы начнем с минимальной емкости 1 Тбайт,

которую можно приобрести за 2.500 . Меньшие

варианты емкости брать смысла не имеет, поскольку преимущества по

цене нет. Жесткий диск Seagate Desktop HDD

ST1000DM003 сравнительно старый, поколения 2014 года

(7200.14), но со своей работой он справляется. Скорость вращения

шпинделя 7.200 об/мин, заявленная скорость передачи до 210 Мбайт/с,

рабочее энергопотребление 5,9 Вт. Гарантия 2 года. См.

подробные спецификации.

Емкость 1 Тбайт по современным меркам небольшая, поэтому данный

жесткий диск имеет смысл брать только покупателям с ограниченным

бюджетом. Самые дешевые SSD на 1 Тбайт стоят в три раза дороже.

Купить Seagate Desktop HDD ST1000DM003 за 2.500

3.800 и 2 Тбайт Seagate Barracuda ST2000DM008

Следующий ценовой уровень наглядно показывает, что за удвоение

емкости придется заплатить отнюдь не удвоенную цену. Уровень

2 Тбайт многими пользователями считается

оптимальным, поскольку и цена хорошая, и емкость неплохая. 1 Тбайт

здесь обойдется в 1.900 .

Жесткий диск Seagate Barracuda ST2000DM008

относится к современному поколению со скоростью вращения шпинделя

7.200 об/мин, скорость передачи данных до 220 Мбайт/с, рабочее

энергопотребление 4,3 Вт. Жесткий диск опирается на всего одну

пластину, поэтому и результаты энергопотребления приятно радуют.

Гарантия 2 года. См.

подробные спецификации.

Жесткий диск уже фигурировал в нашем обзоре Seagate

ST2000DM008: быстрая двушка без оверпрайса, где получил

весьма высокую оценку.

Купить Seagate Barracuda ST2000DM008 за 3.800

5.600 и 3 Тбайт Seagate Barracuda ST3000DM008

Следующий ценовой уровень позволяет нарастить емкость еще на 1

Тбайт, доплатив разумную сумму (1.867 /Тбайт).

ST3000DM008 относится к той же современной

линейке, что 2-Тбайт модель ST2000DM008. Скорость вращения шпинделя

7.200 об/мин, скорость передачи данных до 210 Мбайт/с, рабочее

энергопотребление 8 Вт. По энергопотреблению видно, что число

пластин увеличилось до трех. Гарантия 2 года. См.

подробные спецификации.

Купить Seagate Barracuda ST3000DM008 за 5.600

7.400 и 4 Тбайт Seagate Barracuda ST4000DM004

Емкость 4 Тбайт тоже масштабируется практически

линейно по цене (1.850 /Тбайт). Семейство

накопителей не изменилось, но 4-Тбайт ST4000DM004

опирается на две пластины, а также меньшую скорость вращения

шпинделя 5.400 об/мин. Поэтому энергопотребление чуть ниже 3-Тбайт

версии 3,7 Вт. Скорость передача данных заявлена до 190 Мбайт/с.

Как мы отмечали выше, жесткие диски уже редко используются в

качестве системных. Но если такая необходимость возникнет лучше

брать модель на 7.200 об/мин. В данном случае мы получаем

классический HDD для хранения данных. Гарантия 2 года. См.

подробные спецификации.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Backup Plus Portable

Drive с 2,5" накопителем на 4 Тбайт или

Seagate Basic с 2,5" HDD на 5 Тбайт

(см. ниже).

Купить Seagate Barracuda ST4000DM004 за 7.400

11.800 и 6 Тбайт - Seagate Barracuda ST6000DM003

Жесткие диски емкостью 5 Тбайт стоят не дешевле 6-Тбайт

вариантов, поэтому брать их смысла нет. Следующая ценовая ступенька

6-Тбайт ST6000DM003. Здесь работают три пластины

на 5.400 об/мин, энергопотребление заявлено 5,3 Вт, скорость

последовательной передачи данных до 190 Мбайт/с. Жесткий диск можно

рекомендовать тем пользователям, кому емкости 4 Тбайт будет

недостаточно. Масштабирование цены в расчете на терабайт здесь

немного ухудшается по сравнению с HDD младшей емкости 1.967

/Тбайт. Но 6 Тбайт остается довольно популярным вариантом

для хранения данных. Гарантия 2 года. См.

подробные спецификации.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Backup Plus Hub 6

TB (см. ниже).

Купить Seagate Barracuda ST6000DM003 за 11.800

13.700 и 8 Тбайт Seagate Barracuda ST8000DM004

Переход на 8 Тбайт оказался более привлекателен

по цене, поскольку здесь мы получаем 1.712 /Тбайт.

Поэтому данную модель ST8000DM004 брать выгоднее,

чем многие другие. Жесткий диск относится все к той же современной

линейке Barracuda. Несмотря на четыре пластины, энергопотребление

не увеличилось 5,3 Вт. Скорость последовательной передачи данных

прежняя до 190 Мбайт/с, как и скорость вращения шпинделя 5.400

об/мин. Гарантия 2 года. См.

подробные спецификации.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Expansion Desktop Drive 8

TB (см. ниже).

Купить Seagate Barracuda ST8000DM004 за 13.700

19.100 и 12 Тбайт - Seagate Exos X16 ST12000NM001G

Следующее выгодное предложение жесткий диск на 12

Тбайт ST12000NM001G из линейки

Exos X16 с гелиевым наполнением. Емкость 10 Тбайт

пришлось пропустить, поскольку выгодных цен мы не нашли. В случае

12-Тбайт HDD цена терабайта весьма привлекательная

1.592 . Здесь проявляется феномен емкости: чем она

выше, тем вкуснее цена гигабайта. Данный накопитель лидирует в

нашем руководстве по минимальной цене в расчете на емкость (если не

учитывать внешние HDD).

Линейка ST12000NM001G относится к корпоративному классу, поэтому

гарантия составляет пять лет, есть и сертификат на

режим работы 24/7. Скорость вращения шпинделя 7.200 об/мин,

пропускная способность передачи данных до 245 Мбайт/с, максимальная

потребляемая мощность 9,5 Вт. См.

подробные спецификации.

Жесткие диски Exos X16 отлично подойдут для NAS. При

использовании в домашней системе следует учитывать высокий уровень

шума.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Backup Plus Hub 12

TB (см. ниже). Но при этом теряются плюшки

Exos.

Купить Seagate Exos X16 ST12000NM001G за 19.100

24.600 и 14 Тбайт - Seagate Exos X16 ST14000NM001G

Серверные накопители Exos X16 продолжают

лидировать по соотношению цена/емкость, обеспечивая при этом

отличную производительность. Прирост емкости

ST14000NM001G на 2 Тбайт оказался менее

эффективным: 1.753 /Тбайт. В остальном мы получаем

ту же гелиевую линейку со всеми преимуществами корпоративного

класса, главные из которых гарантия 5 лет и

сертификация на работу 24/7. Скорость вращения шпинделя составляет

7.200 об/мин, пропускная способность передачи данных до 261

Мбайт/с, максимальная потребляемая мощность 10 Вт. См.

подробные спецификации.

Жесткие диски Exos X16 отлично подойдут для NAS. При

использовании в домашней системе следует учитывать высокий уровень

шума.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Expansion Desktop Drive 14

TB (см. ниже). Но при этом теряются плюшки

Exos.

Купить Seagate Exos X16 ST14000NM001G за 24.600

29.700 и 16 Тбайт - Seagate Exos X16 ST16000NM001G

Серверная линейка Exos X16 продолжает

оставаться выгодной и в старшем варианте емкости

ST16000NM001G - 1.860 /Тбайт. К

преимуществам гелиевого накопителя отнесем срок гарантии 5

лет и сертификат на работу в режиме 24/7. Скорость

вращения шпинделя составляет 7.200 об/мин, пропускная способность

передачи данных до 261 Мбайт/с, максимальная потребляемая мощность

10 Вт. См.

подробные спецификации.

Жесткие диски Exos X16 отлично подойдут для NAS. При

использовании в домашней системе следует учитывать высокий уровень

шума.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Expansion Desktop Drive 16

TB (см. ниже). Но при этом теряются плюшки

Exos.

Купить Seagate Exos X16 ST16000NM001G за 29.700

33.800 и 18 Тбайт - Seagate Exos X18 ST18000NM000J

Таким же выгодным приобретением оказывается вариант

ST18000NM000J в максимальной емкости 18

Тбайт, доступной на рынке. Здесь мы получаем всего

1.880 /Тбайт. Но линейка X18 более современная,

недавно мы как раз опубликовали тест Seagate Exos X18 жесткий

диск корпоративного класса на 18 Тбайт, где приведены

подробности. Конечно, не обошлось без солидной гарантии на

5 лет и сертификата на работу 24/7. Максимальная

скорость новой линейки была увеличена до 270 Мбайт/с. Максимальная

потребляемая мощность снижена до 9,4 Вт. См.

подробные спецификации.

Жесткие диски Exos X18 отлично подойдут для NAS. При

использовании в домашней системе следует учитывать высокий уровень

шума.

Купить Seagate Exos X18 ST18000NM000J за 33.800

Выбираем лучший 2,5" HDD

Еще лет десять назад основной сферой использования 2,5"

HDD были ноутбуки, но сегодня место системных мобильных

накопителей заняли SSD. Если в ноутбуке предусмотрен отсек под

второй накопитель в формате 2,5", то его как раз можно занять емким

жестким диском, так как SSD в расчете на гигабайт остаются

значительно дороже. Кроме того, 2,5" HDD можно использовать во

внешнем боксе как переноску. Следует обращать внимание на толщину

накопителя. Многие устройства рассчитаны на установку 2,5" HDD

толщиной 7 мм. Самые емкие модели имеют толщину

15 мм, поэтому они подойдут далеко не для всех

ноутбуков или боксов. Ниже мы рассмотрим 2,5" HDD только с

интерфейсом SATA.

2.900 и 1 Тбайт Seagate ST1000LM035

Мы вновь выставили минимальную планку 1 Тбайт,

поскольку брать меньшую емкость нерационально. Жесткий диск

ST1000LM035 использует одну пластину, скорость

вращения шпинделя составляет 5.400 об/мин, скорость

последовательной передачи до 140 Мбайт/с. Энергопотребление всего

до 1,6 Вт. Срок гарантии два года. Перед нами экономичный жесткий

диск, который хорошо подойдет и как дополнительный накопитель

ноутбука (толщина 7 мм), и для переносного бокса. Конечно, если

емкости 1 Тбайт будет достаточно. См.

подробные спецификации.

Купить Seagate ST1000LM035 за 2.900

4.200 и 2 Тбайт Seagate ST2000LM007

Следующая планка емкости 2 Тбайт оказывается

более выгодной, мы получаем уже 2.100 /Тбайт.

ST2000LM007 опирается на две пластины, поэтому

энергопотребление поднялось до 1,7 Вт. Скорость вращения шпинделя

5.400 об/мин, гарантия два года, скорость передачи данных до 140

Мбайт/с. Как и модель на 1 Тбайт, его можно рекомендовать для

ноутбуков (вторым HDD, толщина 7 мм) и переносных боксов. См.

подробные спецификации.

Купить Seagate ST2000LM007 за 4.200

7.700 и 4 Тбайт Seagate Barracuda ST4000LM024

Емкость 4 Тбайт ST4000LM024

оказалась еще более привлекательной 1.930 /Тбайт.

Причем линейка уже другая Barracuda, но скорость вращения шпинделя

не изменилась 5.400 об/мин. Среднее энергопотребление при

чтении/записи составляет до 2,1 Вт, скорость передачи данных до 140

Мбайт/с. Гарантия 2 года. Жесткий диск имеет толщину 15

мм, поэтому он подойдет далеко не для всех ноутбуков и

боксов. Проверяйте совместимость перед покупкой. См.

подробные спецификации.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Backup Plus Portable

Drive с данным накопителем (см. ниже).

Купить Seagate Barracuda ST4000LM024 за 7.700

12.000 и 5 Тбайт Seagate Barracuda ST5000LM000

Жесткий диск ST5000LM00 на 5

Тбайт уже выходит из окна оптимального соотношения емкости

и цены 2.400 /Тбайт. Зато он позволяет уместить в

компактном объеме целых пять терабайт! Но, как и в случае модели на

4 Тбайт, следует учитывать толщину 15 мм. Поэтому

проверяйте совместимость перед покупкой. Скорость вращения шпинделя

5.400 об/мин, среднее энергопотребление до 2,1 Вт, скорость

передачи данных до 140 Мбайт/с, гарантия два года. См.

подробные спецификации.

Внимание: возможно, более выгодным вариантом станет покупка

внешнего Seagate Basic с данным

накопителем (см. ниже).

Купить Seagate Barracuda ST5000LM000 за 12.000

Внешние накопители

Внешний накопитель можно легко сделать самому, достаточно купить

бокс для 2,5" или 3,5" жесткого диска с нужным

интерфейсом, после чего установить HDD самостоятельно. Сегодня

наиболее распространены боксы с подключением USB,

причем поддерживаются разные стандарты: USB 3.2 Gen1 (5 Гбит/с),

USB 3.2 Gen2 (10 Гбит/с) или USB 3.2 Gen2x2 (20 Гбит/с). Но учтите,

что на практике скорость будет упираться в производительность HDD,

поэтому даже USB 3.2 Gen1 более чем достаточно, поскольку 5 Гбит/с

это на практике около 500 Мбайт/с, а жесткий диск намного

медленнее.

Как правило, боксы для 2,5" жестких дисков не требуют

дополнительного питания, но для вариантов под 3,5" HDD оно

необходимо. Максимальная емкость 2,5" HDD составляет 5 Тбайт,

поэтому более емкие модели опираются на 3,5" HDD.

3.500 и 1 Тбайт - Seagate Backup Plus Slim Portable Drive

Внешний HDD Seagate Backup Plus Slim Portable

Drive с подключением USB 3.2 Gen1 и емкостью 1 Тбайт имеет

компактные габариты 114,8 x 78 x 11,7 мм и вес 126 г. Гарантия

составляет два года. Внутри, по неофициальной информации,

используется Seagate ST1000LM035, приведенный выше. Хороший вариант

для переносного накопителя, но при небольшой доплате выгоднее взять

емкость 2 Тбайт. См.

подробные спецификации.

Внимание: накопители Backup

Plus скоро исчезнут из розницы, их заменит

линейка

Seagate One Touch HDD. Так что с покупкой

по выгодной цене стоит поторопиться.

Купить Seagate Backup Plus Slim Portable Drive 1 TB за

3.500

4.800 и 2 Тбайт - Seagate Backup Plus Slim Portable Drive

В емкости 2 Тбайт самой выгодной покупкой оказывается та же

линейка Seagate Backup Plus Slim Portable Drive с

габаритами 114,8 x 78 x 11,7 мм, весом 126 г и подключением USB 3.2

Gen1. Гарантия два года, внутри (неофициально) используется Seagate

ST2000LM007, рассмотренный выше. Цена 1 Тбайт составляет

2.400 . См.

подробные спецификации.

Внимание: накопители Backup

Plus скоро исчезнут из розницы, их заменит

линейка

Seagate One Touch HDD. Так что с покупкой

по выгодной цене стоит поторопиться.

Купить Seagate Backup Plus Slim Portable Drive 2 TB за

4.800

7.000 и 4 Тбайт - Seagate Backup Plus Portable Drive

С емкостью 3 Тбайт выгодных вариантов нет, чего нельзя сказать о

4 Тбайт. Линейка Seagate Backup Plus

Portable Drive с подключением USB 3.2 Gen1 использует 2,5"

HDD Seagate с толщиной 15 мм. Причем покупать внешний накопитель

дешевле, чем 2,5" HDD отдельно. Цена 1 Тбайт всего

1.750 . Корпус довольно компактный 114,5 x 78 x

20,5 мм, вес 247 г. По неофициальной информации, внутри установлен

ST4000LM024. Гарантия составляет 2 года. См.

подробные спецификации.

Внимание: накопители Backup

Plus скоро исчезнут из розницы, их заменит

линейка

Seagate One Touch HDD. Так что с покупкой

по выгодной цене стоит поторопиться.

Купить Seagate Backup Plus Portable Drive 4 TB за

7.000

8.000 и 5 Тбайт Seagate Basic

Еще один очень любопытный накопитель в линейке Seagate

Basic на 5 Тбайт. Габариты 117 x 80 x 20 мм немного больше

Backup Plus Portable, как и вес 270 г, но не принципиально.

Подключение тоже осуществляется через USB 3.2 Gen1, гарантия всего

1 год. Цена в расчете на Тбайт приятно радует всего

1.600 . Внутри, по неофициальной информации,

установлен ST5000LM000. См.

подробные спецификации.

Купить Seagate Basic 5 TB за 8.000

10.000 и 6 Тбайт - Seagate Backup Plus Hub

С емкостью больше 5 Тбайт уже приходится переходить на внешние

боксы в формате 3,5". И здесь выгодным предложением является

Seagate Backup Plus Hub 6 TB STEL6000200 с ценой 1

Тбайт всего 1.667 . Подключение все то же USB 3.2

Gen1, габариты 41 x 198,1 x 118 мм, вес 1,06 кг, в качестве бонуса

встроен аккумулятор и два порта USB для зарядки или подключения

устройств (по сути, USB-концентратор). Внутри, по неофициальной

информации, используется HDD Barracuda ST6000DM003. Гарантия

составляет 2 года. Необходимо дополнительное питание.

См.

подробные спецификации.

Купить Seagate Backup Plus Hub 6 TB за 10.000

11.700 и 8 Тбайт - Seagate Expansion Desktop Drive

В емкости 8 Тбайт мы нашли более выгодную

линейку Seagate Expansion Desktop Drive, которая в

варианте STEB8000402 дает стоимость 1 Тбайт всего

1.470 . Габариты составляют 176 x 120,6 x 36,6 мм,

вес 950 г. Подключение USB 3.2 Gen1. По неофициальной информации

внутри установлен ST8000DM004. Гарантия составляет 2 года.

Необходимо дополнительное питание. См.

подробные спецификации.

Купить Seagate Expansion Desktop Drive 8 TB за

11.700

17.400 и 12 Тбайт - Seagate Backup Plus Hub

С емкостью 10 Тбайт мы не обнаружили выгодных предложений,

поэтому сразу же переходим к варианту на 12 Тбайт

- Seagate Backup Plus Hub STEL12000400. Цена

терабайта стала еще более привлекательной 1.450 .

Подключение все то же USB 3.2 Gen1, габариты 41 x 198,1 x 118 мм,

вес 1,06 кг, в качестве бонуса встроен аккумулятор и два порта USB

для зарядки или подключения устройств (по сути, USB-концентратор).

Гарантия составляет 2 года. Необходимо дополнительное питание. См.

подробные спецификации.

Купить Seagate Backup Plus Hub 12 TB за 17.400

19.200 и 14 Тбайт - Seagate Expansion Desktop Drive

С увеличение емкости еще на 2 Тбайт до 14 Тбайт

более выгодной вновь становится линейка Seagate Expansion

Desktop Drive, а именно накопитель

STEB14000400. Мы получаем цену 1 Тбайт всего

1.371 . Габариты составляют 176 x 120,6 x 36,6 мм,

вес 950 г. Гарантия составляет 2 года. Необходимо дополнительное

питание. См.

подробные спецификации.

Купить Seagate Expansion Desktop Drive за 19.200

25.500 и 16 Тбайт - Seagate Expansion Desktop Drive

Еще 2 Тбайт емкости дали максимальный вариант среди внешних HDD

- накопитель Seagate Expansion Desktop Drive

STEB16000400 на 16 Тбайт. Однако цена 1

Тбайт повысилась до 1.600 . Так что брать

накопитель на 16 Тбайт имеет смысл только в том случае, если

емкости 14 Тбайт будет недостаточно. Габариты составляют 176 x

120,6 x 36,6 мм, вес 950 г. Гарантия 2 года. Необходимо

дополнительное питание. См.

подробные спецификации.

Купить Seagate Expansion Desktop Drive за 25.500

Какой накопитель выбрать?

Мы проанализировали рынок на состояние марта 2021, после чего

привели рекомендации жестких дисков в разных ценовых категориях.

Выводы получились любопытными.

Среди обычных HDD 3,5" формата лидером до

емкости 8 Тбайт включительно была линейка

Barracuda. Младшие HDD работают со скоростью

вращения шпинделя 7.200 об/мин, но в емкости 4-8 Тбайт она

составляет уже 5.400 об/мин. Что вполне логично: младшие HDD могут

использоваться и как системные в самых бюджетных ПК, где не

получается докупить SSD. С емкости 4 Тбайт ценовой уровень уже

подразумевает, что у пользователя есть средства на системный SSD.

Поэтому HDD емкостью от 4 Тбайт будут работать не как системные, а

для хранения данных. И здесь высокие обороты шпинделя не так

важны.

В вариантах емкости 12-18 Тбайт самыми выгодными HDD неожиданно

оказались серверные Exos. Здесь главный бонус

гарантия 5 лет и сертифицированная нагрузка 24/7.

Диски хорошо подойдут для NAS, а также и для домашних ПК, но

уровень шума у них может быть сравнительно высоким. К бонусам можно

отнести гелиевое наполнение, которое приводит к

низкому энергопотреблению, несмотря на 7.200 об/мин.

В сегменте 2,5" жестких дисков мы привели

экономичные варианты на 1 и 2 Тбайт для ноутбуков, а также на 4 и 5

Тбайт для внешних боксов. Но у последних следует учитывать высоту

15 мм, ограничивающую совместимость.

Мы надеемся, что наше руководство поможет выбрать лучший жесткий

диск за свои деньги.

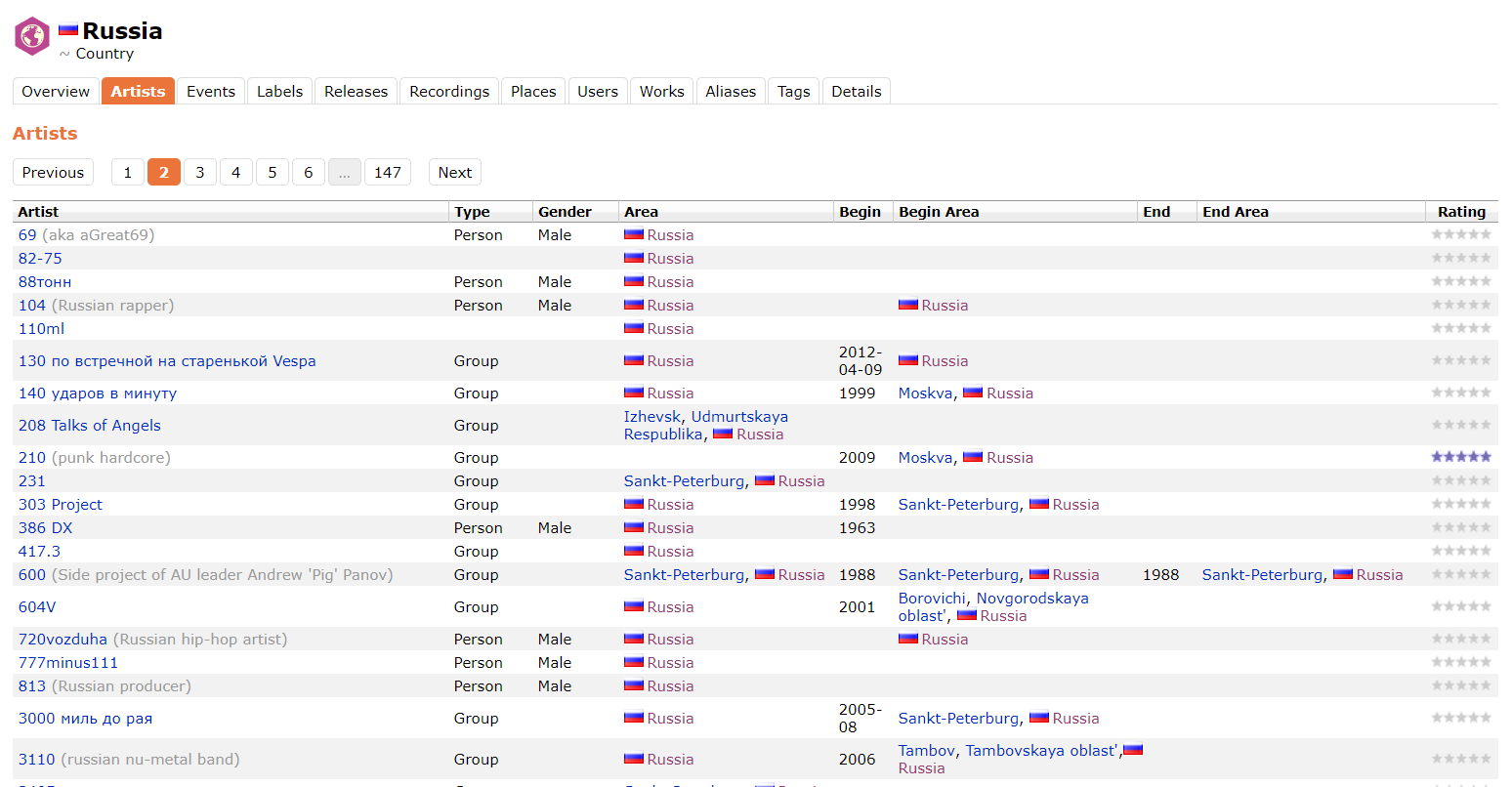

Рис. 1 SLA Report предоставляет

высокоуровневый обзор производительности SLA по спискам наборов.

Каждая строка содержит индикатор состояния последнего раздела

данных, а также гистограммы, отражающие данные о времени выгрузки

(красные столбцы показывают дни, когда время выгрузки не

соответствует SLA).

Рис. 1 SLA Report предоставляет

высокоуровневый обзор производительности SLA по спискам наборов.

Каждая строка содержит индикатор состояния последнего раздела

данных, а также гистограммы, отражающие данные о времени выгрузки

(красные столбцы показывают дни, когда время выгрузки не

соответствует SLA).

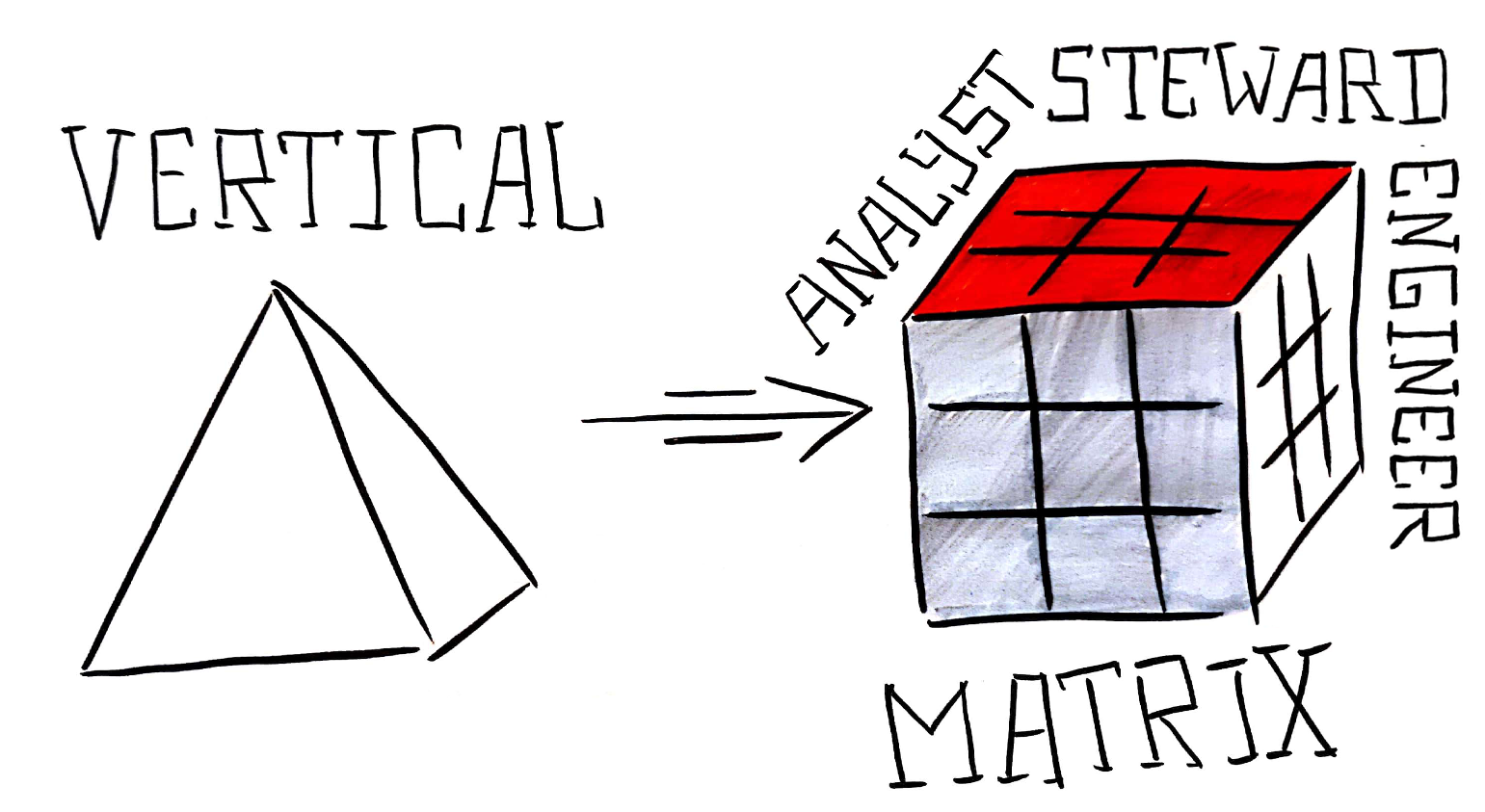

Рис. 2 Пример происхождения данных набора

"A". "A" зависит от "B", который зависит от "C" и "D", и так далее.

Рис. 2 Пример происхождения данных набора

"A". "A" зависит от "B", который зависит от "C" и "D", и так далее.

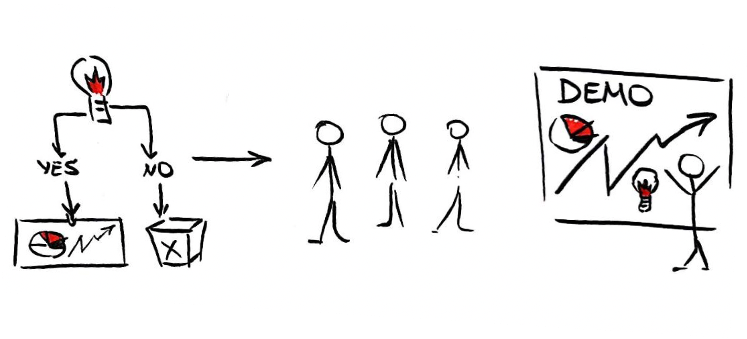

Рис. 3 Ранняя разведка с акцентом на

происхождение набора. В каждой графе указано историческое время

выгрузки каждого набора данных в более крупном конвейере.

Рис. 3 Ранняя разведка с акцентом на

происхождение набора. В каждой графе указано историческое время

выгрузки каждого набора данных в более крупном конвейере.

Рис. 4 Timeline даёт чёткое представление

о последовательности и продолжительности преобразований данных,

сохраняя при этом важные иерархические зависимости, которые дают

последовательности контекста. Исторические данные о времени

выгрузки отображаются для каждой строки набора слева от промежутка.

Рис. 4 Timeline даёт чёткое представление

о последовательности и продолжительности преобразований данных,

сохраняя при этом важные иерархические зависимости, которые дают

последовательности контекста. Исторические данные о времени

выгрузки отображаются для каждой строки набора слева от промежутка.

Рис. 5 Сравнение всей линии происхождения

(слева, n=82) и отфильтрованного пути к "узкому" месту (справа,

n=8). Пути узких мест значительно улучшают соотношение сигнал шум и

облегчают поиск проблемных этапов больших конвейерах.

Рис. 5 Сравнение всей линии происхождения

(слева, n=82) и отфильтрованного пути к "узкому" месту (справа,

n=8). Пути узких мест значительно улучшают соотношение сигнал шум и

облегчают поиск проблемных этапов больших конвейерах.

Рис. 6 Исторические распределения времени

выполнения и задержек помогают быстро отличить SLA (красным цветом)

из-за позднего начала вверху и сравнить с длительным выполнением

внизу. Объединив эти взаимодополняющие представления в SLA Tracker,

мы получаем полную перспективу своевременности данных (рис.

7).

Рис. 6 Исторические распределения времени

выполнения и задержек помогают быстро отличить SLA (красным цветом)

из-за позднего начала вверху и сравнить с длительным выполнением

внизу. Объединив эти взаимодополняющие представления в SLA Tracker,

мы получаем полную перспективу своевременности данных (рис.

7). Рис. 7 Трекер SLA состоит из нескольких

представлений. Представление Report даёт обзор состояния набора

данных, Lineage позволяет провести анализ первопричин времени

выгрузки, а Historical фиксирует исторические тенденции в

подробностях.

Рис. 7 Трекер SLA состоит из нескольких

представлений. Представление Report даёт обзор состояния набора

данных, Lineage позволяет провести анализ первопричин времени

выгрузки, а Historical фиксирует исторические тенденции в

подробностях.

Рис. 8 Эволюция визуального отображения

времени выгрузки; отображены текущее и типичное время.

Рис. 8 Эволюция визуального отображения

времени выгрузки; отображены текущее и типичное время.

Рис. 9 Эволюция диаграммы Ганта Lineage

(слева направо): первые ящики с усами, множество промежутков;

простые промежутки с дугами зависимостей; упрощение поиска узких

мест.

Рис. 9 Эволюция диаграммы Ганта Lineage

(слева направо): первые ящики с усами, множество промежутков;

простые промежутки с дугами зависимостей; упрощение поиска узких

мест.

Рис. 10 Разработка простого, но

согласованного языка дизайна (слева) во всех представлениях SLA

Tracker (справа) помогла сбалансировать плотность информации,

сделав элементы более понятными.

Рис. 10 Разработка простого, но

согласованного языка дизайна (слева) во всех представлениях SLA

Tracker (справа) помогла сбалансировать плотность информации,

сделав элементы более понятными.

Эта космическая мегаструктура может стать

ключом к воскрешению и обретению бессмертия

Эта космическая мегаструктура может стать

ключом к воскрешению и обретению бессмертия

Так выглядит

Сфера Дайсона.

Так выглядит

Сфера Дайсона.