Дата-центры становятся всё более важными объектами, ведь от их нормальной работы зависит как нормальный ход работы многих крупных и мелких компаний, так и сохранность данных обычных пользователей. Всего минута простоя крупного дата-центра может стать причиной миллионных убытков для клиентов оператора ЦОДа. Ну, а многочасовые или тем более многодневные простои приводят к убыткам, которые вообще иногда невозможно оценить. Под катом наиболее известные аварии последнего времени с описанием причин их возникновения.

Пожар в дата-центре OVH

В марте 2021 года почти полностью сгорел один из дата-центров OVH. Это самая крупная авария последних лет, ведь OVH один из крупнейших хостинг-провайдеров Европы. Пожар был настолько сильным, что практически уничтожил дата-центр SBG2. Основной подозреваемый одна из систем бесперебойного питания, с внутренним порядковым номером UPS7. Накануне пожара эта система проходила техническое обслуживание, в ходе которого в ней поменяли большое количество компонентов. По завершении процедуры UPS7 запустили вновь, и работа ее вроде как была штатной. Но вскоре случился пожар.

К слову, пожары в дата-центрах, тем более такого масштаба, происходят крайне редко. Учет подобных случаев ведёт Uptime Institute по словам его представителей, в среднем пожары случаются реже раза в год. В большинстве случаев инциденты удалось прервать в самом начале развития, но в некоторых случаях огонь всё же выходил из-под контроля.

В случае OVH с перебоями в работе, вызванными последствиями пожара в SBG2, столкнулись около 3,6 млн веб-сайтов.

После изучения ситуации с OVH эксперты пришли к выводу, что причин бедствия могло быть несколько и дело не в одном только бесперебойнике. Разрастанию масштаба инцидента способствовали:

- Конструкция дата-центра. Он башенного типа (Tower design). Здесь используется схема конвекционного охлаждения, когда нагретый воздух поднимается по башне в самом центре здания. В целом такая конструкция считается надежной и экологичной, но последние данные о распространении пожара говорят о том, что огонь, попав в конвекционную систему, быстро разошёлся по зданию.

- Возможное отсутствие в дата-центре, где произошло возгорание, системы сверхраннего обнаружения пожара. Более того, есть информация, что там не было ни систем газового, ни систем водяного пожаротушения. Вместо этого использовались датчики дыма и огнетушители.

Последнее тем более странно, что сейчас существует огромное количество решений для поддержания безопасности. Скажем, есть датчики, которые контролируют параметры окружающей среды и способны работать с ИБП. Например, датчик мониторинга окружающей среды Eaton EMP002 отслеживает температуру, влажность, ведет мониторинг работы сопряженных устройств вроде датчиков задымленности или детектора открытия двери. Кроме того, существуют системы безопасности, которые способны улавливать изменения температуры в доли градуса, отслеживать концентрацию угарного газа и прочих веществ. В случае выявления проблемы такие девайсы уведомляют оператора службы технической поддержки и включают сигнал опасности.

Пожар в дата-центре WebNX

В апреле 2021 года произошел пожар в дата-центре Ogden американской компании WebNX. Загорелся генератор, после чего пожар распространился на прилегающие помещения. В результате произошло полное отключение энергоснабжения, пострадало серверное оборудование. Некоторые серверы, сильнее всего поврежденные огнем, вряд ли удастся восстановить.

Ситуация вышла из-под контроля после того, как прекратилось энергоснабжение города, который поставлял энергию для дата-центра, в дата-центре включились несколько автономных генераторов энергии, но в одном из них произошла поломка, которая и привела к возгоранию.

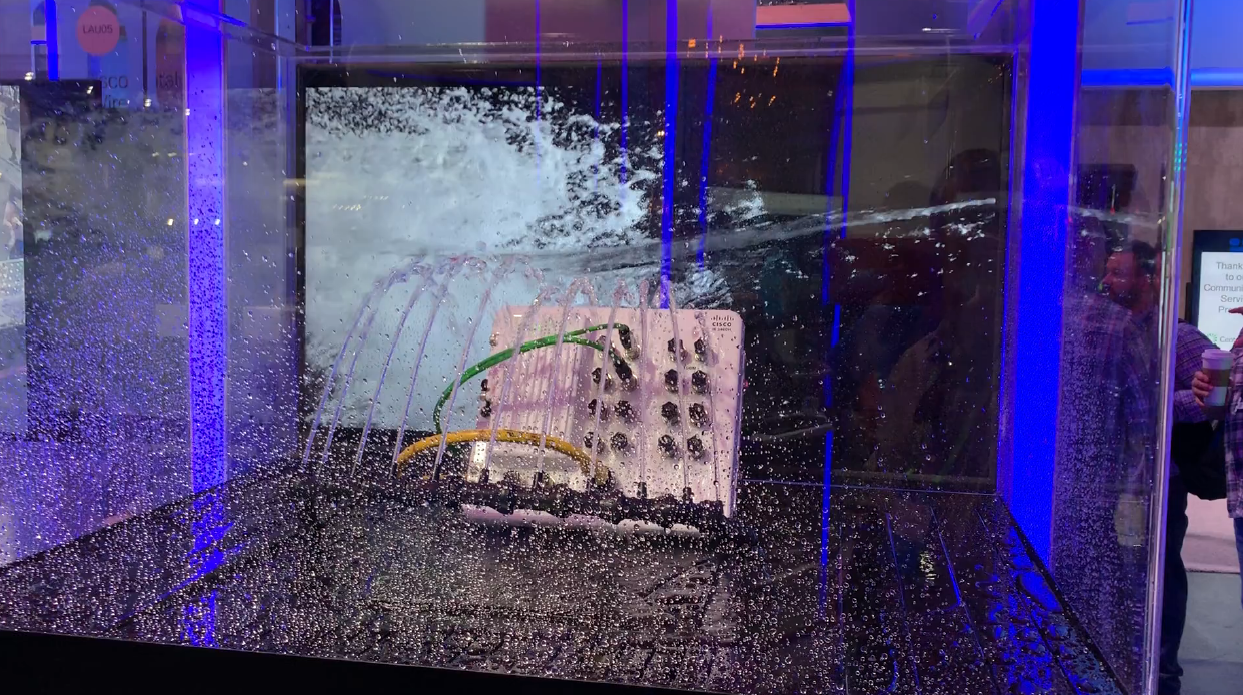

Прибывшие пожарные потушили огонь, но их действия привели к повреждению оборудования водой в помещениях, затронутых огнем.

В этом дата-центре размещались и серверы компании Gorilla Servers. Правда, оборудование этой организации не пострадало, но в результате отключения энергии прекратили работу сервисы и сайты клиентов. Дата-центр оказался обесточенным на несколько часов, восстановление работы всех систем потребовало около 20 часов. Убытки оператора дата-центра в этом случае превысили $25 млн.

Сбой в работе дата-центра банка TSB

В сентябре 2018 года британский банк TSB решил провести обширную миграцию IT-оборудования, не проведя перед этим тестирование нового дата-центра. Самое обидное для компании то, что поставщик IT-услуг Sabis, которого наняли для проведения миграции, протестировал все дата-центры, затронутые в ходе миграции, кроме одного. При этом факт того, что тестирование не проведено, был скрыт от руководства.

Итог плачевен: два миллиона клиентов банка одномоментно лишились доступа к счетам. Банку пришлось потратить около $480 млн на устранение последствий сбоя в работе ЦОД, включая сборы за расследование инцидента в размере примерно $35 млн.

Пожар в лондонском дата-центре Telstra

В августе 2020 года пострадал дата-центр Telstra, крупнейшей телекоммуникационной компании Австралии. Как и в случае с OVH, проблема возникла из-за неисправного ИБП. Несмотря на то, что огонь удалось локализовать, в отличие от OVH, инцидент затронул большую часть площади дата-центра, а это 11 000 квадратных метров. Внутри помещений, где возникло возгорание, находилось около 1800 серверных стоек.

На место отправили сразу четыре пожарные машины и 25 членов экипажа. Похоже на то, что команда сработала очень хорошо, поскольку огонь смог серьезно повредить лишь небольшую часть складского помещения. Из персонала никто не пострадал.

Тем не менее, несколько десятков серверов оказались в офлайне, их работу удалось восстановить лишь через несколько часов. Соответственно, не работали сервисы и сайты клиентов Telstra. Общие убытки компании превысили $10 млн, не говоря уже о репутационных потерях.

Поломка ИБП в дата-центре Equinix LD8

В августе 2020 года возникла и проблема с энергосетью дата-центра Equinix LD8: Там после отключения подачи энергии из сети отказал ИБП. Пожара не было, но проблему с электрическом не удавалось решить на протяжении нескольких часов, так что пострадало немало клиентов.

Авария случилась в ЦОД на территории лондонского района Доклендс, причем сотрудники поддержки смогли понять причину проблему почти сразу после ее появления. Как оказалось, отключившийся ИБП обесточил главный кластер маршрутизаторов Juniper MX и Cisco LNS. Именно этот кластер обеспечивал работу большей части оборудования дата-центра.

После того, как кластер обесточился, отключились сервисы крупнейших компаний клиентов Equinix. В их число входят международные телекоммуникационные компании Epsilon, SiPalto, EX Networks, Fast2Host, ICUK.net и Evoke Telecom. Повлияла авария и на работу других дата-центров.

В качестве вывода скажу, что это далеко не все аварии, которые случились за последние несколько лет. Но, вероятно, эти инциденты можно назвать наиболее показательными, поскольку их можно было предотвратить. Непрофессионализм сотрудников, проблемы с ИБП, отключение питания достаточно распространенные проблемы. А с какими сложными инцидентами в дата-центрах сталкивались вы? Если есть что рассказать давайте обсудим в комментариях.

Бонус: отключение энергии из-за технических работ

Есть и ситуации, которые достаточно сложно (хотя и можно) предусмотреть. Например, в The Register как-то пересказали историю, присланную в редакцию одним из читателей. Жила-была серверная ферма с тремя ИБП на 220 кВА, работала себе вполне нормально довольно долго. С течением времени потребность в одном из ИБП отпала, и его решили переместить в недавно открытый новый ЦОД. Руководство планировало сэкономить на покупке нового ИБП но вышло иначе.

Стоит отметить, что ЦОД, о котором идёт речь, немаленький, его площадь составляла около 2500 квадратных метров. Оборудования было много, несколько сотен серверов, так что допустить какие-то либо проблемы было смерти подобно.

В ЦОД пригласили профессиональных электриков, на которых и возложили обязанность отключения от сети одного из ИБП и его транспортировки с дальнейшим подключением в новом ЦОДе. В итоге профессионалы сделали что-то не то, и дата-центр полностью обесточился.

Я сидел за рабочим столом, когда электрики начали отключение блока ИБП от сети. Они перевели систему в режим байпаса без проблем. Затем они обрезали автомат защиты на выходе и еще несколько проводов для ускорения демонтажа. И тут дата-центр площадью 2500 квадратных метров вдруг затих. Я побежал в машзал, ожидая обнаружить пораженных током электриков. Но они просто спокойно отсоединяли провода. Я закричал, что ЦОД ушел в офлайн, на что электрики ответили, что оборудование запитывается в режиме байпаса. Я повторил. Они остановились, подумали секунд десять, а затем их глаза открылись по-настоящему широко, рассказал очевидец.

Восстанавливать работоспособность дата-центра пришлось 36 часов, хотя изначально электрики заявили о часовом простое.