Валентин Нык, Руководитель отдела систем управления

ИТ-инфраструктурой, КРОК

В КРОК появилась идея создать систему комплексного мониторинга (СКМ), которая заменит существующие промышленные решения. Такая потребность возникла, потому что бизнесу стало невыгодно пользоваться иностранными разработками. Они подорожали, не учитывают потребности российских клиентов и могут попасть под санкции.

Проблема

Крупные компании давно используют разные СКМ. Однако пользоваться ими стало невыгодно. Ниже расскажем, почему.

После кризиса в 2014 г. курсы валют выросли примерно в два раза. Автоматически подорожали и промышленные решения. Поэтому компании пытаются оптимизировать решения или модель владения ими.

Иностранные разработки не ориентированы на российский рынок. Клиенты из России в среднем занимают 1% от глобального рынка. Поэтому разработчики неохотно решают их проблемы.

В стране действуют санкции, а государство ведёт политику импортозамещения. Из-за этого бизнесу труднее использовать иностранное ПО.

С 2014 года у нас изменились экономические реалии. Связаны они, в первую очередь, с курсом валюты. Стоимость владения промрешением за несколько месяцев стала в два раза дороже. И даже для крупных наших заказчиков это стало проблемой. Последние лет пять многие занимаются тем, что оптимизируют модель владения технологическими решениями.

Валентин Нык, руководитель отдела систем управления ИТ-инфраструктурой ДИТ

Задача

Чтобы решить проблему, нужно разработать СКМ на альтернативном стеке решений. Такой стек может включать в себя СПО, решения с открытым исходным кодом и собственные разработки.

Требования к СКМ

Важно, чтобы СКМ не уступала по функционалу иностранным промышленным решениям, но при этом стоила дешевле.

Решение

При создании СКМ в КРОК опирались на накопленный опыт. Концептуальная архитектура СКМ в целом повторяет промышленные решения иностранных вендоров и состоит из трех основных уровней:

-

сбор данных,

-

анализ данных,

-

представление результатов мониторинга.

Архитектура СКМ

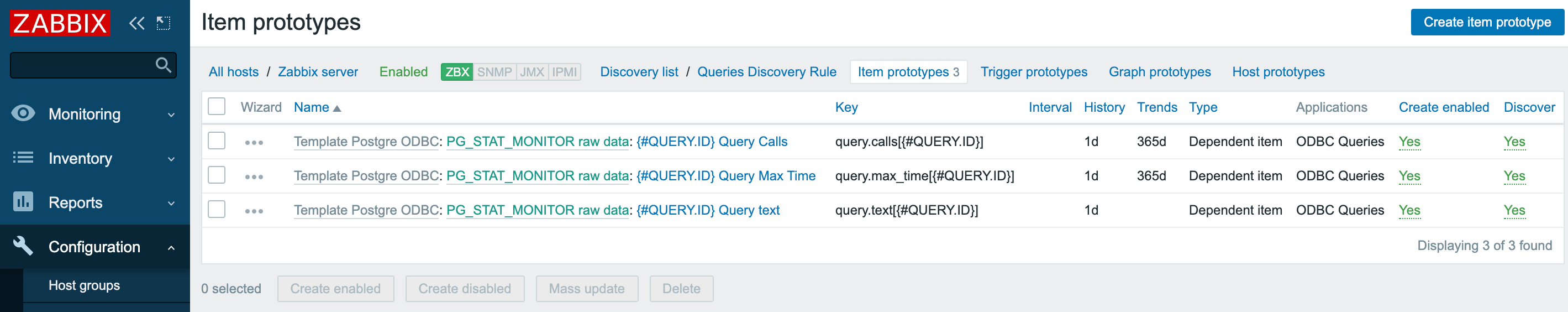

Уровень сбора данных занимает Zabbix. Система собирает данные и передает их на следующие уровни. Zabbix позволяет проводить разноплановый мониторинг и работает с различными объектами мониторинга: от серверов и операционных систем до сети и внешних систем.

На уровне аналитики решаются задачи мониторинга услуг. Данные с первого уровня используют для построения ресурсно-сервисных моделей, машинного обучения, обработки графов и аналитики.

На уровне представления используется классический набор решений. С их помощью данные, собранные на первом уровне, можно представить по-разному, например, в виде графиков или 3D-моделей.

С помощью Zabbix компания КРОК создала СКМ, которая:

- закрывает все логические уровни в классической ИТ-инфраструктуре,

- не уступает по функционалу иностранным промышленным решениям,

- может быть адаптирована к требованиям заказчиков,

- позволяет проводить интеллектуальный анализ и постанализ данных по любым моделям.

Где ещё можно использовать Zabbix

Ниже представлены кейсы компании КРОК, в которых использована система Zabbix.

- Zabbix и SOC**.** По статистике, основной источник событий, связанных с информационной безопасностью, события из ИТ-инфраструктуры. Если интегрировать SOC с Zabbix, то система мониторинга станет источником этих событий для SOC. Такая интеграция позволяет принимать взвешенные решения по отработке инцидентов ИБ.

- Zabbix и система управления. Любую систему управления можно сделать более гибкой. Для этого нужны данные интеллектуального мониторинга. Система проанализирует их и будет принимать решения, которые учитывают реальную ситуацию в ИТ-инфраструктуре.

- Zabbix и управление мощностями. Развивающемуся бизнесу часто требуются новые мощности. Покупать дополнительное оборудование и софт дорого. Выгоднее оптимизировать те, что уже есть.

С оптимизацией помогает Zabbix. Система служит источником больших данных, на основе которых можно строить модели и делать прогнозы.

- Мониторинг как услуга. В России начинают развиваться management services, платные услуги ИТ-компаний для бизнеса. Мониторинг тоже можно продавать в качестве такой услуги. В этом случае Zabbix будет отличным источником данных для расчёта стоимости владения, оказания платных ИТ-услуг.

Возможности

Zabbix

Возможности

Zabbix

Компания КРОК российский разработчик ПО, мобильных приложений, интегрированных платформ, решений для защиты данных и оптимизации их хранения. Сотрудничает с более чем 270 производителями оборудования и ПО. Её услуги и решения направлены на повышение эффективности работы компаний с помощью ИТ. В приоритете компании комплексный подход, который сочетает оптимизацию инфраструктуры и автоматизацию бизнес-процессов.

Штаб-квартира: Россия, Москва

Количество сотрудников: 1 777

Дата основания: 1992 г.