Соавтор книг А я был в компьютерном городе и Энциклопедия профессора Фортрана подарил IT-музею DataArt два компьютера из 1990-х, успевших стать раритетами: Mac от Apple в идеальном состоянии и графическую станцию O2 Silicon Graphics. А в новом интервью нашему музейному проекту рассказал о видеоплате в рюкзаке с тушенкой, временах запретов на ввоз стратегической электроники в СССР, забытом на орбите спутнике и удивительном путешествии в Лондон.

Правда ли, что вы первым привезли в СССР графическую плату с видеовыходом?

Да, с платой видеовывода я был первым среди первых. В те времена существовала единственная плата с композитным видеовыходом для PC, и производила ее малюсенькая компания Vine Micros из Великобритании. Серьезную графику тогда делали на специализированных графических станциях компании Silicon Graphics, которые по вычислительной мощности относительно PC можно было назвать суперкомпьютерами. Ну и стоили они соответственно, да еще и были запрещены к ввозу в нашу страну.

В конце 1980-х компания Vine Micros была известна в Великобритании благодаря устройству, позволявшему переписывать игры с кассет на дискеты, делать скриншоты, останавливать игру и сохраняться в точках, не предусмотренных издателем. Их Master Replay подключался к домашнему компьютеру BBC Micro

Но давайте все по порядку. Эта история случилась на стыке эпох, когда разваливался Советский Союз, факс был роскошью, а интернета не было и в помине. Зато были энтузиазм, молодость, напор и огромное желание заниматься компьютерной графикой. По нынешним меркам, это сравнимо с идеей слетать на Марс с билетом в один конец. Мой друг тогда писал графический редактор для САПР в загадочном совместном предприятии, вроде бы организованном некой коммунисткой с Кипра. У него у единственного был полный лицензионный Borland Turbo С с документацией, купленный конторой за валюту. Добрый друг копировал и щедро раздавал софт всем своим приятелям и знакомым, которые тогда работали на ломаных урезанных сборках и без документации.

В те времена еще действовал Координационный комитет по экспортному контролю, объединявший 17 стран и составлявший списки стратегических технологий, не подлежащих экспорту в страны Восточного блока. Под запреты COCOM или КоКом попадали и 386-е процессоры импортировать их в СССР было запрещено. Тем не менее, процессоры все равно ввозили через третьи страны. Как известно из трудов классиков марксизма-ленинизма, нет такого преступления, на которое бы не пошел капиталист, если его прибыль превысит 100 %. Цитата не точная, т. к. основы марксизма-ленинизма я сдавал очень-очень давно, еще когда учился в МИФИ на факультете теоретической физики.

Иллюстрация к колонке, приветствующей планы администрации Джорджа Буша-старшего по смягчению ограничений экспорта в страны Восточного блока. Журнал Computerworld, 1990 г.

Запрещенные процессоры и компоненты в обход COCOM поступали в СССР через Индию. На их основе уже здесь в недрах всевозможных совместных предприятий собирались компьютеры, писался оригинальный софт под DOS, благодаря которому наши изделия прыгали, летали, плавали и перехватывали изделия вероятного противника. Шустрые индийские бизнесмены на компьютерной контрабанде в те времена сколачивали миллионные состояния, расслаблялись, теряли бдительность и выезжали из страны на Запад, дабы потратить нечестно заработанное легким трудом. По прилете спецслужбы их вязали прямо на трапах самолетов. Как сейчас помню британскую газету с фотографией на передовице, где на знакомого мне индуса (заезжал в нашу контору с заманчивыми предложениями) в аэропорту Хитроу надевают наручники. Сейчас фраза сесть за 386-й процессор звучит абсурдно, но попавшим тогда под раздачу компьютерным контрабандистам, севшим лет этак на 68, было совсем не смешно.

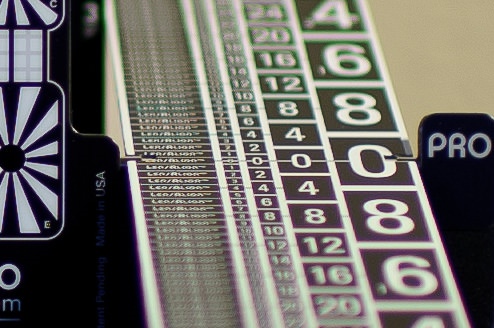

Реклама первого видеоконвертера Vine Micros из путеводителя по выставке Electron & BBC Micro user show, проходившей в Лондоне 912 мая 1985 года

Давайте вернемся к Vine Micros. Виноград в названии дань моде на фрукты, как яблоко у Apple?

Видимо, да, но мы тогда воспринимали это по другому. Мне кажется, для русских все, что связано со спиртом, вином и прочим алкоголем святое. Опыт общения с научными работниками в советских лабораториях подсказывал, что любой наш научник, чем бы он ни занимался искусственными алмазами или выращиванием кристаллов для микроэлектроники накануне дня рождения любого из соратников из подручных материалов легко мог собрать самогонный аппарат, а после торжества снова превратить его в вакуумную установку для экспериментов. И эта картинка с виноградом на эмблеме компании, созданной в британском гараже, однозначно говорила, что в графстве Кент сидит наш человек. Принял вина на грудь, почесал репу, взял плату EGA, перепрограммировал чип, потом поработал паяльником и выдернул из платы видеосигнал. Появилась возможность подключать видеомагнитофон и писать на него графику в реальном времени. Да, EGA это мало цветов, да, низкое разрешение, но это лучше, чем вообще ничего. Хоть и сделана плата была на любительском уровне, но низкая цена и возможность наложить бегущую строку на телекартинку открывала огромные возможности для той же телевизионной рекламы. Полноцветная графическая станция от Silicon Graphics стоила как дорогой автомобиль, а плата Vine Micros как крошечная деталька от этого автомобиля.

Под запрет COCOM эта платка не попадала?

Нет, конечно. Главное было не называть ее конвертером. Конвертер уже намек на военное применение. В то время были случаи (да они и сейчас бывают), когда вояки по ошибке сбивали гражданские воздушные суда. То ли из-за сбоя в работе системы распознавания свой-чужой, то ли из-за ошибки оператора. Каждая такая история имела большой политический резонанс: шли международные расследования, семьям погибших полагались миллионные страховые выплаты. Что самое интересное, до конца не было ясно, как и почему это происходило. Чтобы разобраться, кроме объяснений всех участников, нужно было посмотреть изображения на экранах и понять, как их интерпретировали операторы.

По запросу военных в Англии, некая компания под руководством загадочного мистера Винтера стала делать видеоконверторы для записи изображения с монитора на видеомагнитофон. Стоила такая железка, как спортивный автомобиль, но вояки денег не жалели. Как я познакомился с мистером Винтером, я вам еще расскажу, а пока давайте вернемся к истории с Vine Micros. Согласно информации из полученного по почте компьютерного журнала, стоила их платка с видеовыходом аж 199 фунтов стерлингов. Я пошел с журналом к руководству совместного предприятия, где тогда работал, с просьбой выделить 200 фунтов на закупку. Ранее мне неоднократно отказывали, а коммерческий директор писал на моих служебных записках резолюции: Не вижу рынка. Мультикам денег не давать. Нашу небольшую группу софтописателей коммерческий отдел называл мультиками так они определяли, чем мы в их конторе занимаемся. Я решил предпринять ход конем и отправился на прием к самому-самому главному на предприятии Генеральному Директору. Между нами состоялся интересный диалог:

Ну и сколько стоит эта твоя плата? лениво поинтересовался босс.

199 фунтов! выпалил я. Денег на проживание мне не надо у знакомых англичан поживу. И на метро не надо пешком буду ходить. Нужно только 199 фунтов на покупку платы и самый дешевый билет до Лондона и обратно. Британская виза у меня есть.

Питаться ты святым духом собираешься? поинтересовался босс и пригубил кофе.

Это мои проблемы, отвечаю. Тушенку и сгущенку с собой привезу, буду консервами питаться.

Разговор о консервах поломал боссу кайф от аромата дорогого кофе. Он скорчил гримасу разочарования и долго смотрел мне в глаза мутноватым немигающим взглядом. Я в напряжении ждал то ли уволят за наглость, то ли денег дадут.

Наконец босс принял решение: Я сейчас позвоню в бухгалтерию, чтобы оформили тебе командировку, купили авиабилеты и выдали 200 фунтов на руки. Чеки привезешь и отчитаешься. Ну и подарок какой-нибудь для моей секретарши из Лондона привези. Такой вариант устраивает?

Очень даже устраивает! воскликнул я и счастливый побежал в бухгалтерию.

Визитка Адександра Труханова, начало 1990-х. Обратите внимание, что электронной почты еще нет, зато указан телекс

Позже выяснилось, что скучающий шеф просто решил развлечься и устроил тотализатор на тему Вернется ли Саша из Англии или останется там бомжевать. В окружении босса делали ставки. Ставили в основном на бомжевать. На мое возвращение, да еще и с платой, никто всерьез не надеялся. Особым шиком в комбинации босса был выданный мне билет Аэрофлота с открытой датой и в бизнес- класс, чтобы ни в чем себе не отказывал. Ну и 200 фунтов в кармане джинсов на все про все, включая плату. В самом начале 1990-х мне предстоял реальный квест под названием Выжить, купить и вернуться.

Ну и как, справились с заданием?

Не без издержек, но справился. В Лондон я прилетел с рюкзаком, набитым банками с армейской тушенкой и сгущенкой. Там же лежали две пачки сигарет Космос для облегчения контакта с местным населением (сам я не курю) и фотоаппарат ФЭД для обмена на фунты стерлингов в комиссионном магазинчике напротив здания корпорации BBC. Остановился на квартире, которую снимали мои британские друзья. Сами друзья уехали к другим друзьям, а в пустующую комнату поселили меня. Компания в двухэтажном домике была достойная: молодой оператор с местного 4-го канала и фотокорреспондент из Австралии с подругой, которые получили разрешение на работу в Великобритании на два года. Первое, что они мне показали, была их еда в холодильнике. Пояснили, что на мою тушенку не претендуют, но и к их йогуртам тоже просят руки не тянуть. А в остальном мир, дружба, жвачка. Я им подарил пачку Космоса и набор значков с изображением Ленина в ассортименте: Ленин маленький (октябрятский значок), Ленин юный (комсомольский) и Ленин зрелый (профиль вождя с подписью КПСС). От Ленина и сигарет ребята отказались по их мнению, у Ильича слишком сомнительная репутация, а сигареты Космос слишком крепкие. Попросили поменять дары на значок с Юрием Гагариным первый космонавт вызывал у них неописуемый восторг и шел на ура. Вскоре запасы значков с Гагариным в моих закромах закончились.

К австралийцам по вечерам подваливали соотечественники. Они курили странные сигареты, от которых звенело в голове, пили пиво и беседовали о жизни в Великобритании. Я их развлекал анекдотами про советского разведчика Штирлица и его приключениями в нацистской Германии. Особой популярностью пользовался эпизод, когда Штирлиц шел по ночному Берлину, а навстречу ему шли проститутки. Проститутки, подумал Штирлиц. Штирлиц, подумали проститутки.

Эта многослойная история была сродни своеобразному британскому юмору, и австралийцам Штирлиц нравился. У большинства из них было разрешение на работу сроком на два года. Заработал денег в Англии и дуй обратно домой в свою Австралию. Собственно, австралийская тусовка мне плату и помогла купить. В их среде обнаружилась пара русских австралийцев, прибывших из Сиднея в Лондон туристами. Их бабушка Дуня во время Второй мировой войны эмигрировала в Австралию, и по-русски они говорили почти без акцента. Все понимали, что без платы я обратно не уеду русский компьютерный фанатик! денег на дорогу у меня нет, как и счета в банке, чтобы произвести оплату.

Судя по адресу, так выглядел офис компании Vine Micros в графстве Кент. В 2004 году ее вместе с правами на технологию CORIO приобрела корпорация tvONE

Но у ребят тур по Великобритании как раз пролегал через графство Кент. Я отдал им свои выстраданные 200 фунтов, и через неделю они вернулись с вожделенной платой. Выяснилось, что 199 фунтов цена без VAТ, и австралийцам пришлось еще и доплатить свои кровные. Я пытался что-то им подарить в качестве благодарности, но они со словами забудь! отказались. Все-таки русские они и в Австралии русские, за что им огромное спасибо. В Москву я вернулся счастливым, хотя и слегка социально изношенным.

Подарок секретарше босса привезли?

Секретарше нет, а боссу привез. Гуляя районе Сохо среди диковинных для советского человека секс-шопов, попал под рекламную акцию: узнав, что я из Москвы и приехал по бизнесу, продавец-афробританец оценил мой интерес к передовым секс-технологиям и подарил набор черных презервативов то ли с усиками, то ли с пупырышками. Я взял у него визитку и пообещал в случае успешного тестирования закупить большую партию. Уникальное по тем временам изделие я подарил по возвращении боссу. Тот был удивлен трижды: и моим возвращением с платой, и фактом подарка, и самим подарком. После этого доверие к моим идеям резко возросло. Меня стали приглашать переводчиком на встречи с зарубежными визитерами. Иногда такие переговоры проходили в бане под водку с коньяком. Один раз начальство в состоянии изрядного подпития чуть было не продало буржуинам уже выведенный из эксплуатации, но еще болтающийся на орбите спутник. С трудом их отговорил, но, как у нас водится, меня же крайним и сделали: Ты англичанам в бане про спутники переводил, вот сам с ними и разбирайся Когда я прочитал, что какому-то западному господину продали луноход, оставшийся на спутнике Земли, ничуть не удивился сам участвовал в подобном.

Если вернуться на Землю, как вы вообще передвигались по Лондону без копейки?

Денег не было не только на метро их не было совсем. В центр Лондона от станции Балем, где я жил, ходил пешком через индийский район. Там сплошь мелькали сари и чалмы. До Биг-Бена я доходил часа за два. Один раз меня в переулках окружили лондонские хулиганы, пытались наехать, запугать и деньги отобрать. Британская шпана тогда обувалась в тяжелые ботинки с металлическими подковками, чтобы бить жертвы ногами. Их сленга я не понимал, на угрозы не реагировал и оставался невозмутимым то есть в привычный образ жертвы не вписывался. Да и за свои 199 фунтов на покупку платы я бы бился не на жизнь, а на смерть. А если учесть, что еще школьником я изучал дзюдо в чуть ли не в единственной в СССР специализированной спортивной школе в городе Электросталь (тогда в Советском Союзе в основном распространено было самбо), а в студенческие времена посещал полулегальную секцию каратэ в общежитии МИФИ, то шпану ожидала масса сюрпризов. Видимо, вожак гопников это почувствовал и, прекратив угрожать, спросил: Откуда ты такой взялся? Я из Советского Союза, отвечаю и показываю значок с Лениным. Это тебе на память. Тут гопники растерялись. Видимо, вспомнили популярный тогда боевик Красная жара со Шварценеггером в роли советского милиционера. Вспомнили и с криками валим отсюда! растворились в подворотнях.

Центральная школа каратэ в Москве, середина 1980-х

Вообще в моих пеших походах по Лондону было немало смешных эпизодов. Как-то сидел я на лавочке с видом на Биг-Бен и вел неспешную беседу с британским пенсионером, присевшим рядом. Старичок поинтересовался откуда я, а когда узнал, что из Москвы, выдал удивительную фразу: О! Я слышал, у вас там большие проблемы в магазинах нет свежих апельсинов! Мне очень хотелось закричать: Дед, каких еще, блин, апельсинов! У нас вообще ни хрена в магазинах нет! Но сдержался. Тут меня пенсионер толкает в бок и показывает в сторону молодой парочки, направляющейся к нашей скамейке: Смотри, смотри, Алекс! Это американцы. Сейчас спросят, как называется река и что это за здание. Так это же Биг-Бен! я был удивлен до глубины души. Как можно этого не знать! Американцы они таки. Денег много, а не знают ни фига. За это мы их и не любим, проворчал дедок. Сейчас ты объяснишь им, что Биг-Бен это Биг-Бен, а Темза это Темза. Потом они начнут спрашивать, где можно купить чай в жестяной коробке в форме лондонской телефонной будки и сувенирного гвардейца в медвежьей шапке. Я дедушке ответил, что про Темзу я, конечно, отвечу, а про чай и сувениры пусть лучше он сам объяснит. На том и порешили.

Подходят к нам американцы: Привет! Как называется это здание? Это Биг-Бен, я начинаю нервно смеяться. Рречка Темза, а где сувениры купить, вам лучше дедушка объяснит

Без денег только гуляли ни в музеи, ни в кино было не попасть?

Почему же, я был даже на концерте авангардной музыки. Разумеется, безбилетником. У парня-телеоператора, живущего в том же домике, что и я, отец оказался композитором-авангардистом. Однажды парень взял меня с собой на премьеру. Подъезжает такси, мой британский приятель выходит во фраке с бабочкой, его девушка в вечернем платье и я в джинсах не первой свежести и мятой майке с эмблемой Олимпиады-80. Повезло, что на мое спасение уже у театра к нам присоединился еще один маргинал, ищущий себя безработный приятель сына композитора. Тоже в джинсах и мятой майке.

Господа отправились в ложу, а нам указали на места в партере с табличками зарезервировано. Сели. У нас с ищущим себя ни билетов, ни контрамарок вообще ничего. Вокруг джентльмены во фраках и дамы в вечерних нарядах. У меня появилось ощущение, что мы сидим на чужих местах. И не у меня одного. Подходит к нам пожилой и элегантный, как рояль, джентльмен и показывает свои билетики. С ним дама с потрясающим колье на шее. Ищущий себя начинает сбивчиво объяснять, что мы творческая молодежь, прибывшая по приглашению Самого Композитора, а рядом с ним сидит человек специально приехавший на премьеру из Москвы. Его вежливо слушают, но не верят. Вот-вот прогонят. Тут во мне срабатывает инстинкт самосохранения я встаю в полный рост, раскланиваюсь и представляюсь: Чайковский из Москвы, друг сына композитора. Джентльмен смутился, пробормотал что-то про Лебединое озеро, прогрессивную молодежь и вместе с дамой удалился. Позже администратор посадила их на другие места. Вероятно, прогонять Чайковского, даже с приставкой псевдо-, в британских музыкальных кругах сочли плохим тоном.

Кадр из рекламы совместного предприятия, в котором работал Александр Труханов. Фото из личного архива сделано с лампового телевизора на пленочный фотоаппарат и напечатано в ванной комнате. По сценарию в кабаке бизнес-паре (мужчине и женщине) официант озвучивает меню компьютеры такие-то и такие-то за валюту и рубли. Начальство оплатило двух артистов и оператора, а на персонаже официант, как всегда, сэкономили предполагалось, что его роль исполнит коммерческий директор. Но тот отказался: Мне статус не позволяет халдея играть!. Ну и вызвали меня: Ты там с телевидением чего-то мутишь, вот иди и снимись в рекламе. Сходил, снялся...

То есть поездка получилась увлекательной?

Может создаться ложное впечатление, что она была легкой слетал на досуге в Лондон за платой, прогулялся, развеялся. На самом деле все было довольно жестко. Хорошо, когда есть крыша над головой, но, когда нет монет даже на кофе, становится не только голодно, но и грустно. Спасали энтузиазм и целеустремленность. Эти качества оказались дороже денег, которых не было. Именно они вкупе с верой в себя помогли выполнить миссию, в успех которой не верил никто. За исключением меня самого, разумеется. Я воспитывался на советских песнях и искренне считал, что мы рождены, чтоб сказку сделать былью, преодолеть пространство и простор. Я и преодолевал: и книжку вместе с Андреем написал, и с отрицательным балансом в кармане умудрился видеоплату из Лондона привезти. Справедливости ради отмечу, что кофе я наловчился пить в офисах в Сохо, куда заходил для знакомства с новыми технологиями. Там его предлагали бесплатно.

Видеостена в Музее естествознания в Лондоне, построенная по технологии компании Memotech под управлением Брайана Пайпа

В одной из компаний в Сохо я познакомился с Брайаном Пайпом, строившим видеостены из электролучевых трубок (LCD тогда еще не придумали). Оказалось, что его жена Лиза раньше учила русский. Несколько раз они подкармливали меня в ресторанчиках, за что им огромное спасибо. Мои британские друзья тоже старались помочь договорились со знакомыми в русской службе ВВС о моем визите в гнездо антисоветской пропаганды. Я посетил Буш-хаус и за скромное вознаграждение дал пару интервью под псевдонимом Ведерников. Рассказывал о жизни в Москве, отвечал на актуальные вопросы.

Сева Новгородцев в редакции BBC в знаменитом здании Буш-хаус в центре Лондона, правда, уже в начале 2000-х. Всемирная служба BBC переехала из Буш-хауса в 2012 году. Источник фото

После одного из таких интервью некий Сева (но не Новгородцев, тот работал в другом отделе) сказал: Слушай, Саш, у нас тут путаница произошла: интервью пошло в эфир под твоей настоящей фамилией. Я понимаю, что могут быть проблемы по возвращении в Москву, но ты уж извини Я напрягся, тут же потребовал от Севы политического убежища с койкой прямо у него в кабинете и работу на ВВС за еду. Сева похлопал меня по плечу и сказал, что пошутил. И добавил, что легко любить Россию, особенно когда живешь в Лондоне. Я ответил, что тоже пошутил, но адреналин в моей крови бурлил еще достаточно долго.

Вы передали в наш музей графическую станцию Silicon Graphics O2. Как она к вам попала?

Рабочую станцию O2 компания Silicon Graphics представила в 1996 году в качестве замены более ранней Indy. Ee подробный обзор уже выходил на Хабре

Это отголоски старой истории с графическими станциями компании Silicon Graphics. На РС тогда приличной графики не было из-за низкой мощности процессоров, и заинтересованные структуры использовали суперкомпьютеры от SGI Octane или более доступные Indigo. Но все они стоили очень дорого. Бюджетные станции О2 появились позже. Какие структуры потребляли продукцию Silicon Graphics, можно догадаться по установленному на вашем O2 авиационному тренажеру. Кроме военных, инженеров аэрокосмической отрасли и физиков-ядерщиков, небольшое количество станций SGI могли себе позволить и телевизионщики с киношниками. В одной из студий в Сохо (именно там находились студии графики в Лондоне) мне показали пленку с кадрами из Терминатора. И дали мощную лупу, чтобы я мог увидеть дискретность графики. В кадре, где робот-убийца выходит из пламени, разрешение примерно 300 на 200, но длился фрагмент со спецэффектом около секунды. За это время человеческий глаз не успевает заметить дискретность. Все это мне показал инженер, который написал программу для интерполяции (растягивания) просчитанного на силиконе кадра до киношного разрешения. Затем на специальном устройстве шел покадровый сброс изображение с графической станции записывали на кинопленку. Процесс небыстрый, но другого тогда не было.

Скорее всего, Александр вспоминает этот фрагмент фильма Терминатор-2

Станции SGI попадали под запреты COCOM? Советские киношники на них рассчитывать не могли?

Да, из-за наших реалий. Станции, якобы купленные для кино, потом загадочным образом оказывались в каком-нибудь закрытом научном городке. Мне известна одна такая история: СССР рухнул, кругом бардак. И тут в офис SGI приходит факс от некой российской структуры, условно назовем ее атомной станцией: Ваш компьютер вышел из строя. Как нам его починить?

Все как в анекдоте советских времен: американский самолет-шпион сфотографировал пашущий поле мирный советский трактор. На недружественный акт самолета-разведчика наш мирный трактор ответил залпом ракет типа земля-воздух.

Получив запрос с атомной станции, буржуины напряглись, запросили серийный номер изделия и вышли на продавца. Правда, он утверждал, что про атомную станцию все переврали. Я с ним, кстати, был лично знаком мы начинали заниматься графикой примерно в одно время. Из тех энтузиастов уже и в живых-то почти никого не осталось.

Мы были первыми, кому удалось получить в Великобритании лицензию для ввоза в Россию четырех графических станции SGI для теле и кинопроизводства (в США это в принципе было невозможно). Идущим вслед за нами было уже проще прецедент был создан. Так вот, продавец клялся и божился, что ни о какой атомной станции он знать не знал, а продал Octane некому бюро для проектирования сельхозтехники или чего-то подобного. Был суд в Европе, но вроде тогда парню удалось отбиться. А может, та самая сельхозструктура ему отбиться помогла. Дело ясное, что дело темное будем считать, что все это слухи и неправда. Были санкции COCOM, и были те, кто эти самые санкции обходил. Извечное соревнование пули и брони. Но, как говорится, иных уж нет, а те далече.

Проходная вполне подходящего сельхозпредприятия. Кадр из фильма Карена Шахназарова Город Зеро, 1988 г.

Как же вы получили лицензию на ввоз?

Помог нам в этом загадочный мистер Винтер, производивший видеоконвертеры для нужд ихних госструктур. С ним я познакомился совершенно случайно. Когда я приехал в Лондон за платой Vine Micros, посетил пару книжных магазинов и переписал из журналов телефоны контор, связанных с компьютерной графикой. Так на мистера Винтера и вышел. Он был человеком со связями и в аэрокосмической сфере, и в банковской, и в области телекоммуникаций. Сейчас бы его можно было назвать инвестором в области новых технологий. Шустрый был мужичок.

Это он представил меня людям из SGI, он же организовал получение лицензии. Поначалу все шло хорошо: нужные письма и гарантии предоставлены, лицензия получена, заказ оплачен, компьютеры отгружены. Вроде все счастливы, но нет через некоторое время приходит от мистера Винтера факс с требованием доплатить ему приличную сумму сверх контракта. У него, видите ли, возникли юридические проблемы из-за полученной лицензии. Пришлось потратиться на адвокатов, да еще и какой-то штраф оплатить. Тогда мы ему ответили, что денег нам сверх контракта никто не даст, но, если ситуация для него критическая, мы можем задорого продать компьютеры не телевизионщикам, а на какую-нибудь атомную станцию и таким образом компенсировать ему штрафы. Мистер Винтер напрягся, от претензий отказался и больше от нас ничего не просил.

Кстати, мои контакты с SGI спустя много лет внезапно всплыли в Британском посольстве. Я обратился в очередной раз за визой, сдал документы. Вызывают меня к окошку, и сотрудник консульства, не моргнув глазом, заявляет: Мы не можем найти ваши документы.

Как так не можете найти? возмущаюсь я. Час назад я их сдал в соседнее окошко И паспорт мой тоже пропал?!

И паспорт найти не можем.

Как такое вообще возможно?! я был в полной растерянности. Что тут у вас за бардак?

Внезапно человек в окне задает мне вопрос: Что вы делали в Лондоне в таком-то году?

Я растерялся еще больше: Приезжал как турист, гулял, смотрел, развлекался. А в чем дело-то?

По нашей информации, вы встречались с представителем Silicon Graphics и приезжали в Лондон по приглашению SGI.

Да я не только с человеком из SGI встречался. Я еще и в студию Double Positive заходил, помогал с переводом продюсеру из Москвы. Но это было только в первый день моего визита. Потом я всю неделю гулял, смотрел на достопримечательности и развлекался.

Офицер в окне молча сунул мне в руки паспорт и удалился. Паспорт был мой. Я нервно пролистал страницы и обнаружил свежую британскую визу. Ну артисты! Пытались развести, как кролика! Сначала вывели из состояния душевного равновесия потерянным паспортом, потом внезапно задали интересующий вопрос. Им нужно было знать, что же я помню о встрече с SGI. А я ничего не помню. Не помню, как мы беседовали с сотрудником SGI о структуре их суперкомпьютеров и о скоростных массивах хранения данных. Применительно к спецэффектам в кино, разумеется. Видимо, та технология имела и иное применение, о котором я тоже не помню. И не собираюсь вспоминать даже спустя многие годы.

Кстати, у станции SGI O2 с авиатренажером, переданной в ваш музей, есть имя собственное: ее зовут BRAVO! Давным давно я отдал станцию своему хорошему знакомому Дмитрию Гуслинскому, специалисту в области кинопроизводства. Дмитрий хранил ее у себя почти 15 лет! Пятнадцать!!! Под роспись получил под роспись вернул. О2 до сих пор в рабочем состоянии и с оригинальной клавиатурой. Сам по себе факт вызывает восхищение, за что Дмитрию огромное спасибо. Это история еще раз подтверждает, что главное достояние нашей страны живущие в ней удивительные люди. Ну а нужную технику мы так или иначе раздобудем.

Переданный в музей Mac тоже с историей?

Его мы использовали для чернового монтажа, просматривали на нем футажи. В какой-то момент мы создали студию компьютерной графики BEE EYE (Пчелкин глаз) с участием Димы Диброва. В той студии был создан первый российский рекламный ролик с наложением трехмерной компьютерной графики на видеоизображение: в кадре вокруг еще молодого Константина Райкина летал смоделированный на компе подсвечник с горящими свечами, в воздухе вспыхивали молнии, гремели раскаты грома. Режиссером проекта выступил человек теперь настолько известный, что я не стану называть его имени.

Видеоклип Сергея Минаева на песню Ваучер, сделанный студией Bee Eye

Раритетные компьютеры отправились в нашу коллекцию, а мы надеемся на продолжение общения с Александром об удивительном времени создания Профессора Фортрана.

трассировка лучей от позиции наблюдателя

трассировка лучей от позиции наблюдателя

различные материалы, отрисованные

физически-корректным рендерингом

различные материалы, отрисованные

физически-корректным рендерингом

один из вариантов cornell box'a для

тестирования корректности рендеринга

один из вариантов cornell box'a для

тестирования корректности рендеринга

Угол падения, отражения и преломления

Угол падения, отражения и преломления

эффект Френеля

эффект Френеля

рендер одного кадра и нескольких, сложенных вместе

рендер одного кадра и нескольких, сложенных вместе

эффект бесконечного туннеля от двух

параллельных зеркал

эффект бесконечного туннеля от двух

параллельных зеркал преломление света при взгляде сквозь

прозрачную сферу

преломление света при взгляде сквозь

прозрачную сферу непрямое освещение и мягкие тени

непрямое освещение и мягкие тени