Вблоге мымного говорим про релокейт. Опыт укаждого разный,

ивкомментариях встречаются споры, где жить лучше, какой зарплаты

достаточно, как считать налоги. Ноесть тема, взгляды накоторую

сходятся. Интеграция влюбое общество происходит соскрипом если она

вообще возможна. Кто-то верит, что окончательно интегрироваться

получится только уихдетей холодок состороны местных чувствуется,

несмотря надружелюбные улыбки.

Швеция считается самой закрытой страной среди

европейских. Спросили инженера, который 2года назад уехал работать

вSpotify, удалосьли ему вписаться вместную культуру, икак это

сделать тем, кто только собирается переехать ксуровым северянам.

Рассказывает Константин

Голиков.

Как Костя оказался вШвеции

Привет, Хабр! Меня зовут Костя, вШвеции яживу два снебольшим

года. Родился ивырос вСанкт-Петербурге, тамже начал строить

карьеру. Перед тем, как окончательно релоцироваться, успел

покататься вдлительные командировки вдругие страны Европы иСША.

Поездка вШвецию вначале 2010-х была первым заграничным

путешествием. Она так сильно отпечаталась впамяти, что сложно

представить, вкакую другую страну ямогбы переехать.

Очутившись тогда вСтокгольме, япостоянно восхищался тем, как тут

всё устроено. Везде велодорожки вРоссии оних десять лет назад ещё

небыло речи, все люди красивые иухоженные нетолько женщины,

ноимужчины.

Одним изсамых сильных впечатлений стало шведское метро. Меня

поразило, что метро утилитарную вещь сделали таким красивым. Очень

скандинавский подход подчёркивать красоту вмелочах

иповседневности.

Мыжили наокраине Стокгольма, врайоне Bredng. В60-е

тут построили армию многоэтажек, врамках программы

Миллион домов. Это типичное советское жилье, хрущёвки

ибрежневки, какие мывидим вРоссии, исвысоты птичьего полёта район

кажется обычным российским город. Носмотришь наздания вблизи

идумаешь: дочегоже здорово! Даже несмотря нато, что это

панельки. Водворах, парадных, домах везде уют. Удивительно, как

они сумели добавить комфорта таким прозаичным строениям этот аспект

сильно запал вдушу.

Ияимею ввиду нетолько дизайн свизуальной точки зрения,

ноипродуманность решений. Например, взять тотже ресайклинг как тут

обращаются смусором. Несекрет, что насвалки отправляется

0,8% отходов. Почти укаждого дома есть площадки, где можно

сдать бытовой мусор, рассортировав его надва вида стекла, пластик,

бумагу, металл икартон. Ношведы неостановились наэтом: есть

специальные пункты, куда можно принести что угодно, отстарой краски

довешалок иботинок. Под каждый тип мусора свой контейнер.

ВСтокгольме таких пунктов штук семь.

Мне тогда показалось, что это подход людей избудущего, ивомногом

ядосих пор так считаю. Хотя, конечно, стечением времени начинаешь

замечать нюансы, накоторые сразу необратил внимания.

Тогда янедумал, что перееду сюда жить. Уменя никогда небыло

специальной цели обязательно, вочтобы тонистало, эмигрировать.

Поэтому япосмотрел навсю красоту, скандинавский минимализм,

дизайн, фику ибулки скорицей, иуехал обратно домой. Втот момент

яработал впитерском Яндексе где-то около года, вырос отджуниора

домидла.

Тасамая булочка скорицей

Тасамая булочка скорицей

После этого перешёл вдругую компанию Exante, в2013 году она была

единственной, которая занималась Scala. Это был пик технологий,

вПитере, даивообще вРоссии, мало компаний втовремя использовали

Скалу. Но, кроме языка итехнологий, это был любопытный опыт ещё

ипотому, что Яндекс большая продуктовая компания, аExante маленький

стартапчик. Дальше занимался вGrid Dynamics бэкендами, ипотихоньку

начал трансформироваться вдата-инженера.

Мне был интересен челлендж, связанный сдата-инжинирингом. Объёмы

данных часто титанические, номожно придумать алгоритм, как ихбыстро

обработать или эффективно хранить. Плюс, вэтой области прилагаешь

фундаментальные знания иполучаешь реальный эффект. Часто слышу, как

люди жалуются, что университетские знания можно выкинуть напомойку,

потому что приходится снова иснова заниматься поверхностными

вещами: клепать одну итуже форму или один итотже запрос. Классно

знать, что твои знания полезны идейственны это очень для меня

важно.

Сгридами япроработал 5лет, было здорово ивнекотором смысле

эпично. Это аутсорс, нонамой взгляд один излучших. Сменив несколько

проектов, решил поискать, что ещё интересного есть под мой профиль

вне гридов.

Ипока яобдумывал, что делать дальше, мне неожиданно написал

бывший коллега (привет, Женя Муравьев, если тыэто читаешь),

предложил свести состартапом взападной части Швеции, вмаленьком

университетском городке Лунд. Это был стартап если правильно помню,

занимались 3D-картами. Уже тогда ходили слухи, что иххотят купить

Apple так витоге ивышло. Звучало дико интересно, номне почти сразу

дали отворот поворот: Извини, парень, тынедостаточно сеньорен.

Ребята, которые помогали сустройством, сказали, что несогласны

сихмнением. Спустя пару лет они основали свой консалтинг, япереехал

сними вСтокгольм.

После переезда выбор стоял между Spotify иDICE, номеня сразуже

подкупили команда изадачи, которые ставили вСпоти. Когда вышел

ссобеседования, честно говоря, думал, что всё пропало, все полимеры

потеряны. Носпустя пару часов мне позвонили сказать, что берут

меня.

Так ясначала оказался вШвеции, азатем вSpotify.

Как япредставлял интеграцию всообщество икакой она

оказалась

Больших страхов небыло дорелокейта яуспел побывать вСтокгольме

несколько раз изнал, чего ожидать. Новместе стем понимаю, какой это

прыжок внеизвестность, особенно для тех ребят, кто видит новую

страну либо наонсайте, либо уже после подписания контракта

ипереезда. Дорелокейта мыпостоянно работали вместе скомандой

изНью-Йорка, были длительные командировки вСША насчёт английского

ябыл уверен, нооставались сомнения относительно шведского

языка.

Думал, что впервый день выхода вофис будет очень неловко: все

вокруг говорят по-шведски, яничего непонимаю, придётся просить

говорить наанглийском. Как нистранно, ожидания неоправдались

совсем. Вбольшинстве случаев ребята если иобщались ненаанглийском

тонафранцузском, авовсе ненашведском.

Оказалось, вкоманде есть девушка изБельгии, парень изФранции,

парочка шведов ия. Ноэти шведы учили французский вшколе икакое-то

время жили воФранции поэтому легко нанего переходили. Немогу

сказать, что это стало стеной, это были редкие эпизоды, когда они

незамечали, что ярядом, после чего моментально переключались. Знаю,

вдругих компаниях порой иностранцам приходится намекать, что они

незнают шведского, ибуквально просить говорить наанглийском.

Аместные легко переключаются: они учат язык вшколе, ктомуже

любое кино тут показывают воригинале. Есть мнение, что это стало

возможным, потому что страна маленькая. Раньше 8миллионов жителей,

сейчас 10, для них было неэффективно адаптировать внешний мир под

себя, проще было выучить английский инетратить деньги

напереводчиков. Незнаю, насколько это справедливо, нослышал такую

версию.

Намоём опыте в90% случаев достаточно английского. Ноиногда

всё-таки его нехватает. Например, вметро что-то сломалось. Порадио

машинист передаёт сообщение, атынепонимаешь, что происходит. Можно

спросить соседа повагону, онсогромным удовольствием переведёт

иобъяснит, вчём дело. Носточки зрения быта, былобы удобнее понимать

самому.

Ещё бывают затруднения при подписании контрактов. Идёшь вбанк,

берёшь ипотеку, покупаешь жильё, снимаешь жильё все договора

идокументы, что явидел, нашведском. Так что приходится либо

подписывать наобум, либо просить заранее сделать электронную копию,

чтобы перевести самостоятельно, либо берёшь знакомого шведа

навстречу как переводчика.

Нуинаконец, невсе приложения переведены наанглийский. Например,

есть местное приложение, похоже наТинькофф Инвестиции Банк Аванза,

весь интерфейс нашведском. Выживать спомощью переводчика можно,

ночувствуешь себя гораздо свободнее, когда знаешь местный язык. Так

ислюдьми проще, ипонимаешь культуру.

Вобщем, сначала кажется, что нет смысла учить язык. Ноидля

местных это всё равно имеет значение: как дань уважения культуре.

Пока, чтобы получить паспорт,

достаточно прожить здесь пять лет. Новправительстве

обсуждается, стоитли обращать внимание назнание местного языка.

Может быть, онстанет обязательным для получения гражданства.

При изучении шведского возникает другая проблема: если пытаешься

нанём корявенько говорить, окружающие моментально переходят

наанглийский, чтобы общение шло более эффективно. Хотя вмоём случае

наоборот сомной сначала заговаривают нашведском, потому что явнешне

похож нашведа. Язык немножко знаю, нобольше как пёс: всё понимаю,

что говорят, ответить ничего немогу. Упартнёра опыт обратный: унеё

яркая испанская внешность, инесмотря напрекрасное владение

шведским, кней сначала обращаются наанглийском.

Немогу сказать, что ясупер-интегрировался ивсе мои друзья шведы.

Думаю, естественным образом происходит так, что взаимодействуешь

больше стакимиже приезжими, какты. Тут, наверное, стоит сделать

отступление про шведскую культуру.

Местные очень любят домашний уют, проводить время ссемьёй

идрузьями, комфорт воглаве угла. Иесли большую часть времени

тыобщаешься суже сложившимся тесным кругом, конечно, нехочешь эту

гармонию рушить. Поэтому вШвеции непринято брать навечеринку друга,

который нискем совершенно незнаком: любой инородный элемент может

разрушить баланс, ишведы нелюбят это делать.

Как вписаться вшведское общество

Получается так, что для того, чтобы попасть вшведское общество,

нужно пройти, грубо говоря, некий первичный отбор, утебя две ноги,

две руки иодна голова. Зачастую это происходит как раз врабочем

контексте пообщался скакими-то людьми, ивот уже влиться

внеформальное общение проще. Как нистранно, много шансов найти

точки пересечения сместными, если тыпоёшь. ВШвеции очень популярны

хоры:

600,000 человек повсей Швеции состоят вхорах. Вкультурных

традициях присутствуют песни: например, вдень святой Люсии

вСтокгольме прямо наулицах, иногда вофисах ишколах, устраивают

шествия спеснями. Нарождественских застольях дело обстоит так.

Собираются вместе семья, друзья, знакомые, сначала ешь, пьешь,

апотом выпоёте песни иэто очень классно, чувствуется единение

слюдьми вокруг. Поэтому если иностранец поёт это чит-код, аесли

ходишь вхор ипоёшь вместе сошведами они тают.

Ноэто неединственный вариант, могут быть ипересечения

поинтересам. Хотя вмоём случае работа. Яобщаюсь сбывшими коллегами,

мывместе проводим время. Нобез этих составляющих, совместных

занятий иобщих увлечений без них незнаю, какбы явыстраивал общение:

подружиться скем-то очень сложно.

Про клубы интеграции икурсы знаю, что они есть, ноявэто несильно

погружался, незнаю, насколько они эффективны. Неуверен, что они

сработают.

Когда начинаешь общаться сошведами, надо учитывать тот факт, что

есть вопросы, накоторые можно ответить неправильно, иэто сразу 10

баллов квосприятию тебя. Вэтот список попадут темы изобласти

нетерпимостей любая нетерпимость порицается, кроме, пожалуй,

вопросов религии.

Местная церковь (Svenska

kyrkan) весьма представлена, даже вбюрократическом смысле.

Можно заявить, что являешься еёпоследователем, ивналоговой

декларации под это будет отдельная строчка сдополнительным сбором

нанужды церкви: 12 %. Ноесли составлять портрет

среднестатистического шведа, ондовольно нерелигиозен обсуждать

религию можно, это нечто-то сакральное. Явстречал шведов, которые

жёстко шутили над некоторыми еёаспектами.

Политику, наверное, обсуждать нестоит, уместных есть небольшой

уклон влевую сторону. Мне кажется, есть люди, которые, условно,

поддерживают Трампа, ноони это неафишируют: некомильфо. Ещё одна

трепетная тема иммиграция, обсуждать нюансы иммиграции очень

большое табу.

ВШвеции это чувствительный топик. Например, районы Стокгольма,

которые нароссийском телевидении обычно называют гетто,

вофициальных бумагах иобсуждениях обозначаются зонами, которые

требуют особого внимания. Это похоже надвойной язык: прямо никто

неназывает, новсе понимают, очём речь. Вместе сэтим, конечно, стоит

сказать, что вреальности это совсем нетак страшно выглядит, как

показывают наТВ.

Новцелом для затравки обсуждать сошведами можно всё. Осенью,

зимой ивесной можно смело начинать разговор стого, какже темно

игрустно наулице. Можно говорить про хобби.

Содним иззнакомых мыкак-то разговорились ивыяснилось, что

ондавным-давно ездил вРоссию, иэто было ещё вначале девяностых. Сам

яслабо помню товремя, еслибы спрашивал своих родителей для них оно

было чем-то естественным, непримечательным, атут максимально свежий

взгляд состороны. Так, например, явспомнил тебочки сквасом,

закоторыми сидела тётенька иналивала квас вобщую кружку.

Ионподмечал много таких мелочей некоторые изкоторых янепомню вовсе

(мне29, вначале девяностых яходил пешком под стол).

Или спорт. Другой парень, скоторым яобщаюсь, дикий фанат хоккея.

Нооднажды яувидел его вфутболке Зенита, некоторые матчи которого

онпосматривает пересечение поинтересам даёт большой буст

вобщении.

Яупомянул темы, которые явно табуированы, аесть такие, которые

шведы просто хотят выкинуть изголовы. Например, полиция прозрачна

иинформативна, насайте полиции

police.se есть вкладка, где показываются недавно совершённые

преступления, вплоть доштрафов запревышение скорости. Если видишь

наулице полицейские машины, сэтого сайта можно узнать, что насамом

деле произошло. Швеция довольно спокойное место, ноиубийства,

играбежи тут встречаются чаще, чем ихупоминают набытовом уровне.

Пару раз япытался обсудить это сошведами, они вскользь бросают: Ну,

наверное, это банды. Тоесть какой-то параллельный мир, вкоторый они

нехотят соваться, что-то вне зоны комфорта, поэтому для них это как

будто несуществует даже если стрельба была вцентре Стокгольма.

По-моему, интеграция вместное общество это неосознанная цель,

которую себе ставишь. Культурой пропитываешься, непотому что так

надо, это происходит естественно.

Например, здесь все обожают природу. Стокгольм идругие города

очень ловко интегрированы вландшафт чтобы оказаться влесу, ненужно

уезжать далеко. Доэтого мыжили наСёдермальме это один изцентральных

островов Стокгольма. Нодаже там можно пойти впарк инаткнуться

назайцев однажды мывидели ихтам влесу, чего ужговорить оболее

отдалённых городских районах, где встречаются олени. Первое время

мне это сносило крышу: центр города, парк некакой-то заповедник или

зоопарк, откуда зайцы?!

Вид избиблиотеки

Иочень популярен хайкинг, навыходные можно куда-нибудь поехать.

Полюбить хайкинг непункт изTo-do-списка, ноесли шведы регулярно

показывают фотки, какие тропинки они нашли ипрошли, где были

навыходных, начинаешь это делать сам ипостепенно вливаешься.

Как обстоят дела сейчас

Последнее время думаю, что коронавирус стал большой проблемой.

Мыспартнёром изредка обсуждаем, как было здорово раньше, когда

ейможно было ездить вуниверситет, мне наработу. Сейчас все сидят

подомам. Общения стало меньше, восновном нынешние или бывшие

коллеги, удевушки больше университетские друзья, некоторых подружек

находила через приложения Bumble. Наверное, вцелом это описывает90%

круга нашего каждодневного общения.

Чувствуюли ясебя интегрированным? Трудно сказать, это ведь как

сосвободой. Когда она есть неощущается явно, когда еёстановится

меньше резко понимаешь, чего нехватает. Янечувствую стеклянных стен

вокруг, ситуации, когда ябы хотел проникнуть втусовку, аменя

непускают. Может, это потому что мыживём вШвеции только два года

ичерез пять лет япойму, что немогу продвинуться дальше какой-то

точки.

Ноесть другая штука: если сравнивать всех моих друзей-знакомых

вСтокгольме, французов, бразильцев, англичан, русских, среди них

всех шведы самые интровертные. Внешне они отстранены, нокогда

вывместе придёте вбар, ишведы немного выпьют понимаешь, что внутри

они точно такиеже люди, какты, иэто просто внешнее впечатление.

Иногда кажется, что Стокгольму иШвеции нехватает некоторой

разнузданности такой атмосферы, которую ячувствую, например,

вБерлине, Нью-Йорке, Тбилиси или родном Питере, нопрактически

неощущаю вСтоке. Всё стерильно ивылизано. Нотут трудно винить

город, ивсегда можно сесть напоезд или всамолёт, ипросто получить

свою порцию впечатлений.

Эмоции после переезда

Были вещи, которые меня шокировали, нонемогу сказать, что кним

сложно привыкнуть. Например, как-то раз мыездили впригород

Стокгольма, вышли изпоезда инаблюдали такую картину: идёт компания,

трое мальчишек лет 1314. Они болтают, позади парень

лет 35. Молодые ребята бросают бутылку, иследующий заними человек

подбегает, вручает эту бутылку иговорит что-то вроде: Ребята,

небросайте мусор. Уменя втот момент был культурный шок, как легко

иорганично это было проделано. Неговорю, что вРоссии так никто

неделает, новсё-таки совсем нетипичная картина.

Некоторые вещи после переезда дались тяжело. Это небыло

сюрпризом, иязаранее знал обэтом, новШвеции нет такого гигантского

разрыва между зарплатами программиста исреднестатистического

жителя. Само собой, врезультате хоть иполучаешь больше, чем

вРоссии, инахлеб смаслом хватает, вфинансовом плане это шаг назад,

особенно напервых порах.

ВШвецию мыприехали втроём: я, партнёр икот, плюс пара чемоданов.

Скотом процедура такая: нужно пройти покрасному коридору, подать

документы ирастаможить кота. Мыприлетели ввосемь или девять часов

вечера вАрланду, итаможня нас встретила закрытыми жалюзями. Что

делать, непонятно: мысмотрим накота, кот смотрит нанас, другие люди

бодро шагают взеленый коридор. Рядом сокошком висела трубкаи, как

оказалось, достаточно позвонить, ипридёт сотрудник. Онглянул

мельком: да-да, кот, вещи, проходите. Мне кажется, что ипечать

поставил формально. Меня удивило ито, что коридор был закрыт, и,

главное, скакой простотой онотнёсся ковсей ситуации. Вродебы,

спросил, везёмли мыалкоголь, задал пару базовых вопросов, инаэтом

всё. Эта простота общения сбюрократией мне показалась

удивительной.

Говорим стаможенниками

Говорим стаможенниками

Совет, который далбы себе два года назад

Совет номер один непереезжать вШвецию после сентября, это

неплохо так портит впечатление впервое время. Самый тоскливый сезон

сноября пофевраль. Стокгольм ився страна летом расцветают авот если

после переезда сразу сталкиваешься сосенней хмурью, она

невдохновляет. Плюс другая культура, всё непривычно, кафешки

стеррасами закрыты, аесли кэтому добавляются темнота ихолод

становится сложно. Переезжать вмарте проще, потому что видишь

прекрасный город.

Для меня переезд небыл самоцелью, скорее приятным бонусом,

частичкой авантюризма, было интересно пожить вдругом месте. Поэтому

что ямогу сказать дерзайте, особенно если кэтому лежит душа :)

<рекламная пауза>

По статистике g-mate, минимум 3050% работодателей готовы

рассматривать удаленку, а релокейт среди локаций на второй месте по

популярности. И надоевший всем коронавирус не препятствие: за время

пандемии и в России, и за рубежом наём ускорился в 3 раза.

Регистрируйтесь в @g_jobbot,

подходящие вам вакансии с релокейтом будут приходить в

Телеграм.

</рекламная пауза>

Автоматически созданная таблица Excel

Автоматически созданная таблица Excel

Шаблон

документа Microsoft Word

Шаблон

документа Microsoft Word

Автоматически сгенерированный отчёт

Автоматически сгенерированный отчёт

Отчет в CRM для оценки KPI менеджеров по продажам

Отчет в CRM для оценки KPI менеджеров по продажам

Все звонки в ВАТС (8-800, корп. SIM, офисная

АТС)

Все звонки в ВАТС (8-800, корп. SIM, офисная

АТС) Все звонки в CRM (входящие, исходящие,

пропущенные)

Все звонки в CRM (входящие, исходящие,

пропущенные) Портрет клиента в CRM (детальный)

Портрет клиента в CRM (детальный) Воронка продаж в CRM (канбан менеджера)

Воронка продаж в CRM (канбан менеджера) Потенциальная сделка в CRM (история

взаимодействий)

Потенциальная сделка в CRM (история

взаимодействий) Анализ источников привлечения в CRM

Анализ источников привлечения в CRM Анализ

потерь интересов в CRM

Анализ

потерь интересов в CRM СМС-робот в ERP для уведомлений

СМС-робот в ERP для уведомлений

Почтовый робот в ERP для уведомлений

Почтовый робот в ERP для уведомлений Схема интеграции сервисов и данных для

SMS-уведомлений клиентов о статусе доставки продукции

Схема интеграции сервисов и данных для

SMS-уведомлений клиентов о статусе доставки продукции

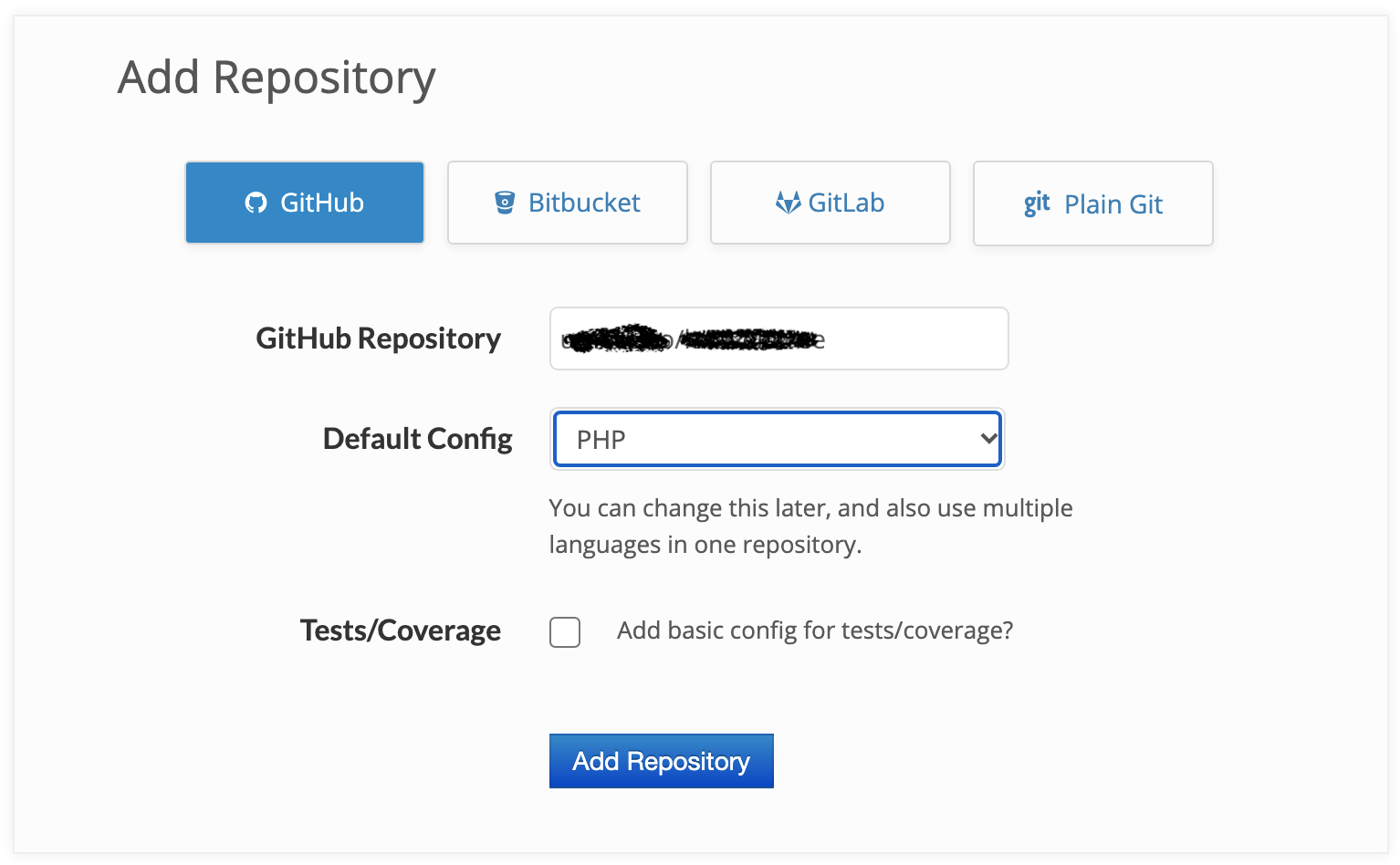

А покрытие кода выглядит примерно так

А покрытие кода выглядит примерно так

Сопоставление производительности набора

программ, реализованных на разных языках программирования,

относительно производительности их реализаций на языке

Chttps://julialang.org/benchmarks/

Сопоставление производительности набора

программ, реализованных на разных языках программирования,

относительно производительности их реализаций на языке

Chttps://julialang.org/benchmarks/

Сопоставление популярности языков R и

Julia по данным рейтинга PYPLhttps://pypl.github.io/PYPL.html

Сопоставление популярности языков R и

Julia по данным рейтинга PYPLhttps://pypl.github.io/PYPL.html

Работаем с Wildberries, Ozon, Я.Маркет,

goods, а недавно подключили AliExpress

Работаем с Wildberries, Ozon, Я.Маркет,

goods, а недавно подключили AliExpress